Hochleistungsrechnen Marktgröße und Marktanteil

Hochleistungsrechnen Marktanalyse von Mordor Intelligence

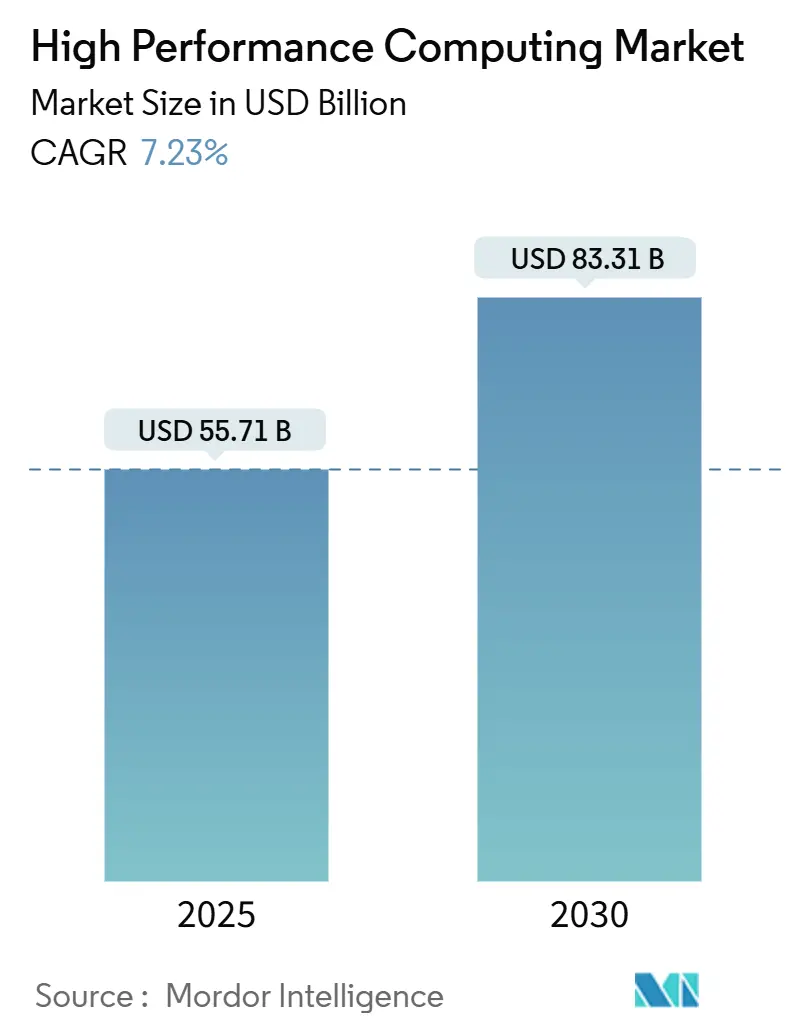

Die Marktgröße für Hochleistungsrechnen wird auf USD 55,7 Milliarden im Jahr 2025 geschätzt und soll bis 2030 USD 83,3 Milliarden erreichen, mit einem Wachstum von 7,23% CAGR. Das Momentum verschiebt sich von reiner wissenschaftlicher Simulation hin zu KI-zentrischen Arbeitslasten, sodass die Nachfrage zu GPU-reichen Clustern übergeht, die Grundlagenmodelle trainieren können, während sie gleichzeitig physikbasierte Codes ausführen. Souveräne KI-Programme ziehen Regierungskäufer in direkten Wettbewerb mit Hyperscalern um dieselben beschleunigten Systeme, was die Lieferung verknappt und die Attraktivität flüssigkeitsgekühlter Architekturen verstärkt, die dichte Leistungshüllen bändigen. Hardware verankert nach wie vor Beschaffungsbudgets, dennoch steigen verwaltete Dienstleistungen und HPC-as-a-Service schnell an, da Organisationen Pay-per-Use-Modelle bevorzugen, die unvorhersehbaren KI-Nachfragekurven entsprechen. Parallele Markttreiber umfassen breitere Adoption hybrider Bereitstellungen, beschleunigte Lebenswissenschafts-Pipelines und wachsende Nachhaltigkeitsmandate, die Rechenzentrum-Neugestaltungen erzwingen.

Wichtige Berichtserkenntnisse

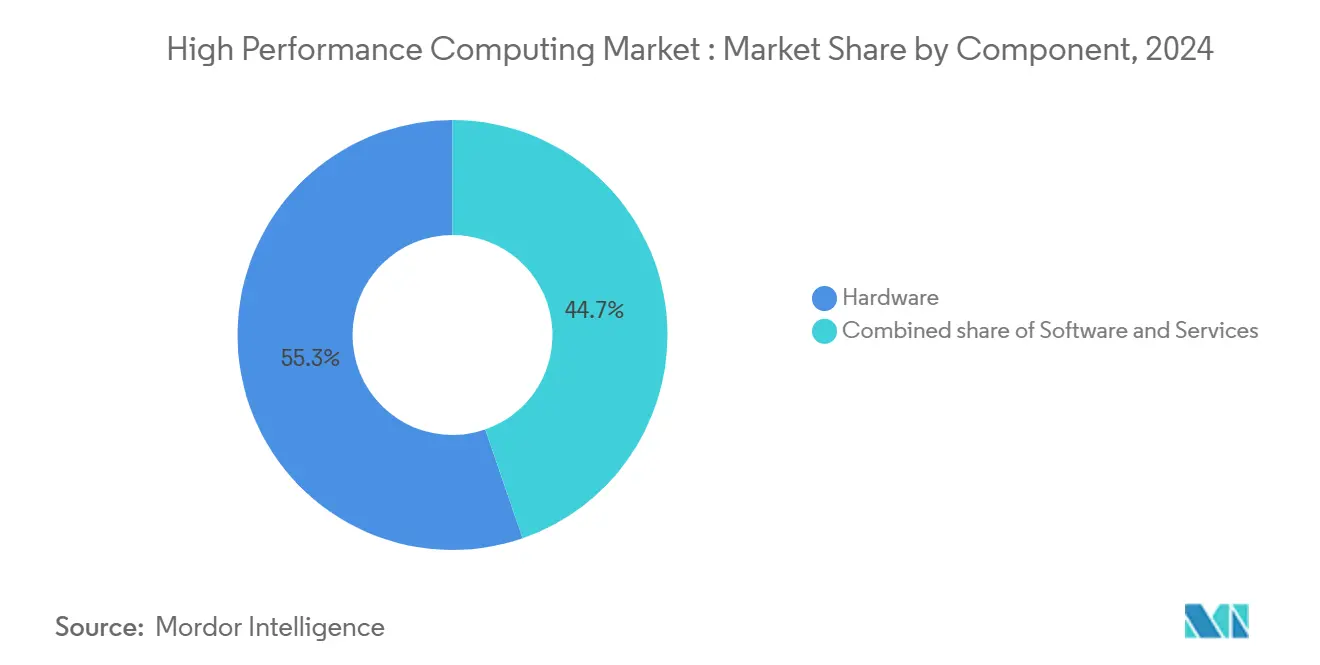

- Nach Komponente führte Hardware mit 55,3% Umsatzanteil in 2024; Dienstleistungen werden voraussichtlich mit 14,7% CAGR bis 2030 expandieren.

- Nach Bereitstellungsmodus hielten Vor-Ort-Umgebungen 67,8% des Hochleistungsrechnen Marktanteils in 2024, während cloudbasierte Systeme mit 11,2% CAGR bis 2030 wachsen werden.

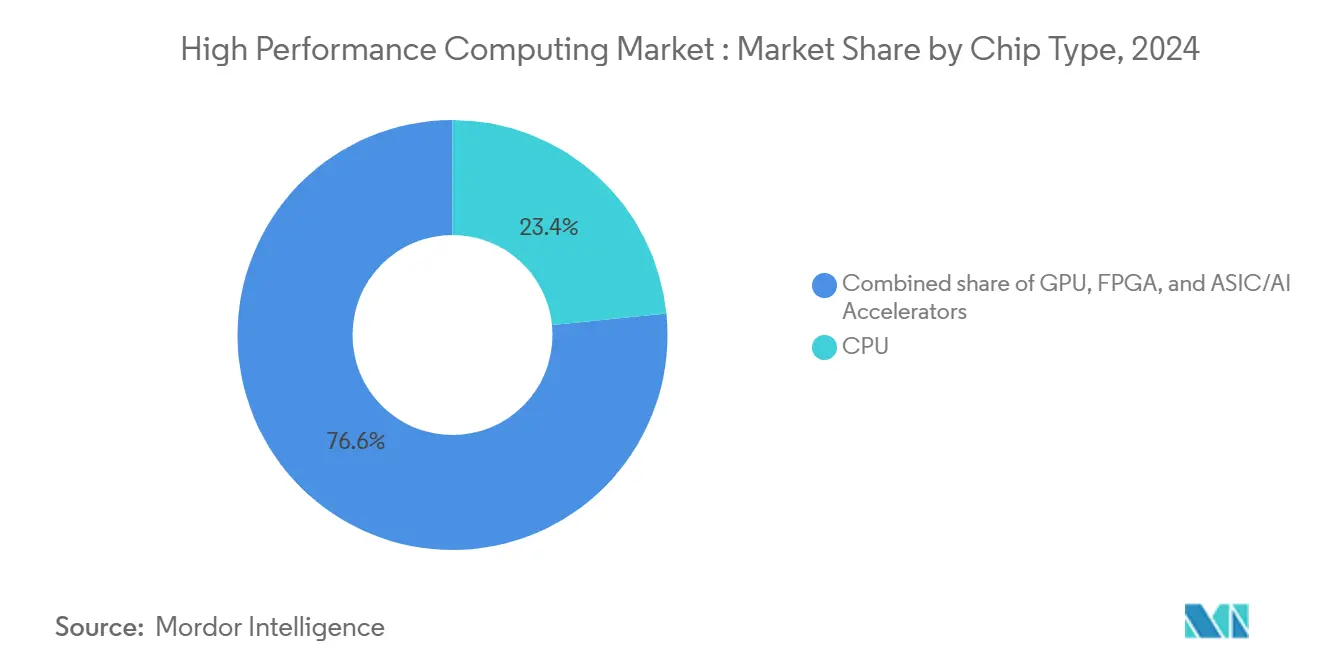

- Nach Chip-Typ führten CPUs mit 23,4% Anteil in 2024, während GPUs mit 10,5% CAGR bis 2030 skalieren

- Nach industrieller Anwendung eroberte Regierung & Verteidigung 24,6% Anteil in 2024; Lebenswissenschaften & Gesundheitswesen schreitet mit 12,9% CAGR bis 2030 voran.

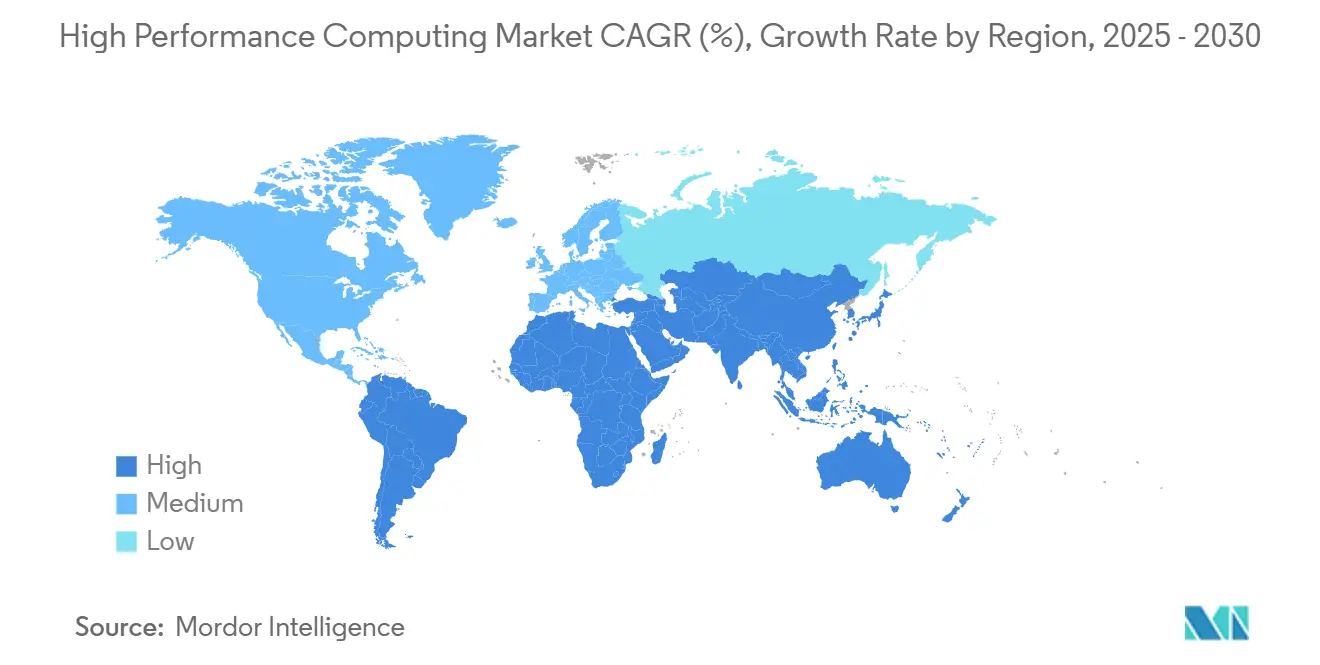

- Nach Geographie hielt Nordamerika 40,5% der Hochleistungsrechnen Marktgröße in 2024; Asien-Pazifik zeigt die schnellste Entwicklung mit 9,3% CAGR.

Globale Hochleistungsrechnen Markttrends und Einblicke

Treiber-Auswirkungsanalyse

| Treiber | (~) % Auswirkung auf CAGR-Prognose | Geografische Relevanz | Auswirkungszeitrahmen |

|---|---|---|---|

| Die Explosion von KI/ML-Trainings-Arbeitslasten in US-Bundeslaboren & Tier-1-Cloud-Anbietern | +2.1% | Nordamerika, mit Auswirkungen auf Europa und Asien-Pazifik | Mittelfristig (2-4 Jahre) |

| Steigende Nachfrage nach GPU-beschleunigter Molekulardynamik in asiatischen Pharma-Outsourcing-Zentren | +1.8% | Asien-Pazifik-Kern, insbesondere Indien, China und Japan | Langfristig (≥ 4 Jahre) |

| Obligatorische Automotive-ADAS-Simulations-Compliance in EU EURO-NCAP 2030 Roadmap | +1.2% | Europa primär, Nordamerika sekundär | Mittelfristig (2-4 Jahre) |

| Nationale Exascale-Initiativen treiben indigene Prozessor-Adoption in China & Indien voran | +1.5% | Asien-Pazifik, mit strategischen Auswirkungen global | Langfristig (≥ 4 Jahre) |

| Quelle: Mordor Intelligence | |||

Die Explosion von KI/ML-Trainings-Arbeitslasten in US-Bundeslaboren & Tier-1-Cloud-Anbietern

Bundeslabore gestalten nun Beschaffungen um gemischte KI- und Simulationskapazitäten, was die adressierbare Spitzenleistungsnachfrage im Hochleistungsrechnen Markt effektiv verdoppelt. Das Gesundheitsministerium formulierte KI-bereite Rechenleistung als Kernstück seiner 2025-Forschungsstrategie und spornte Labore an, GPU-dichte Knoten zu kaufen, die zwischen Exascale-Simulationen und 1-Billion-Parameter-Modelltraining pivotieren.[1]Department of Health and Human Services, "Strategic Plan for Artificial Intelligence 2025," hhs.gov Das Energieministerium sicherte sich USD 1,152 Milliarden für KI-HPC-Konvergenz im Haushaltsjahr 2025.[2]Office of Scientific and Technical Information, "FY 2025 Budget Request," osti.gov Tier-1-Clouds reagierten mit souveränen KI-Zonen, die FIPS-validierte Sicherheit und fortgeschrittene Beschleuniger verbinden, und Branchenbeobachter schätzen, dass 70% der KI-Infrastruktur-Ausgaben im ersten Halbjahr 2024 an GPU-zentrische Designs gingen. Der Hochleistungsrechnen Markt profitiert folglich von einem strukturellen Anstieg des High-End-Systemwerts, aber Komponentenengpässe verstärken Preisvolatilität. Anbieter bündeln nun Flüssigkeitskühlung, optische Interconnects und Zero-Trust-Firmware, um Bundesaufträge zu gewinnen und gestalten den Kanal neu.

Steigende Nachfrage nach GPU-beschleunigter Molekulardynamik in asiatischen Pharma-Outsourcing-Zentren

Auftragsforschungsorganisationen in Indien, China und Japan skalieren DGX-Klasse-Cluster, um den Weg von Leitverbindungen zur Klinik zu verkürzen. Tokyo-1, das 2024 von Mitsui & Co. und NVIDIA angekündigt wurde, bietet japanischen Arzneimittelherstellern dedizierte H100-Instanzen, die für biomolekulare Arbeitslasten maßgeschneidert sind.[3]Mitsui & Co., "Tokyo-1 Supercomputer Launch," iptonline.com Indiens CRO-Sektor, der bis 2030 USD 2,5 Milliarden bei einer 10,75% CAGR erreichen soll, schichtet KI-getriebene Zielidentifikation über klassische Dynamik und verstärkt die Nachfrage nach cloud-geliefertem Supercomputing. Forscher treiben nun GENESIS-Software voran, um 1,6 Milliarden Atome zu simulieren und Erforschung großer Protein-Interaktionen zu eröffnen. Diese Fähigkeit verankert regionale Führerschaft in ausgelagerter Entdeckung und verstärkt Asien-Pazifiks Zug auf globale Beschleuniger-Versorgungslinien. Für den Hochleistungsrechnen Markt fungieren Pharma-Arbeitslasten als antizyklische Absicherung gegen zyklische Fertigungsnachfrage.

Obligatorische Automotive-ADAS-Simulations-Compliance in EU EURO-NCAP 2030 Roadmap

Neue europäische Protokolle verlangen von OEMs, Millionen virtueller Fahrszenarios zu beweisen, wodurch digitale Validierung zum neuen Goldstandard wird. Die NHTSA-Roadmap vom November 2024 spiegelt diese Erwartung wider und signalisiert globale Harmonisierung um simulationsbasierte Sicherheitsnachweise.[4]NHTSA, "NCAP 2033 Roadmap," nhtsa.gov Siemens und andere Tool-Anbieter bündeln Szenario-Datenbanken, Physik-Solver und Sensorfusions-Modelle, die für GPU-Cluster optimiert sind. Hersteller bauen nun hauseigene Rechenfarmen, weil Cloud-Latenz Hardware-in-the-Loop-Zyklen behindern kann. Diese Regulierung injiziert stetige Nachfrage in den Hochleistungsrechnen Markt, konzentriert aber auch Kaufentscheidungen unter Automotive-Tier-Ones, die deterministische Latenz und vor-Ort-Datenverwahrung benötigen.

Nationale Exascale-Initiativen treiben indigene Prozessor-Adoption in China & Indien voran

Indiens National Supercomputing Mission setzte bis Dezember 2024 neun PARAM Rudra-Systeme ein und bereitet drei im September 2024 gestartete indigene Supercomputer vor. Chinas Telekom-Anbieter planen die Beschaffung von 17.000 KI-Servern im Wert von fast CNY 30 Milliarden (USD 4,1 Milliarden) von inländischen Anbietern und beschleunigen lokale Beschleuniger-Ökosysteme. Olas Krutrim-Einheit wird den ersten indischen KI-Chip bis 2026 zur Marktreife bringen. Diese Bewegungen fragmentieren traditionelle Lieferketten und stärken RISC-V- und ARM-Designs, reduzieren westliche Incumbents' Exportvolumen, während sie den globalen Hochleistungsrechnen Markt insgesamt vergrößern.

Restriktionen-Auswirkungsanalyse

| Restriktion | (~) % Auswirkung auf CAGR-Prognose | Geografische Relevanz | Auswirkungszeitrahmen |

|---|---|---|---|

| Globaler Mangel an HBM3e-Speicher begrenzt GPU-Server-Lieferungen 2024-26 | -1.8% | Global, mit besonderer Auswirkung auf Asien-Pazifik-Fertigung | Mittelfristig (2-4 Jahre) |

| Eskalierende Rechenzentrum-Wasserverbrauchsbeschränkungen in dürregefährdeten US-Staaten | -1.4% | Nordamerika primär, mit Auswirkungen auf globale Rechenzentrum-Standortwahl | Kurzfristig (≤ 2 Jahre) |

| Ultra-niedrige-Latenz Edge-Anforderungen untergraben zentralisierte Cloud-Ökonomie | -0.8% | Global, mit Schwerpunkt auf entwickelten Märkten | Mittelfristig (2-4 Jahre) |

| Quelle: Mordor Intelligence | |||

Eskalierende Rechenzentrum-Wasserverbrauchsbeschränkungen in dürregefährdeten US-Staaten

Gesetzgebung in Virginia und Maryland erzwingt Offenlegung des Wasserverbrauchs, während Phoenix Microsofts wasserfreie Kühlung testet, die 125 Millionen Liter pro Standort jährlich einspart. Versorgungsunternehmen begrenzen nun neue Megawatt-Anschlüsse, es sei denn, Betreiber verpflichten sich zu Flüssigkeits- oder Rear-Door-Wärmetausch. Kapitalausgaben können um 15-20% steigen, was Rentabilitätsschwellen im Hochleistungsrechnen Markt drückt und eine Verschiebung zu Immersions- oder kooperativen Luftsystemen fördert. Anbieter von Kaltplatten-Verteiler und dielektrischen Flüssigkeiten gewinnen daher Einfluss. Betreiber diversifizieren Standorte in kühlere Klimazonen, aber Latenz- und Datensouveränitätspolitiken beschränken Verlagerungsoptionen, sodass Designinnovation statt Verlagerung die Kühlwasser-Spannung lösen muss.

Globaler Mangel an HBM3e-Speicher begrenzt GPU-Server-Lieferungen 2024-26

HBM3e-Nachfrage übertrifft Wafer-Starts trotz Samsungs 12-hohen Stapeln und SK Hynix' Ramping der Interposer-Kapazität. Chinesische Käufer luden 2024-Bestellungen vor, um US-Exportkontrollen zuvorzukommen, was quartalsweise HBM-Umsätze um 70% steigen ließ. TSMCs CoWoS-Packaging-Rückstau verlängert GPU-Lieferzeiten und begrenzt High-End-Cluster-Lieferung bis Mitte 2026. Viele Integratoren liefern nun halb bestückte Speicherstapel, was Modell-Batch-Größe und Simulations-Gitterauflösung für Early Adopters begrenzt. Die Beschränkung reduziert die projizierte Hochleistungsrechnen Markt-CAGR um 1,8 Prozentpunkte, spornt aber auch Investitionen in alternative Speicherhierarchien wie CXL-attached DRAM-Pools an.

Segmentanalyse

Nach Komponente: Dienstleistungen treiben Transformation voran

Hardware machte 55,3% der Hochleistungsrechnen Marktgröße in 2024 aus und spiegelt anhaltende Ausgaben für Server, Interconnects und parallele Speicher wider. Verwaltete Angebote verzeichneten jedoch eine 14,7% CAGR und gestalteten Beschaffungslogik neu, da CFOs OPEX gegenüber abschreibenden Vermögenswerten bevorzugen. System-OEMs integrieren Metering-Hooks, sodass Cluster nach Node-Stunden abgerechnet werden können und Hyperscale-Cloud-Ökonomie nachahmen. Die Beschleunigung von KI-Inferenz-Pipelines fügt unvorhersehbare Burst-Nachfrage hinzu und drängt Unternehmen zu Verbrauchsmodellen, die gestrandete Kapazitäten vermeiden. Lenovos TruScale, Dells Apex und HPEs GreenLake bündeln nun Supercomputing-Knoten, Scheduler-Software und Service-Level-Agreements unter einer Rechnung. Anbieter differenzieren sich durch schlüsselfertige Flüssigkeitskühlung und Optik, die Bereitstellungszyklen von Monaten auf Wochen verkürzen.

Das Momentum der Dienstleistungen signalisiert, dass zukünftiger Wert sich auf Orchestrierung, Optimierung und Sicherheits-Wrapper konzentriert, anstatt auf Commodity-Motherboard-Zählungen. Unternehmen, die Finite-Elemente-Analyse oder Omics-Arbeitslasten migrieren, schätzen transparente Pro-Job-Kostenrechnung, die Rechennutzung mit Zuschussfinanzierung oder Fertigungsmeilensteinen ausrichtet. Compliance-Teams bevorzugen auch verwaltete Angebote, die Daten vor Ort halten, aber Spitzen in anbieter-betriebene Annex-Räume auslagern lassen. Der Hochleistungsrechnen Markt bewegt sich daher zu einem Spektrum, wo Bare-Metal-Kauf und vollständige Public-Cloud-Miete Endpunkte sind und Pay-as-you-go vor Ort in der Mitte sitzt.

Notiz: Segmentanteile aller einzelnen Segmente bei Berichtskauf verfügbar

Nach Bereitstellungsmodus: Hybrid-Modelle entstehen

Vor-Ort-Infrastrukturen hielten 67,8% des Hochleistungsrechnen Marktanteils in 2024, weil geschäftskritische Codes deterministische Latenz und enge Datengovernance erfordern. Dennoch wachsen cloud-residente Cluster mit 11,2% CAGR bis 2030, da beschleunigte Instanzen minutenweise einfacher zu mieten werden. Geteilte Souveränitäts-Frameworks lassen Behörden sensible Datensätze auf lokalen Festplatten behalten, während anonymisierte Arbeitslasten in kommerzielle Clouds ausgelagert werden. CoreWeave sicherte sich eine fünfjährige USD 11,9 Milliarden-Vereinbarung mit OpenAI und signalisiert, wie spezialisierte KI-Clouds sowohl öffentliche als auch private Kunden anziehen. Systemarchitekten gestalten nun software-definierte Fabrics, die Container nahtlos zwischen Standorten neu inszenieren.

Hybrid-Adoption wird wahrscheinlich zukünftig dominieren und Edge-Cache-Knoten, lokale flüssigkeitsgekühlte Racks und gemietete GPU-Pods verbinden. Interconnect-Abstraktionen wie Omnipath oder Quantum-2 InfiniBand ermöglichen dem Scheduler, physische Standorte zu ignorieren und jeden Beschleuniger als Pool zu behandeln. Diese Fähigkeit macht Arbeitsplatzierung zu einer Richtlinienentscheidung, die von Kosten, Sicherheit und Nachhaltigkeit angetrieben wird, anstatt von Topologie. Infolgedessen entwickelt sich der Hochleistungsrechnen Markt zu einem Netzwerk föderierter Ressourcen, wo Beschaffungsstrategie sich auf Bandbreiten-Ökonomie und Daten-Egress-Gebühren konzentriert, anstatt auf Capex.

Nach Chip-Typ: GPU-Momentum baut sich auf

CPUs lieferten 23,4% des 2024-Umsatzes dank skalarer Codes, die speicherbandbreitengebunden bleiben, dennoch steigen GPUs mit 10,5% CAGR, da Transformer-Modelle dominieren. NVIDIA verzeichnete USD 22,563 Milliarden Rechenzentrum-Verkäufe in Q1 FY 2026, angetrieben von Hopper-Klasse-Beschleunigern. AMD überschritt USD 3,7 Milliarden Rechenzentrum-Umsatz in Q1 2025 und spiegelt starke Instinct MI300-Bereitstellungen wider. Unterdessen schwenkt Intel auf Gaudi-3 und Foundry-Services für externe Designer um. Der Hochleistungsrechnen Markt schätzt nun heterogene Architekturen, die CPU, GPU und spezialisierte ASIC-Kacheln über Silizium-Photonik-Verbindungen verheiraten, über reine Peak-Floating-Point-Metriken.

Entwickler refaktorieren Legacy-MPI-Codes in CUDA-, SYCL- oder HIP-Kernel, um GPU-Beschleunigungen zu ernten, obwohl Speicherbeschränkungen der limitierende Faktor bleiben. Entstehende CXL-attached Pooling verspricht, Kapazität vom Beschleuniger-Package zu entkoppeln. Bis Mitte des Jahrzehnts wird Topologie-Flexibilität System-Wettbewerbsfähigkeit mehr definieren als Peak-Floating-Point-Metriken, und Anbieter, die Multi-Die-Kohärenz integrieren, werden überproportionale Wallet-Anteile erobern.

Notiz: Segmentanteile aller einzelnen Segmente bei Berichtskauf verfügbar

Nach industrieller Anwendung: Lebenswissenschaften beschleunigen

Regierung & Verteidigung behielten 24,6% des 2024-Umsatzes, aber Lebenswissenschaften verzeichneten die schnellste 12,9% CAGR auf Basis KI-beschleunigter Arzneimittelentdeckung. Pharma-Nutzer kombinieren Large-Language-Modelle mit Molekulardynamik, um Verbindungsbibliotheken früh zu beschneiden. Lantern Pharmas RADR-Engines nehmen nun 100 Milliarden Datenpunkte auf, um genomische Signaturen zu priorisieren. Gleichzeitig wird Fujifilm die Antikörper-Produktionskapazität bis 2030 über 750.000 Liter anheben, unterstützt durch präzise Bioprozess-Simulationen. Regulierungsbehörden akzeptieren in-silico-Evidenz in IND-Einreichungen und zementieren Rechenleistung als Engpass weiter.

Traditionelle seismische Modellierung, CFD und Wetterforschung stellen weiterhin stetige Grundnachfrage dar, aber KI-zentrische Vertikale liefern inkrementelles Wachstum. Life-Sciences-as-a-Service-Konsortien beschaffen nun geteilte Exascale-Partitionen, sodass mittelständische Biotech-Firmen queued Runs einreichen können. Diese Struktur demokratisiert Zugang und erweitert den gesamten adressierbaren Hochleistungsrechnen Markt. Anbieter, die validierte Workflows für Omics, Cryo-EM und generative Arzneimitteldesign vorverpacken, erzielen schnellere Verkaufszyklen als jene, die Bare Iron liefern.

Geographie-Analyse

Nordamerika kommandierte 40,5% des Hochleistungsrechnen Marktes in 2024, da Bundesbehörden USD 7 Millionen in das HPC4EI-Programm für energieeffiziente Fertigung injizierten. Der CHIPS Act entfachte über USD 450 Milliarden private Fab-Verpflichtungen und schuf die Bühne für 28% des globalen Halbleiter-Capex bis 2032. Rechenzentrum-Stromverbrauch könnte bis 2030 auf 490 TWh steigen; dürregefährdete Staaten erlassen daher wasserneutrale Kühlungsgesetze, was neue Kapazitäten zu Immersions- und Rear-Door-Flüssigkeitsschleifen neigt. Hyperscaler beschleunigen selbstdesignte GPU-Projekte, verstärken regionale Dominanz, aber verschärfen lokale Versorgung mit HBM-Modulen.

Asien-Pazifik verzeichnet die stärkste 9,3% CAGR, getrieben von souveränen Rechen-Agenden und Pharma-Outsourcing-Clustern. Chinas Anbieter beabsichtigen den Kauf von 17.000 KI-Servern, hauptsächlich von Inspur und Huawei, was USD 4,1 Milliarden inländische Aufträge hinzufügt. Indiens neun PARAM Rudra-Installationen und kommender Krutrim KI-Chip bauen ein vertikal integriertes Ökosystem auf. Japan nutzt Tokyo-1, um klinische Kandidaten-Screening für große inländische Arzneimittelhersteller zu beschleunigen. Diese Investitionen vergrößern die Hochleistungsrechnen Marktgröße durch Paarung von Kapitalanreizen mit lokalem Talent und regulatorischen Mandaten.

Europa erhält Momentum durch EuroHPC, betreibt LUMI (386 Petaflops), Leonardo (249 Petaflops) und MareNostrum 5 (215 Petaflops), mit JUPITER als erste Exascale-Maschine der Region positioniert. Horizon Europe leitet EUR 7 Milliarden (USD 7,6 Milliarden) in HPC- und KI-F&E. Luxemburgs gemeinsame Finanzierung fördert Industrie-Academia-Co-Design für digitale Souveränität. Regionale Strompreis-Volatilität beschleunigt Adoption direkter Flüssigkeitskühlung und erneuerbarer Anpassung zur Betriebskostenkontrolle. Südamerika, Naher Osten und Afrika sind aufstrebend, investieren aber in seismische Modellierung, Klimaprognosen und Genomik und schaffen Greenfield-Gelegenheiten für modulare containerisierte Cluster.

Wettbewerbslandschaft

Etablierte Silizium-Anbieter behalten Skalenvorteile, dennoch intensiviert sich Wettbewerbsdruck, da Hyperscaler und spezialisierte Clouds proprietäre Stacks bauen. NVIDIA, AMD und Intel dominieren noch Beschleuniger-Umsatz, aber ihr Gesamtanteil wird langsam durch interne AWS Trainium- und Google TPU-Rollouts verwässert. Cloud-Anbieter verfolgen vertikale Integration zur Versorgungssicherung und Verbesserung der Kosten pro Training-Token, was traditionelle OEM-Verhandlungsmacht erodiert. Der Hochleistungsrechnen Markt sieht daher Ökosystem-Wettbewerb statt Komponenten-Rivalität.

Strategische Investitionen illustrieren diese Wende. NVIDIA, Intel und AMD finanzierten gemeinsam Ayar Labs zur Kommerzialisierung optischer I/O, die Chiplet-Level-Bandbreiten-Obergrenzen freischalten könnte. Applied Digitals Umsatz verdoppelte sich fast auf USD 43,7 Millionen in Q4 2024, gestärkt durch eine USD 160 Millionen Private Placement und eine 3% NVIDIA-Beteiligung, die seinen GPU-Colocation-Fokus legitimiert. CoreWeaves bevorstehender IPO, unterstützt durch einen Milliarden-Dollar-OpenAI-Vertrag, kristallisiert Marktappetit für Nischen-KI-Hyperscaler mit ex-Hochfrequenzhandel-Ingenieuren heraus.

Nachhaltigkeit entsteht als sowohl Differenzierungs- als auch Compliance-Notwendigkeit. HPEs direkt-flüssigkeitsgekühlter Cray EX unterstützt 224 Blackwell GPUs im lüfterlosen Modus, reduziert Facility-PUE und adressiert Wasserverbrauchskritik. Dell verpackt Rear-Door-Wärmetauscher als Standard und ermöglicht 80 kW-Racks ohne Kaltwasser-Schleifen. Da Regulatoren embodied Carbon prüfen, integrieren Lieferanten Lebenszyklus-Emissionsdaten in RFP-Antworten. In den nächsten fünf Jahren wird Wettbewerbsvorteil aus Lieferketten-Resilienz, integrierten Software-Stacks und Nachweis von Ressourceneffizienz entstehen, anstatt aus roher Benchmark-Führerschaft.

Hochleistungsrechnen Branchenführer

-

Advanced Micro Devices, Inc.

-

NEC Corporation

-

Hewlett Packard Enterprise

-

Qualcomm Incorporated

-

Fujitsu Limited

- *Haftungsausschluss: Hauptakteure in keiner bestimmten Reihenfolge sortiert

Aktuelle Branchenentwicklungen

- März 2025: CoreWeave stellte Antrag auf IPO nach 2024-Umsatz von USD 1,9 Milliarden und unterzeichnete einen fünfjährigen USD 11,9 Milliarden Infrastruktur-Deal mit OpenAI.

- Dezember 2024: Indiens Ministerium für Elektronik und IT bestätigte Bereitstellung von neun PARAM Rudra-Systemen unter der National Supercomputing Mission zum Aufbau heimischer Kapazitäten.

- November 2024: HPE führte lüfterlose flüssigkeitsgekühlte Cray EX-Systeme ein, die bis zu 224 NVIDIA Blackwell GPUs unterstützen, um energieeffizientes hochdichtes Computing zu adressieren.

- November 2024: Das US-Energieministerium vergab USD 7 Millionen für HPC4EI zur Finanzierung von 10 industriellen Effizienzprojekten in acht Staaten.

Globaler Hochleistungsrechnen Marktbericht Umfang

Der Hochleistungsrechnen (HPC) Markt ist definiert basierend auf den Umsätzen, die aus dem Verkauf von Hardware, Software und Dienstleistungen in verschiedenen industriellen Anwendungen wie Luft- und Raumfahrt und Verteidigung, Energie und Versorgung, BFSI, Medien und Unterhaltung, Fertigung, Lebenswissenschaften und Gesundheitswesen und anderen industriellen Anwendungen in Regionen wie Nordamerika, Europa, Asien-Pazifik, Lateinamerika und Naher Osten & Afrika generiert werden. Die Analyse basiert auf den durch Sekundärforschung und Primärdaten erfassten Markteinblicken. Der Bericht deckt auch die wichtigsten Faktoren ab, die das Marktwachstum in Bezug auf Treiber und Beschränkungen beeinflussen.

Der Hochleistungsrechnen (HPC) Markt ist segmentiert nach Komponente (Hardware [Server, Speichergeräte, Systeme, Netzwerkgeräte], Software und Dienstleistungen), Bereitstellungstyp (Vor-Ort und Cloud), industrielle Anwendung (Luft- und Raumfahrt und Verteidigung, Energie und Versorgung, BFSI, Medien und Unterhaltung, Fertigung, Lebenswissenschaften und Gesundheitswesen und andere industrielle Anwendungen) und Geographie (Nordamerika, Europa, Asien-Pazifik, Lateinamerika und Naher Osten und Afrika). Die Marktgrößen und Prognosen werden in Werten in USD für alle oben genannten Segmente bereitgestellt.

| Hardware | Server | Allzweck-CPU-Server |

| GPU-beschleunigte Server | ||

| ARM-basierte Server | ||

| Speichersysteme | HDD-Arrays | |

| Flash-basierte Arrays | ||

| Objektspeicher | ||

| Interconnect und Netzwerk | InfiniBand | |

| Ethernet (25/40/100/400 GbE) | ||

| Benutzerdefinierte/Optische Interconnects | ||

| Software | Systemsoftware (OS, Cluster Mgmt) | |

| Middleware und RAS Tools | ||

| Parallele Dateisysteme | ||

| Dienstleistungen | Professionelle Dienstleistungen | |

| Verwaltete und HPC-as-a-Service (HPCaaS) | ||

| Vor-Ort |

| Cloud |

| Hybrid |

| CPU |

| GPU |

| FPGA |

| ASIC / KI-Beschleuniger |

| Regierung und Verteidigung |

| Akademische und Forschungseinrichtungen |

| BFSI |

| Fertigung und Automobilingenieurwesen |

| Lebenswissenschaften und Gesundheitswesen |

| Energie, Öl und Gas |

| Andere Branchenanwendungen |

| Nordamerika | Vereinigte Staaten |

| Kanada | |

| Mexiko | |

| Europa | Deutschland |

| Vereinigtes Königreich | |

| Frankreich | |

| Italien | |

| Nordics (Schweden, Norwegen, Finnland) | |

| Rest von Europa | |

| Asien-Pazifik | China |

| Japan | |

| Indien | |

| Südkorea | |

| Singapur | |

| Rest von Asien-Pazifik | |

| Südamerika | Brasilien |

| Argentinien | |

| Rest von Südamerika | |

| Naher Osten | Israel |

| Vereinigte Arabische Emirate | |

| Saudi-Arabien | |

| Türkei | |

| Rest des Nahen Ostens | |

| Afrika | Südafrika |

| Nigeria | |

| Rest von Afrika |

| Nach Komponente | Hardware | Server | Allzweck-CPU-Server |

| GPU-beschleunigte Server | |||

| ARM-basierte Server | |||

| Speichersysteme | HDD-Arrays | ||

| Flash-basierte Arrays | |||

| Objektspeicher | |||

| Interconnect und Netzwerk | InfiniBand | ||

| Ethernet (25/40/100/400 GbE) | |||

| Benutzerdefinierte/Optische Interconnects | |||

| Software | Systemsoftware (OS, Cluster Mgmt) | ||

| Middleware und RAS Tools | |||

| Parallele Dateisysteme | |||

| Dienstleistungen | Professionelle Dienstleistungen | ||

| Verwaltete und HPC-as-a-Service (HPCaaS) | |||

| Nach Bereitstellungsmodus | Vor-Ort | ||

| Cloud | |||

| Hybrid | |||

| Nach Chip-Typ (Querschnitt mit Komponente) | CPU | ||

| GPU | |||

| FPGA | |||

| ASIC / KI-Beschleuniger | |||

| Nach industrieller Anwendung | Regierung und Verteidigung | ||

| Akademische und Forschungseinrichtungen | |||

| BFSI | |||

| Fertigung und Automobilingenieurwesen | |||

| Lebenswissenschaften und Gesundheitswesen | |||

| Energie, Öl und Gas | |||

| Andere Branchenanwendungen | |||

| Nach Geographie | Nordamerika | Vereinigte Staaten | |

| Kanada | |||

| Mexiko | |||

| Europa | Deutschland | ||

| Vereinigtes Königreich | |||

| Frankreich | |||

| Italien | |||

| Nordics (Schweden, Norwegen, Finnland) | |||

| Rest von Europa | |||

| Asien-Pazifik | China | ||

| Japan | |||

| Indien | |||

| Südkorea | |||

| Singapur | |||

| Rest von Asien-Pazifik | |||

| Südamerika | Brasilien | ||

| Argentinien | |||

| Rest von Südamerika | |||

| Naher Osten | Israel | ||

| Vereinigte Arabische Emirate | |||

| Saudi-Arabien | |||

| Türkei | |||

| Rest des Nahen Ostens | |||

| Afrika | Südafrika | ||

| Nigeria | |||

| Rest von Afrika | |||

Wichtige im Bericht beantwortete Fragen

Was ist der projizierte Wert des Hochleistungsrechnen Marktes bis 2030?

Der Markt wird voraussichtlich bis 2030 USD 83,31 Milliarden erreichen und mit einer 7,23% CAGR voranschreiten.

Welches Komponentensegment wächst am schnellsten im Hochleistungsrechnen Markt?

Verwaltete Dienstleistungen und HPC-as-a-Service-Angebote expandieren mit 14,7% CAGR und übertreffen Hardware und Software.

Warum gewinnen GPUs Momentum in der Hochleistungsrechnen Branche?

KI-Training und groß angelegte Inferenz-Aufgaben setzen auf massive Parallelität und treiben GPUs zu einer 10,5% CAGR bis 2030.

Welche Region wird voraussichtlich am schnellsten wachsen und was treibt dieses Wachstum an?

Asien-Pazifik führt mit einer 9,3% CAGR, angetrieben von souveränen Exascale-Projekten in China und Indien und Pharma-Outsourcing-Nachfrage.

Wie beeinflussen Wasserverbrauchsbeschränkungen neue HPC-Rechenzentren?

Staaten wie Arizona und Virginia verlangen wasserneutrale Kühlung, was Baukosten um 15-20% erhöht, aber die Adoption von Flüssigkeits- und Immersionstechnologien anregt.

Welche Rolle spielen hybride Bereitstellungsmodelle in zukünftigen HPC-Strategien?

Hybrid-Frameworks lassen Organisationen sensible Arbeitslasten vor Ort behalten, während sie für Spitzenbedarf in die Cloud ausweichen, und bieten Kostenflexibilität ohne Sicherheitskompromisse.

Seite zuletzt aktualisiert am: