Sensor Fusion Marktgröße und Marktanteil

Sensor Fusion Marktanalyse von Mordor Intelligenz

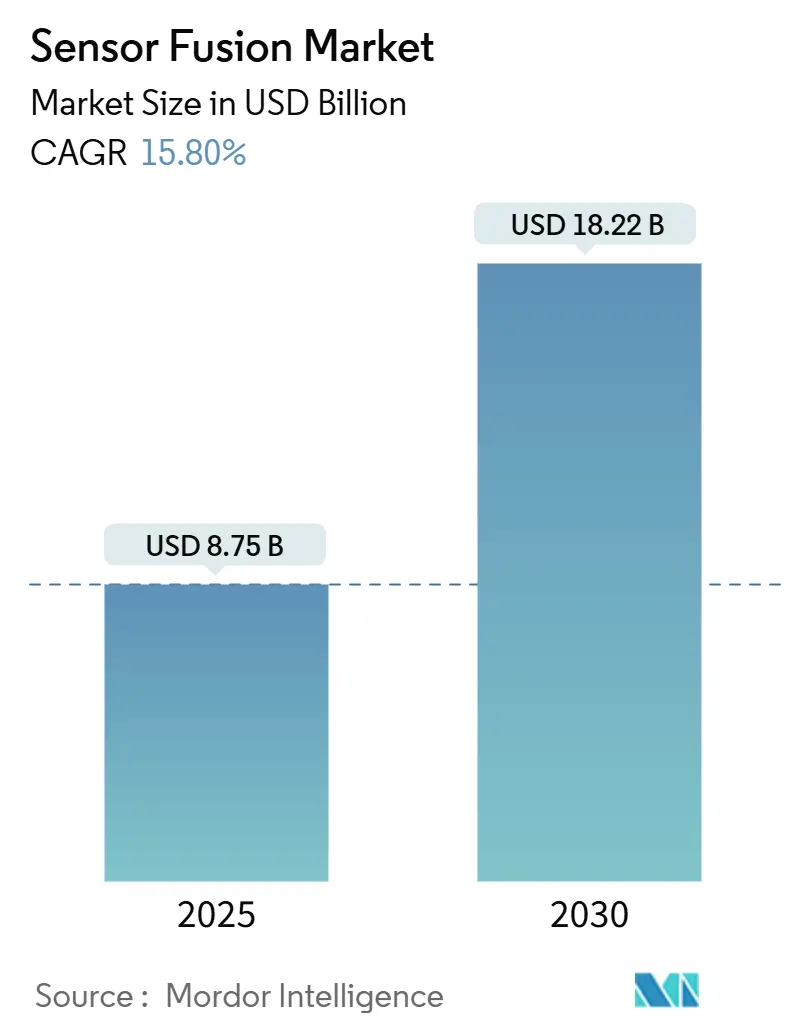

Die Sensor Fusion Marktgröße wird auf 8,75 Milliarden USD im Jahr 2025 geschätzt und soll bis 2030 18,22 Milliarden USD erreichen, mit einer Expansion von 15,8% CAGR. Das Wachstum beruht auf dem Bedarf nach zuverlässiger, echtzeitbasierter Wahrnehmung In autonomen Systemen, verschärften Sicherheitsvorschriften und stetigen Kostensenkungen bei wichtiger Hardware wie Fest-Zustand-Lidar. Asien-Pazifik führt die Akzeptanz an, unterstützt durch Chinas raschen Ausbau von Teststrecken für autonome Fahrzeuge (AV) und Industrieautomatisierungsprojekte. Europas sicherheitsorientierte Politik und die V2X-Infrastrukturinvestitionen der Vereinigten Staaten sorgen für zusätzliche Dynamik. Hardware dominiert weiterhin den Umsatz, doch Software erobert einen steigenden Wertanteil, da Rand-KI die Berechnung von der Wolke zum Endpunkt verlagert und dabei Latenz und Datenschutzrisiken reduziert. Radar-Kamera-Fusion ist derzeit die bewährte Konfiguration, aber Drei-Sensor-Suites, die Lidar hinzufügen, skalieren am schnellsten und verändern die Wettbewerbspositionierung, während die Komponentenpreise fallen.

Wichtige Berichtsergebnisse

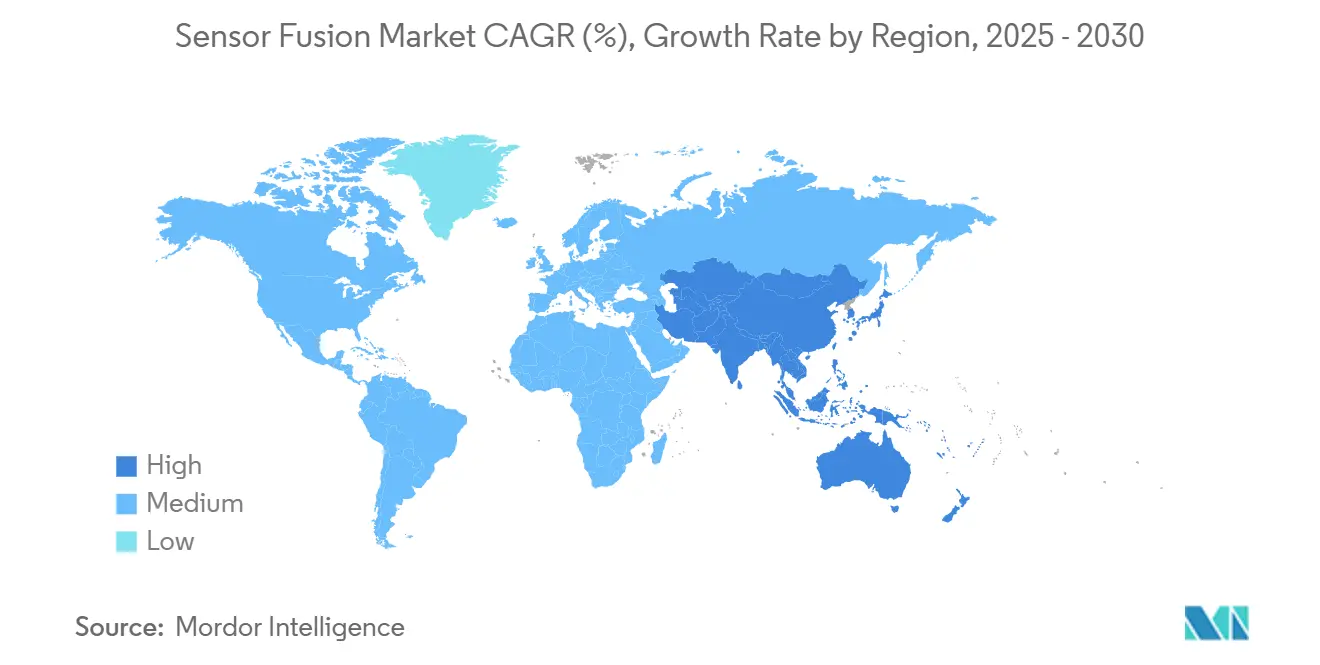

- Nach Geografie hielt Asien-Pazifik 2024 38% des Sensor Fusion Marktanteils; Nordamerika soll bis 2030 eine CAGR von 17,2% erreichen.

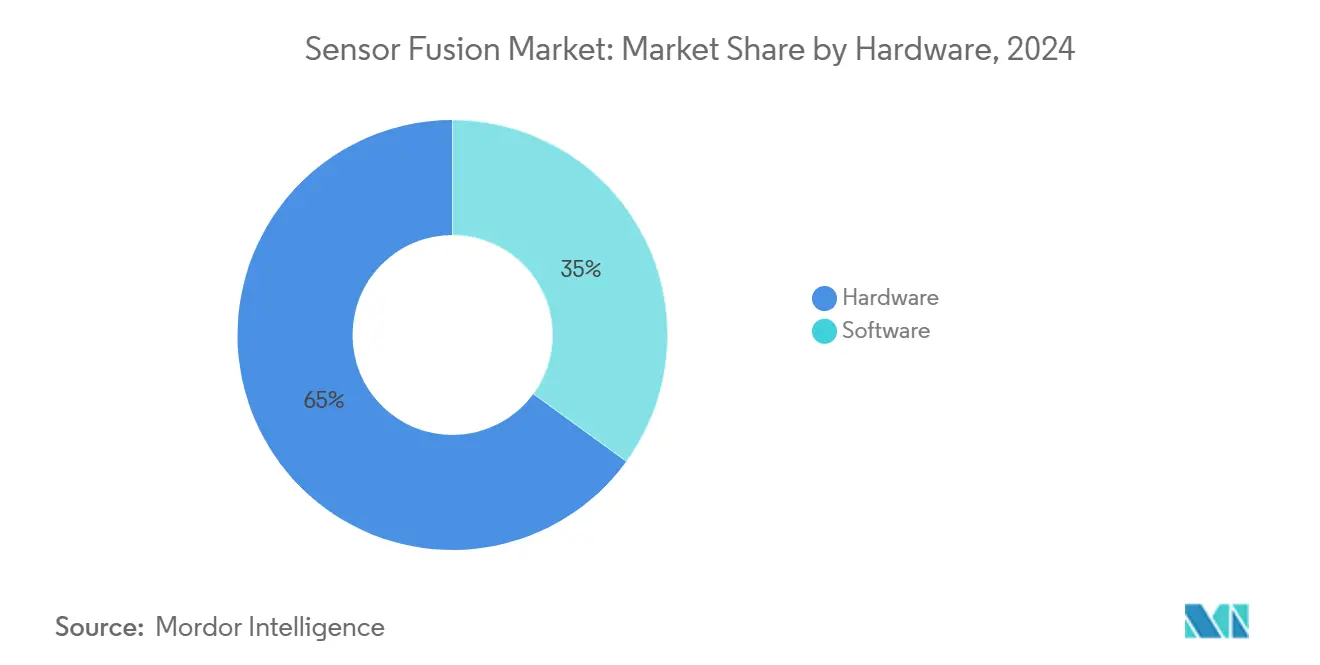

- Nach Angebot entfielen 2024 65% des Umsatzes auf Hardware, während Software bis 2030 mit einer CAGR von 18,9% beschleunigen soll.

- Nach Fusionsmethode führten Radar-Kamera-Systeme mit 38% des Sensor Fusion Marktanteils In 2024; Drei-Sensor-Lösungen (Kamera + Radar + Lidar) entwickeln sich mit einer CAGR von 22,5% bis 2030.

- Nach Anwendung eroberte ADAS 2024 55% des Umsatzes; autonomes Fahren Ebene 3-5 rast mit einer CAGR von 22,1% bis 2030 voran.

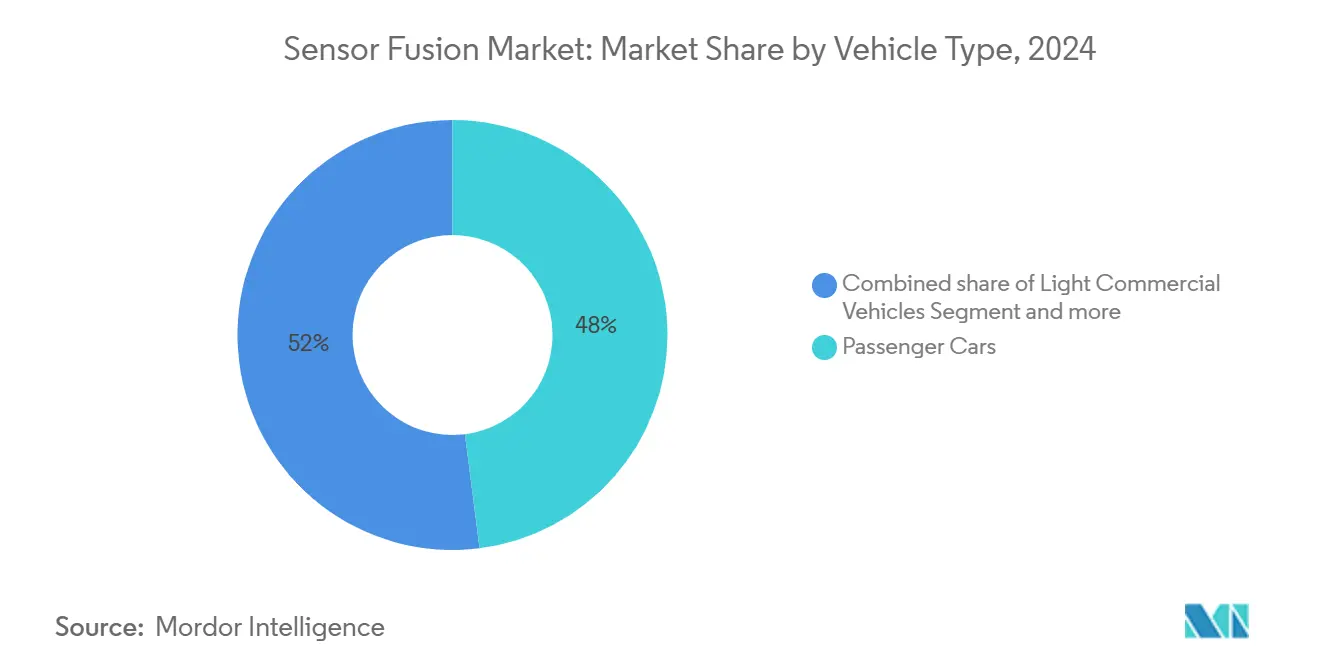

- Nach Fahrzeugtyp repräsentierten Personenwagen 48% der Nachfrage 2024, während Shuttles und AGVs bis 2030 mit einer CAGR von 20,4% wachsen sollen.

Globale Sensor Fusion Markttrends und Einblicke

Treiber-Auswirkungsanalyse

| Treiber | (~) % Auswirkung auf CAGR-Prognose | Geografische Relevanz | Auswirkungszeitraum |

|---|---|---|---|

| Vorschrift für Sensor Fusion bei Euro NCAP 5-Sterne-Bewertungen beschleunigt europäische OEM-Akzeptanz | +3.5% | Europa, mit Ausstrahlungseffekten nach Nordamerika und Asien | Mittelfristig (2-4 Jahre) |

| Kostensenkung bei Fest-Zustand-Lidar ermöglicht mehrere-Sensor-Suites In Mittelklassewagen In China | +2.8% | Asien-Pazifik, hauptsächlich China, mit globalem Einfluss | Kurzfristig (≤ 2 Jahre) |

| Rand-KI-Chip-Fortschritte ermöglichen Echtzeit-mehrere-Modal-Fusion In mobilen und XR-Geräten | +2.1% | Global, mit früher Akzeptanz In Nordamerika und Asien | Mittelfristig (2-4 Jahre) |

| Einsatz von AMR-Robotern In schlau Factories erfordert hochpräzise Sensor Fusion | +1.9% | Asien-Pazifik, Nordamerika, Europa | Mittelfristig (2-4 Jahre) |

| Modernisierungsprogramme der Verteidigung finanzieren mehrere-Sensor-Ziel- und Navigationssysteme im Nahen Osten | +1.2% | Naher Osten, mit Technologietransfer zu globalen Märkten | Langfristig (≥ 4 Jahre) |

| Integration von V2X-DatenströMänner In Fusionsstacks zur Freischaltung von L4-autonomem Fahren In den USA | +2.5% | Nordamerika, mit schrittweiser Akzeptanz In Europa und Asien | Langfristig (≥ 4 Jahre) |

| Quelle: Mordor Intelligence | |||

Vorschrift für Sensor Fusion bei Euro NCAP 5-Sterne-Bewertungen beschleunigt europäische OEM-Akzeptanz

Euro NCAPs Roadmap für 2025 hebt mehrere-Sensor-Wahrnehmung zu einem unverzichtbaren Sicherheitsstandard für europäische Automobilhersteller. Personenwagen-Plattformen müssen Kameras, Radar und zunehmend Lidar harmonisieren, um anspruchsvolle FußGängererkennnungstests sowohl bei Tageslicht als auch In der Dunkelheit zu bestehen. Konvergierende Richtlinien der NHTSA In den Vereinigten Staaten verstärken die globale Ausrichtung und ermöglichen es Zulieferern, Entwicklungskosten über Regionen hinweg zu amortisieren. Tier-1-Anbieter wie Aptiv reagieren mit über Funkschnittstelle aktualisierbaren ADAS-Stacks, die Latenz verringern und Objekterkennung In überfüllten städtischen Szenarien schärfen. Der regulatorische Anstoß beschleunigt Software-Innovation, da Algorithmus-Upgrades messbare Sicherheitsgewinne ohne Hardware-Neugestaltung liefern. [1]Aptiv, "Gen 6 ADAS Plattform," aptiv.com

Kostensenkung bei Solid-State-LiDAR ermöglicht Multi-Sensor-Suites in Mittelklassewagen in China

Stückpreise für automobilgerechte Fest-Zustand-Lidar sind um etwa 99,5% von frühen kommerziellen Niveaus gefallen und machen Drei-Sensor-Fusion-Suites In Chinas weitläufigem Mittelmarktsegment rentabel. 2025 werden 94 heimische Fahrzeugmodelle mit Lidar ausgeliefert, doppelt so viele wie im Vorjahr. Pekings L3-Rahmenwerk vom April 2025 katalysiert die Nachfrage weiter und lässt OEMs höhere Autonomie durch Ride-Hailing- und Privatnutzungsprogramme monetarisieren. Lokale Anbieter Hesai und RoboSense folgen nur Huawei im chinesischen Lidar-Umsatzranking und verstärken ein stark preiskonkurrierendes Umfeld, das die globale Kostensenkung beschleunigt. [2]TDK Corporation, "9-Achse PositionSense IMU With TMR," tdk.com

Edge-KI-Chip-Fortschritte ermöglichen Echtzeit-Multi-Modal-Fusion in mobilen und XR-Geräten

Die Einbettung von NPUs In SoCs reduziert drastisch die Inferenz-Latenz und bringt mehrere-Modal-Fusion-Workloads auf das Gerät. NVIDIAs Thor-Chip liefert 2.000 TOPS für konsolidierte Cockpit-ADAS-Berechnung In einem Paket. Parallel dazu koppelt TDKs 9-Achsen-PositionSense™ eine IMU und TMR-Sensor, um die Laufzeit bei Wearables zu verlängern und gleichzeitig die Richtungsgenauigkeit zu verbessern. Echtzeit-Fusion von Vision-, Trägheits-, Tiefen- und Audio--Streams erschließt Räumlich-Berechnung-Anwendungsfälle, von XR-Headsets bis hin zu kontextbewussten Smartphones, ohne ständige Wolke-Konnektivität.

Einsatz von AMR-Robotern in Smart Factories erfordert hochpräzise Sensor Fusion

Arbeitskräftemangel und die Suche nach Durchsatzgewinnen treiben ein CAGR-Wachstum von 18,3% In der globalen AMR-Flotte bis 2028 an. Fabrikroboter sind auf die Fusion von Lidar, Kameras, Radar und Ultraschallsensoren angewiesen, um sicher zwischen Menschen und Maschinen zu navigieren. Nokias MX Kontext paart Sensor Fusion mit industrieller Rand-KI, um die Geschwindigkeit der Störfallerkennung In Produktionshallen zu erhöhen. Solche hochpräzisen Fusion-Frameworks verkürzen auch Integrationszyklen und geben Systemintegratoren wiederverwendbare Bausteine für Brownfield-Implementierungen.

Hemmnis-Auswirkungsanalyse

| Hemmnis | (~) % Auswirkung auf CAGR-Prognose | Geografische Relevanz | Auswirkungszeitraum |

|---|---|---|---|

| Mangel an einheitlichen Fusion-Architekturstandards behindert Interoperabilität | -1.8% | Global, mit größerer Auswirkung In Schwellenmärkten | Mittelfristig (2-4 Jahre) |

| Hoher Rechenaufwand erhöht BoM für nicht-Automobil IoT-Geräte | -1.2% | Global, mit Schwerpunkt auf Verbraucherelektronik-Märkten | Kurzfristig (≤ 2 Jahre) |

| Begrenzte Lidar-Durchdringung In Schwellenmärkten schränkt mehrere-Modal-Fusion-Akzeptanz ein | -0.9% | Südamerika, Afrika, Teile Südostasiens | Mittelfristig (2-4 Jahre) |

| Datenschutz- und Cybersicherheitsbedenken bezüglich Wolke-gestützter Sensor Fusion Pipelines | -1.5% | Europa (DSGVO), Nordamerika, globale Auswirkung | Mittelfristig (2-4 Jahre) |

| Quelle: Mordor Intelligence | |||

Mangel an einheitlichen Fusion-Architekturstandards behindert Interoperabilität

Ohne gemeinsame Datenformate und Validierungs-Frameworks entwickeln OEMs und Zulieferer maßgeschneiderte Fusion-Pipelines, was Integrationskosten erhöht und Komponenten-Austauschbarkeit behindert. NIST fordert standardisierte Referenzdatensätze und Bewertungsmetriken, um herstellerübergreifende Kompatibilität zu beschleunigen. Fragmentierung kompliziert auch die Automobilhomologation, da auf einer Plattform gesammelte Belege möglicherweise nicht auf eine andere übertragbar sind, was Feature-Rollouts über Modelllinien hinweg verlangsamt. [3]NIST, "Standards Needs für automatisiert Fahrzeug Technologien," nist.gov

Datenschutz- und Cybersicherheitsbedenken bezüglich Cloud-gestützter Sensor Fusion Pipelines

DSGVO und vergleichbare Vorschriften beschränken die fahrzeugexterne Übertragung von persönlich identifizierbaren Informationen, die von AV-Wahrnehmungssystemen erfasst werden. Verschlüsselung und Anonymisierung hochbandbreitiger Lidar-Punktwolken treibt Rechenbudgets In die Höhe und drängt Automobilhersteller zu Rand-zentrierter Fusion, um Rohdaten im Fahrzeug zu behalten. Eine aktuelle Branchenumfrage ergab, dass 70% der OEMs Cybersicherheit als ihre wichtigste Herausforderung für Fusion-Stacks auflisten und die Notwendigkeit sicherer Kommunikationskanäle zwischen ECUs und Wolke-Knoten betonen.

Segmentanalyse

Nach Angebot: Software erschließt die nächste Wertebene

Die Sensor Fusion Marktgröße für Hardware betrug 2024 5,7 Milliarden USD, entsprechend 65% der Gesamtausgaben, und unterstreicht die unverzichtbare Rolle von Kameras, Radar, Lidar und IMUs In der Wahrnehmung. Hardware-Wachstum setzt sich fort, da Fahrzeuge 30 diskrete Sensoren überschreiten, doch Preiserosion Dämpft Umsatzexpansion. Der Software-Anteil hingegen skaliert mit einer CAGR von 18,9% bis 2030, da ota-Updates neue Umsatzstufen nach dem Verkauf freischalten, eine Verschiebung, die bereits In Aptivs Gen-6-ADAS-Rollouts erkennbar ist.

Ausgeklügelte Fusion-Algorithmen heben die Leistung installierter Hardware und bieten margenreiche Upgrades ohne physische Änderungen. CEVAs FSP201-Sensor-Hub-MCU veranschaulicht den Trend: ein einziger stromsparender Chip fusioniert Trägheits-, Audio-- und Umgebungsdaten für Drohnen und Wearables und signalisiert, wie optimierter Code den Sensor Fusion Markt noch jahrelang anheben wird.

Nach Fusionsmethode: Drei-Sensor-Suites definieren Wahrnehmung neu

Radar-Kamera-Systeme kontrollierten 2024 38% des Sensor Fusion Marktanteils und balancieren Kosten und Robustheit gegen schlechtes Wetter. Die meisten L2-ADAS-Stacks setzen auf diese Paarung für adaptiven Tempomat und automatisches Bremsen. Die Sensor Fusion Marktgröße verbunden mit Drei-Sensor-Plattformen soll jedoch bis 2030 mit einer CAGR von 22,5% sprunghaft ansteigen, da Fest-Zustand-Lidar-Preise stürzen.

Die Integration von Lidar verbessert Tiefengenauigkeit und Redundanz, kritisch für L3-und höhere Autonomie. Kyoceras Kamera-Lidar-Fusion-Sensor komprimiert zwei Modalitäten In ein Gehäverwenden, reduziert Parallaxe und vereinfacht gleichzeitig Kalibrierungsanforderungen. Diese Verpackungseffizienz ist lebenswichtig für kostensensitive Segmente, wo Raum- und Wärmebudgets knapp sind.

Nach Algorithmustyp: Lernbasierte Modelle fordern Kalman-Filter heraus

Kalman-Filter führten 2024-Implementierungen mit 52% Marktanteil an dank deterministischem Verhalten und Zertifizierbarkeit. Die Sensor Fusion Marktgröße verbunden mit neuronalen Netzwerken steigt rapide mit einer CAGR von 24,8%, da Rechenleistung am Rand steigt. neuronal-erweiterte Filter senken Schätzfehler um bis zu 70% bei Benchmark-MOT-Datensätzen und verbinden die Vorhersagbarkeit klassischer Modelle mit der Mustererkennung-Stärke des Tief Lernen.

Hybrid-Stacks gewinnen In sicherheitskritischen Kontexten an Beliebtheit, da sie gegen Grenzfälle absichern, die rein datengesteuerte Netzwerke möglicherweise falsch interpretieren. NVIDIAs fahren-Plattform verkörpert die Synthese durch Kombination konvolutionaler Backbones mit probabilistischem Tracking, um Latenz innerhalb strenger Funktionssicherheitsbudgets zu halten. [4]NVIDIA, "fahren Plattform technisch Overview," nvidia.com

Nach Anwendung: Höhere Autonomiestufen beschleunigen Nachfrage

ADAS machte 2024 55% des Umsatzes aus, da regulatorische Mandate Features wie AEB und Spurhaltung universell In Neuwagen In Europa, den Vereinigten Staaten und China machen. Doch autonomes Fahren (L3-L5) ist der schnellste Beweger und expandiert mit 22,1% CAGR, da konkrete regulatorische Wege In Peking, München und Kalifornien entstehen.

Außerhalb der Automobilbranche integrieren XR-Headsets, Smartphones und Wearables mehrere-Sensor-Arrays, um Räumlich Berechnung anzutreiben. TDKs PositionSense™ veranschaulicht, wie effiziente Fusion die Eintauchen erhöht und gleichzeitig den Batterieverschleiß reduziert. In Fabriken sind AMRs auf fusionierte Lidar und Vision angewiesen, um mit Menschen zu koexistieren, was Industrieintegratoren drängt, modulare Fusion-Frameworks zu übernehmen.

Nach Fahrzeugtyp: Personenwagen beherrschen weiterhin, Roboter steigen schnell

Personenwagen besaßen 2024 48% des Volumens, da sie den Großteil der jährlichen globalen Fahrzeugproduktion bilden. Euro NCAPs Sensor Fusion-Mandat zementiert den Verlauf. Unterdessen sollen Shuttles und AGVs bis 2030 eine CAGR von 20,4% erreichen, da sich Logistikketten digitalisieren und Arbeitslücken weiten.

Die Sensor Fusion Industrie sieht schwere Nutzfahrzeuge Fahrerüberwachungs- und Spurverlassungs-Fusion-Stacks übernehmen, während leichte Nutzfahrzeuge Wahrnehmung für Last-Mile-Lieferroboter integrieren. Anbieter, die modulare Sensor-Bausätze auf jeden Einsatzzyklus zuschneiden, sind am besten positioniert, diese Diversifizierung zu erfassen.

Notiz: Segmentanteile aller individuellen Segmente verfügbar beim Berichtskauf

Geografieanalyse

Asien-Pazifik kontrolliert den größten Anteil des Sensor Fusion Marktes und erreicht 2024 3,3 Milliarden USD mit einer Entwicklung von 17,2% CAGR. Chinas über 50 AV-Testzonen, zusammen mit nationalen Subventionen für Industrierobotik, schaffen Größenordnung. Japan und Südkorea tragen miniaturisiertes Sensor-Know-how bei, das globale Lieferketten speist. Die Sensor Fusion Marktgröße In Nordamerika liegt zurück, profitiert aber von Silizium Valleys tiefem KI-Talentpool und dem uns-Vorstoß, V2X-Radios In Autobahnkorridore einzubetten, eine Voraussetzung für L4-Wahrnehmungsredundanz.

Europas Richtung wird durch strenge Sicherheits- und Datenschutzvorschriften bestimmt. Die regionalen Tier-1-Zulieferer nutzen Präzisionsentwicklung, um Euro NCAPs mehrere-Sensor-Anforderungen zu erfüllen und europäische Plattformen bei Funktionssicherheitsmetriken vorne zu halten. Im gesamten Nahen Osten treibt Verteidigungsmodernisierung mehrere-Sensor-Zielsysteme voran; diese Projekte gebären oft Dual-verwenden-IP, das später In zivile AVs migriert. Afrika und Südamerika hinken aufgrund begrenzter Lidar-Durchdringung und weniger reifer Dateninfrastruktur hinterher, aber Taschen von schlau-City-Finanzierung pilotieren Sensor Fusion für Verkehrsmanagement und öffentliche Sicherheitsdrohnen.

Insgesamt diktieren regionale Regulierungs-Frameworks, von Pekings AV-Dekret bis Brüssels KI-Gesetz, das Tempo und die Tiefe von Sensor Fusion-Rollouts. Anbieter, die an kontinentübergreifende Homologationsprozesse gewöhnt sind, verwandeln regulatorische Varianz In Dienstleistung-Umsatz, indem sie Zertifizierungs-Toolchains gebündelt mit ihren Wahrnehmungsstacks anbieten.

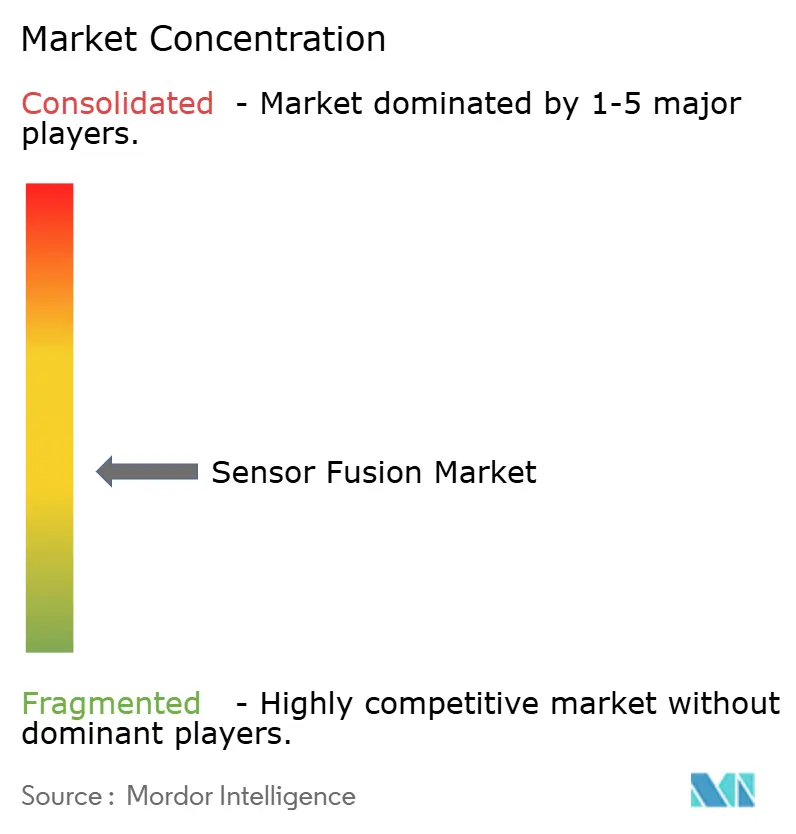

Wettbewerbslandschaft

Der Sensor Fusion Markt ist moderat konzentriert um globale Tier-1s und Halbleitergiganten. Bosch, Continental, Aptiv, NXP und Infineon liefern Große Teile von Hardware und Domain-Controller-Logik, während NVIDIA und Qualcomm Automobil-gerechte KI-Beschleuniger bereitstellen. Vertikale Integration ist im Trend: Bosch, TSMC, Infineon und NXP investierten gemeinsam In eine Dresdner Fab, um Knotenverfügbarkeit für zukünftige Sensor- und Prozessorfamilien zu sichern.

Software-zentrierte Herausforderer fokussieren auf Algorithmus-IP statt auf Silizium. Mobileye und Aurora entwickeln Wahrnehmungsstacks optimiert für kamera-geführte bzw. Lidar-schwere Architekturen. Lidar-Neulinge Hesai und RoboSense gewinnen Anteile mit aggressiver Preisgestaltung und rascher Iteration und liefern gemeinsam mehr als 30 Millionen Einheiten In chinesische OEM-Programme. Ihr Erfolg zwingt etablierte optische Sensor-Incumbents, Kostensenkungsfahrpläne zu beschleunigen.

Weiß-Raum-Chancen liegen In modularer, standardsbasierter Middleware, die Integrationszeit über Fahrzeugklassen und Industrieroboter hinweg verkürzt. Anbieter, die sichere ota-Pipelines mit Formal-Überprüfung-Toolkits verheiraten, werden reine Hardware-Wettbewerber ausmanövrieren, sobald sich Funktionssicherheitsprüfungen unter ISO-26262-Erweiterungen für L4-Autonomie verschärfen. Schließlich fördern Rand-Compute-Anbieter wie Lattice Halbleiter ultra-stromsparende FPGAs für eingebettete Fusion In Drohnen und Wearables und erweitern den adressierbaren Markt über die Automobilbranche hinaus.

Sensor Fusion Industrieführer

-

Robert Bosch GmbH

-

Continental AG

-

NXP Semiconductors N.V.

-

STMicroelectronics N.V.

-

Infineon Technologien AG

- *Haftungsausschluss: Hauptakteure in keiner bestimmten Reihenfolge sortiert

Aktuelle Branchenentwicklungen

- Mai 2025: Nokia startete MX Kontext, eine industrielle Rand-Sensor Fusion Plattform, die GNSS, RFID und KI für Echtzeit-Situationsbewusstsein kombiniert.

- April 2025: Kyocera stellte den weltweit ersten Kamera-Lidar-Fusion-Sensor mit parallaxfreier Ausgabe und hochdichtem Laser-Scannen für Langstrecken-Hinderniserkennung vor.

- März 2025: allgemein Atomics und UC San Diego eröffneten das Fusion Daten Wissenschaft Und digital Maschinenbau Center, um KI-gestütztes Fusion-Energiesystem-Design zu beschleunigen.

- Januar 2025: TDK veröffentlichte die 9-Achsen-PositionSense™ IMU + TMR-Lösung, um Drift und Stromverbrauch In mobilen Bewegungsverfolgungs-Anwendungen zu reduzieren.

Globaler Sensor Fusion Marktbericht Umfang

Sensor Fusion bezieht sich auf den Prozess der Zusammenführung von Daten aus mehreren Sensoren, um die Unsicherheit bei der Navigation oder Aufgabenerfüllung eines Roboters zu reduzieren. Diese Sensoren umfassen Kameras, Radar, Lidar, Zeit-von-Flug (ToF), Mikrofone und Trägheitsmesseinheiten (IMU). Die drei grundlegenden Wege zur Kombination von Sensordaten sind redundante Sensoren, komplementäre Sensoren und koordinierte Sensoren.

Der Markt wurde basierend auf Fahrzeugtyp und Geografie segmentiert. Personen-, leichte Nutzfahrzeuge und schwere Nutzfahrzeuge wurden In die Studie einbezogen. In anderen autonomen Fahrzeugsegmenten werden Drohnen und autonome Roboter bei der Bewertung des Segmentumfangs berücksichtigt. Die Studie bewertet auch die Auswirkungen von COVID-19 auf den Markt. Die Marktgrößen und Prognosen werden In Wertangaben (USD Millionen) für alle oben genannten Segmente bereitgestellt.

| Hardware |

| Software |

| Radar + Kamera Fusion |

| LiDAR + Kamera Fusion |

| Radar + LiDAR Fusion |

| IMU + GPS Fusion |

| 3-Sensor Fusion (Kamera + Radar + LiDAR) |

| Kalman-Filter (EKF, UKF) |

| Bayessche Netzwerke |

| Neuronales Netzwerk / Deep Learning |

| GNSS/INS Integration |

| Erweiterte Fahrerassistenzsysteme (ADAS) | ACC |

| AEB | |

| ESC | |

| FCW | |

| Spurhalteassistent (LKA) | |

| Autonomes Fahren (Level 3-5) | |

| Verbraucherelektronik (AR/VR, Smartphones, Wearables) | |

| Robotik und Drohnen | |

| Industrieautomatisierung und intelligente Fertigung | |

| Verteidigung und Luft- und Raumfahrt |

| Personenwagen |

| Leichte Nutzfahrzeuge |

| Schwere Nutzfahrzeuge |

| Andere autonome Fahrzeuge (Shuttles, AGVs) |

| Nordamerika | Vereinigte Staaten |

| Kanada | |

| Mexiko | |

| Karibik | |

| Europa | Deutschland |

| Vereinigtes Königreich | |

| Frankreich | |

| Italien | |

| Spanien | |

| Restliches Europa | |

| Asien-Pazifik | China |

| Japan | |

| Südkorea | |

| Indien | |

| Restlicher Asien-Pazifik-Raum | |

| Südamerika | Brasilien |

| Argentinien | |

| Restliches Südamerika | |

| Naher Osten | Saudi-Arabien |

| Vereinigte Arabische Emirate | |

| Israel | |

| Türkei | |

| Restlicher Naher Osten | |

| Afrika | Südafrika |

| Nigeria | |

| Ägypten | |

| Restliches Afrika |

| Nach Angebot | Hardware | |

| Software | ||

| Nach Fusionsmethode | Radar + Kamera Fusion | |

| LiDAR + Kamera Fusion | ||

| Radar + LiDAR Fusion | ||

| IMU + GPS Fusion | ||

| 3-Sensor Fusion (Kamera + Radar + LiDAR) | ||

| Nach Algorithmustyp | Kalman-Filter (EKF, UKF) | |

| Bayessche Netzwerke | ||

| Neuronales Netzwerk / Deep Learning | ||

| GNSS/INS Integration | ||

| Nach Anwendung | Erweiterte Fahrerassistenzsysteme (ADAS) | ACC |

| AEB | ||

| ESC | ||

| FCW | ||

| Spurhalteassistent (LKA) | ||

| Autonomes Fahren (Level 3-5) | ||

| Verbraucherelektronik (AR/VR, Smartphones, Wearables) | ||

| Robotik und Drohnen | ||

| Industrieautomatisierung und intelligente Fertigung | ||

| Verteidigung und Luft- und Raumfahrt | ||

| Nach Fahrzeugtyp | Personenwagen | |

| Leichte Nutzfahrzeuge | ||

| Schwere Nutzfahrzeuge | ||

| Andere autonome Fahrzeuge (Shuttles, AGVs) | ||

| Nach Geografie | Nordamerika | Vereinigte Staaten |

| Kanada | ||

| Mexiko | ||

| Karibik | ||

| Europa | Deutschland | |

| Vereinigtes Königreich | ||

| Frankreich | ||

| Italien | ||

| Spanien | ||

| Restliches Europa | ||

| Asien-Pazifik | China | |

| Japan | ||

| Südkorea | ||

| Indien | ||

| Restlicher Asien-Pazifik-Raum | ||

| Südamerika | Brasilien | |

| Argentinien | ||

| Restliches Südamerika | ||

| Naher Osten | Saudi-Arabien | |

| Vereinigte Arabische Emirate | ||

| Israel | ||

| Türkei | ||

| Restlicher Naher Osten | ||

| Afrika | Südafrika | |

| Nigeria | ||

| Ägypten | ||

| Restliches Afrika | ||

Wichtige im Bericht beantwortete Fragen

Was treibt das rasante Wachstum des Sensor Fusion Marktes?

Strenge Sicherheitsvorschriften, fallende Fest-Zustand-Lidar-Preise und Fortschritte bei Rand-KI-Chips, die Echtzeit-mehrere-Modal-Fusion ermöglichen, treiben den Markt zu einer CAGR von 15,8% bis 2030.

Welche Region führt heute den Sensor Fusion Markt?

Asien-Pazifik hält einen Umsatzanteil von 38%, angetrieben durch Chinas Groß angelegte AV-Pilotprojekte und aggressive Industrieautomatisierungsinvestitionen.

Wie expandieren Software-Umsätze schneller als Hardware?

über-Die-Luft-Updates und KI-erweiterte Fusion-Algorithmen fügen neue Funktionalität zu installierten Sensoren hinzu und ermöglichen es Anbietern, laufende Leistungs-Upgrades ohne Hardware-Austausch zu monetarisieren.

Warum gewinnen Drei-Sensor-Fusion-Suites an Zugkraft?

Die Kombination von Kamera, Radar und Lidar liefert höhere Tiefengenauigkeit und Redundanz, die für Ebene 3-5 autonomes Fahren wesentlich sind, besonders jetzt da Lidar-Kosten um 99,5% gefallen sind.

Was sind die hauptsächlichen Hindernisse für eine breitere Sensor Fusion Akzeptanz?

Interoperabilitätslücken aufgrund fehlender Architekturstandards, hoher Rechenaufwand In IoT-Geräten, begrenzter Lidar-Zugang In einigen Regionen und steigende Datenschutz- und Cybersicherheitsanforderungen verlangsamen Rollouts.

Welches Industriesegment außerhalb der Automobilbranche zeigt starke Sensor Fusion Akzeptanz?

Autonome Mobil Roboter In schlau Factories übernehmen hochpräzise Fusion für Navigation und sollen bis 2028 mit einer CAGR von 18,3% wachsen.

Seite zuletzt aktualisiert am: