In-Memory Database-Marktgröße und -anteil

In-Memory Database-Marktanalyse von Mordor Intelligence

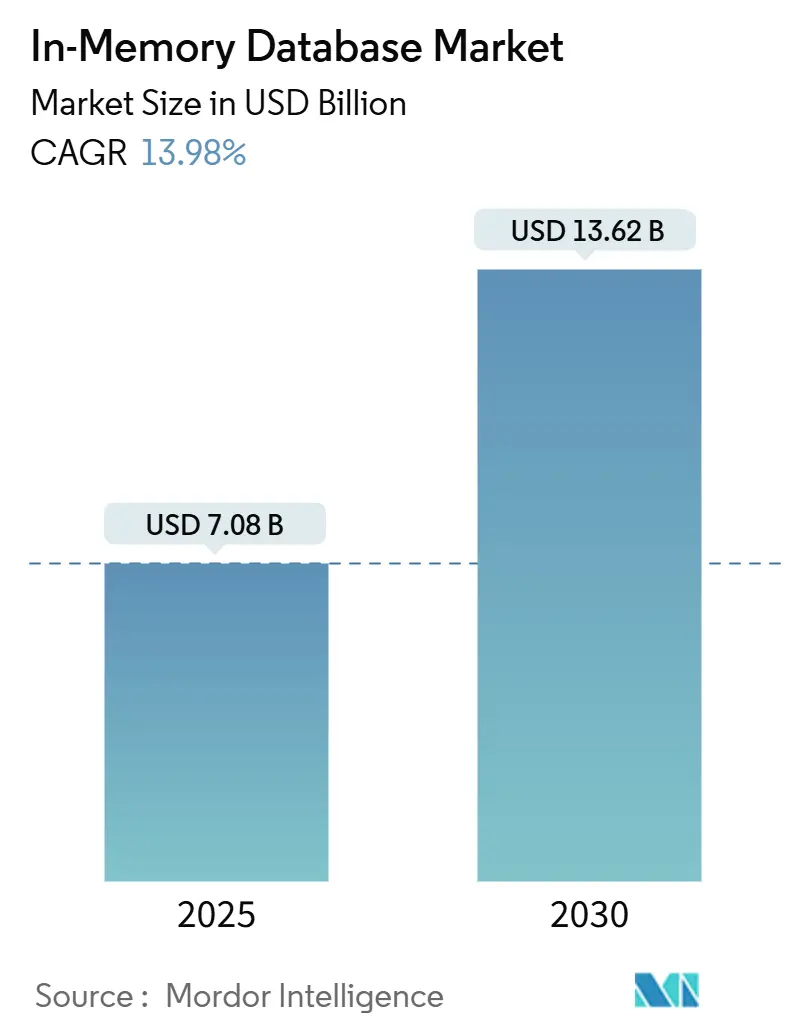

Die globale In-Memory Database-Marktgröße betrug USD 7,08 Milliarden im Jahr 2025 und wird voraussichtlich USD 13,62 Milliarden bis 2030 erreichen, mit einem Wachstum von 13,98% CAGR über den Prognosezeitraum. Sub-Millisekunden-Leistungsanforderungen von Cloud-nativen Microservices, KI-Inferenz-Engines und Streaming-Analytics-Plattformen drängten Unternehmen weiterhin in Richtung speicherzentrierter Architekturen. Niedrigere DRAM-Preise und die Einführung von CXL-basierten persistenten Speichermodulen haben die Gesamtbetriebskosten reduziert und mehr Arbeitslasten zur Migration von festplattenbasierten Systemen ermutigt. Edge-Bereitstellungen in vernetzten Fahrzeugen und industriellen IoT-Anlagen erweiterten die Nachfrage weiter, da die lokale Verarbeitung Netzwerklatenz-Strafen vermeidet. Die Wettbewerbsdynamik blieb fließend, da traditionelle Anbieter ihre Integrationen mit hyperscale Clouds vertieften, während Open-Source-Forks Momentum gewannen und Käufern neue Wege boten, Anbieter-Lock-in zu vermeiden.

Wichtige Berichtsergebnisse

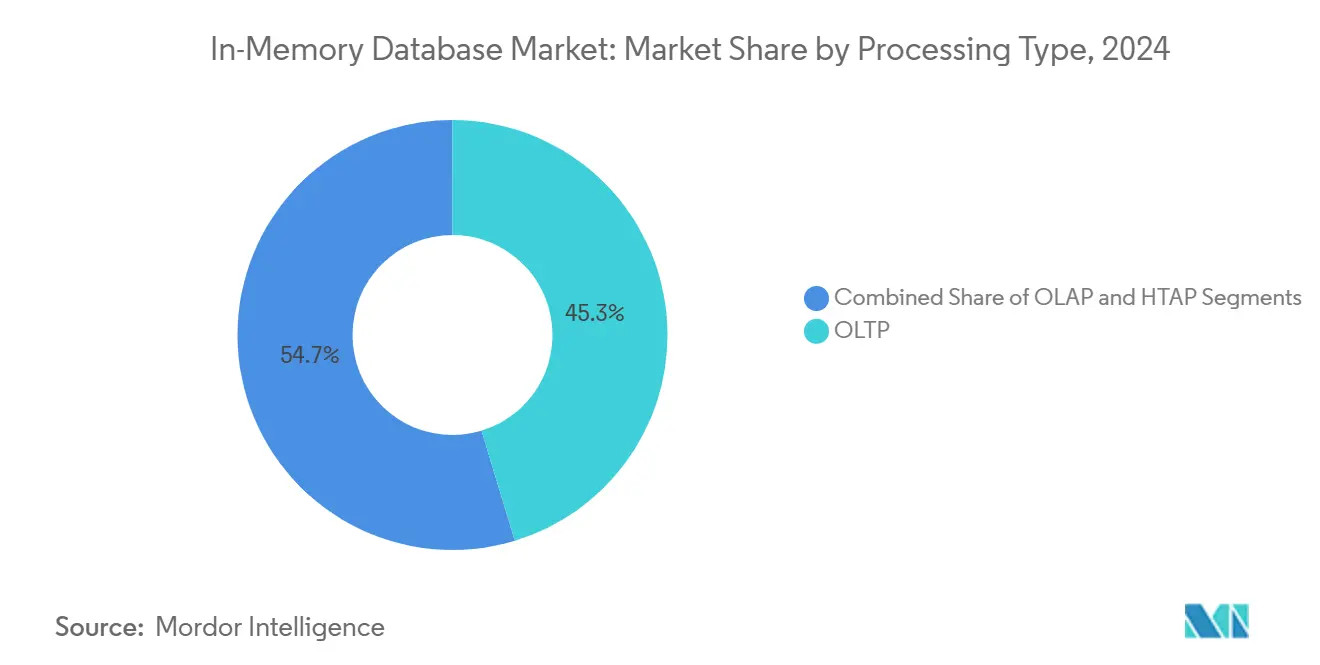

- Nach Verarbeitungstyp führte Online Transaction Processing (OLTP) mit 45,3% des In-Memory Database-Marktanteils in 2024, während Hybrid Transactional/Analytical Processing (HTAP) voraussichtlich mit einer CAGR von 21,1% bis 2030 wachsen wird.

- Nach Bereitstellungsmodus behielten On-Premise-Installationen 55,4% des Umsatzanteils in 2024; Edge- und eingebettete Bereitstellungen werden voraussichtlich mit einer CAGR von 23,2% bis 2030 expandieren.

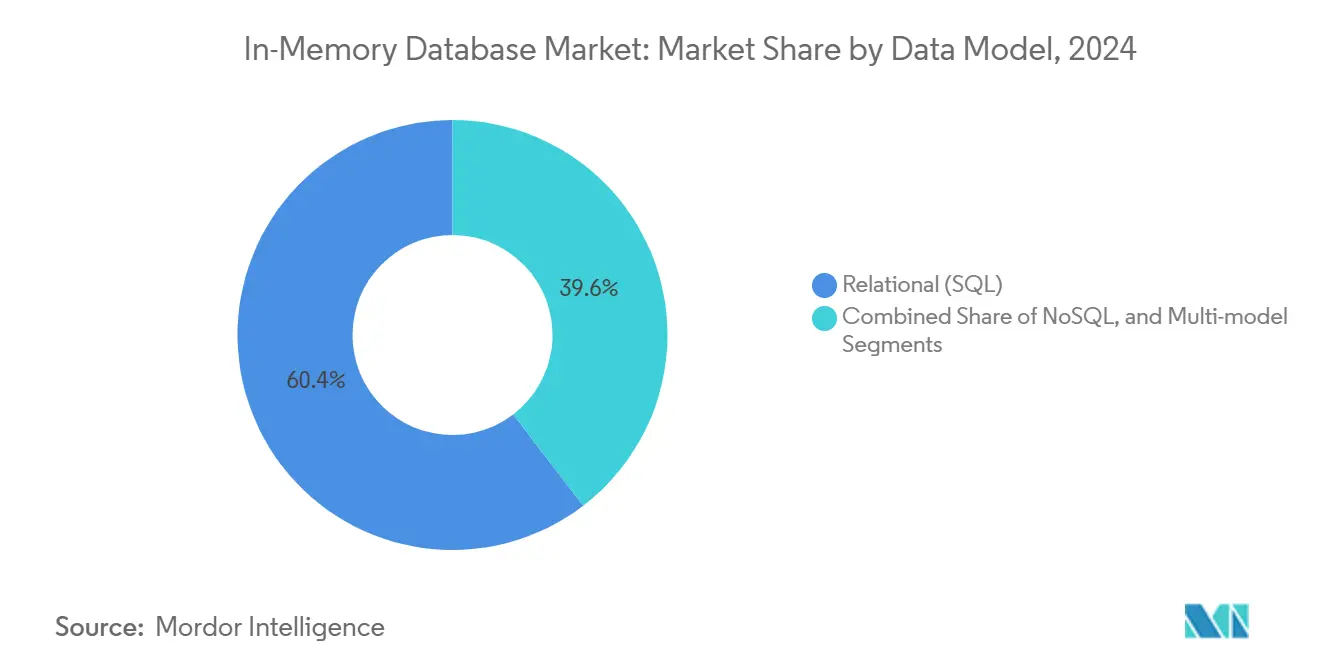

- Nach Datenmodell eroberte relationales SQL einen 60,4%igen Anteil in 2024, während Multi-Model-Plattformen eine CAGR von 20,1% zwischen 2025 und 2030 verzeichnen sollen.

- Nach Unternehmensgröße hielten Großunternehmen 70,5% Anteil der In-Memory Database-Marktgröße in 2024; kleine und mittlere Unternehmen werden die schnellste CAGR von 18,1% bis 2030 registrieren.

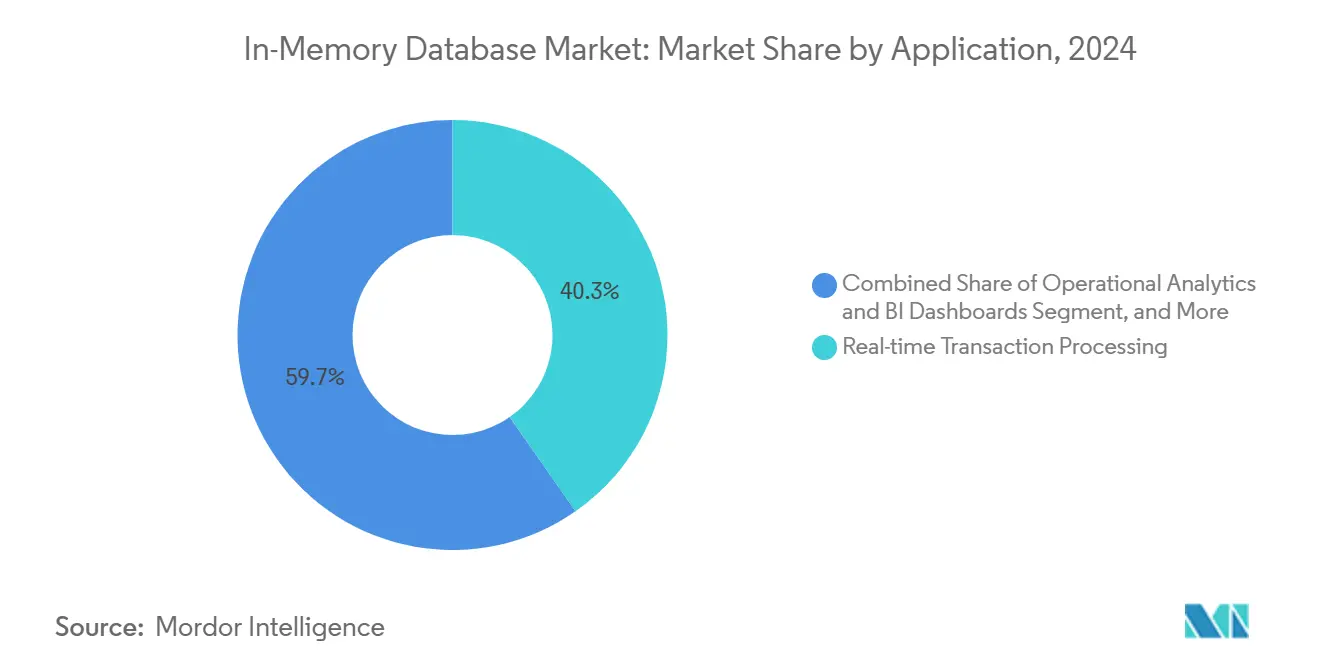

- Nach Anwendung entfiel die Echtzeitverarbeitung von Transaktionen auf 40,3% der In-Memory Database-Marktgröße in 2024, während KI/ML-Model-Serving voraussichtlich mit einer CAGR von 24,2% bis 2030 expandieren wird.

- Nach Endnutzer-Industrie dominierte BFSI mit 28,2% Umsatzanteil in 2024; Gesundheitswesen und Biowissenschaften sind für eine CAGR von 18,1% bis 2030 positioniert.

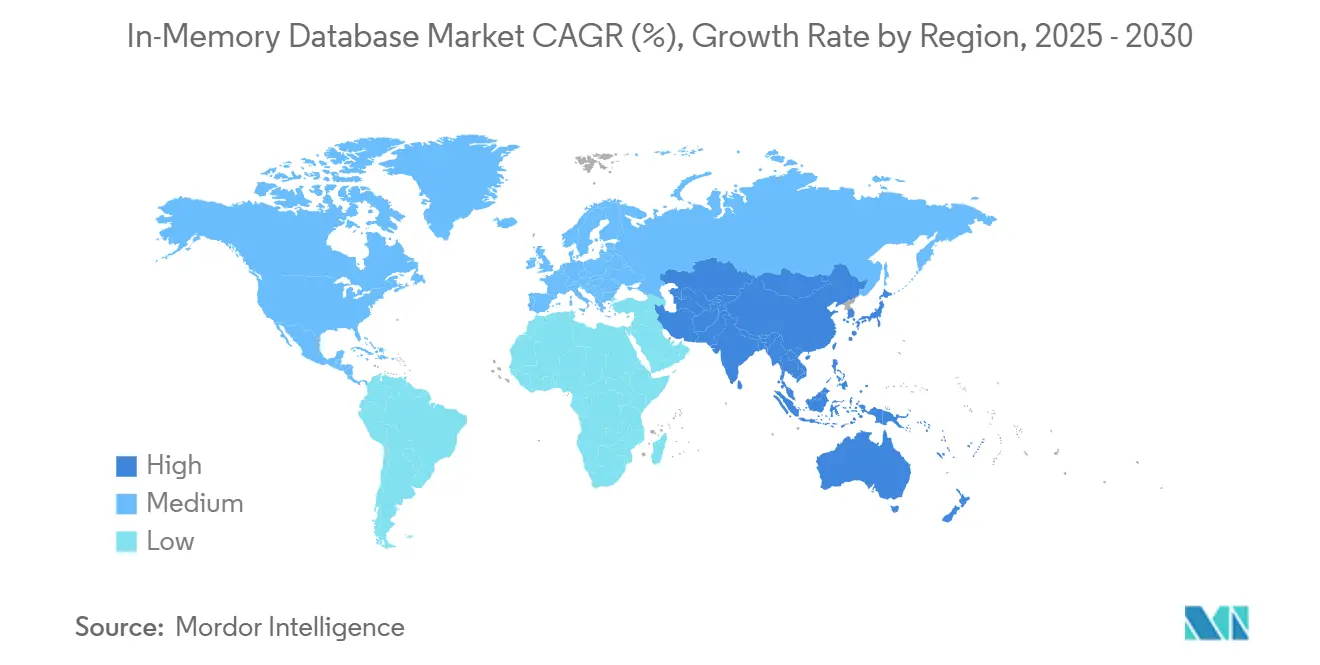

- Nach Geografie kommandierte Asien-Pazifik 32,2% des globalen Umsatzes in 2024 und bleibt die am schnellsten wachsende Region mit 17,1% CAGR bis 2030.

Globale In-Memory Database-Markttrends und Einblicke

Treiber-Auswirkungsanalyse

| Treiber | (~) % Auswirkung auf CAGR-Prognose | Geografische Relevanz | Auswirkungszeitrahmen |

|---|---|---|---|

| Cloud-native Micro-Services mit Sub-Millisekunden-Latenz-Anforderungen | +3.2% | Global, mit Konzentration in Nordamerika und EU | Kurzer Zeitraum (≤ 2 Jahre) |

| Fallende DRAM- und persistente Speicher-USD/GB erweitern TCO-Lücke vs. Festplatte | +2.8% | Global, frühe Adoption in APAC-Fertigungszentren | Mittlerer Zeitraum (2-4 Jahre) |

| Streaming-Analytics-Adoption in BFSI und Telekom für Betrug und Netzwerk-QoS | +2.1% | Nordamerika und EU-Finanzzentren, APAC-Telekom-Infrastruktur | Kurzer Zeitraum (≤ 2 Jahre) |

| HTAP-Architekturen beschleunigen KI/ML-Model-Serving im Gesundheitswesen | +1.9% | Global, mit regulatorisch gesteuerter Adoption in EU und Nordamerika | Mittlerer Zeitraum (2-4 Jahre) |

| Edge-Compute-Anwendungsfälle (vernetzte Fahrzeuge, IIoT) erfordern eingebettete IMDB | +2.4% | APAC-Fertigung, Nordamerika-Automobilkorridore | Langer Zeitraum (≥ 4 Jahre) |

| Quelle: Mordor Intelligence | |||

Cloud-Native Microservices mit Sub-Millisekunden-Latenz-Anforderungen

Cloud-native Adoption formte Leistungsgrundlagen um, da containerisierte Microservices Datenzugriff in Mikrosekunden benötigten. Session-Stores, Personalisierungs-Engines und Hochfrequenz-Handelsplattformen wechselten von festplattenbasierten Datenbanken zu speicherzentrierten Stores, da jede Millisekunde Verzögerung Conversion-Raten oder Handelsgewinne reduzierte. Dragonfly demonstrierte 6,43 Millionen Operationen pro Sekunde auf AWS Graviton3E-Silizium und hob die Obergrenze hervor, die jetzt von Datenbank-Schichten erwartet wird.[1]DragonflyDB, "2024 New Year, New Number," dragonflydb.io Finanzinstitute und digitale Commerce-Betreiber, die Monolithen zu verteilten Systemen migrierten, sahen Antwortzeit-Verbesserungen in greifbare Umsatzgewinne übersetzen, was die kurzfristige Bedeutung des Treibers verstärkte.

Fallende DRAM- und persistente Speicherkosten erweitern TCO-Lücke

Globale Spot-Preise von DDR4- und DDR5-Modulen fielen weiter, während Samsungs CXL Memory Module Hybrid-Prototyp DRAM-Klassen-Latenz mit Persistenz zeigte und ein überzeugendes Kostenprofil schuf. Hyperscale-Betreiber poolten Speicher über Racks hinweg, reduzierten gestrandete Kapazität und Backup-Zyklen. Unternehmen schwenkten Roadmaps in Richtung In-Memory-Bereitstellung, da sich die Prämie über SSD-Arrays verringerte, insbesondere für Analytics-Workloads mit engen SLA-Fenstern. Der Effekt ist sichtbar in Asien-Pazifik-Fertigungszentren, wo große Historian-Datensätze in den Speicher für Echtzeit-Digital-Twin-Analytics verschoben werden.

Streaming-Analytics-Adoption in BFSI und Telekom

Banken setzten Streaming-Betrugserkenungssysteme ein, die Millionen von Kartenautorisierungen pro Sekunde mit Aerospikes In-Memory-Engine verarbeiteten. Telekom-Betreiber, die 5G ausrollten, überwachten Radio-Access-Network-Logs in Echtzeit zur Aufrechterhaltung der Servicequalität und nutzten Vektor-Suchen auf MongoDB zur Kennzeichnung von Anomalien. Regulierung in Nordamerika und Europa erforderte Echtzeit-Berichterstattung über verdächtige Aktivitäten und trieb die Adoptionskurve des Treibers steil nach oben.

HTAP-Architekturen beschleunigen KI/ML-Model-Serving

Hybrid Transactional/Analytical Processing entfernte ETL-Verzögerungen durch Vereinheitlichung von Schreibvorgängen und Analytics im selben Speicherpool. Oracle integrierte große Sprachmodelle in HeatWave GenAI, sodass Patientenakten für klinische Entscheidungen abgefragt und bewertet werden konnten, ohne Datenverschiebung. Gesundheitsdienstleister adoptierten HTAP-Stores zur Bereitstellung von Vorhersagen während Konsultationen, verbesserten Ergebnisse und senkten Infrastruktur-Overhead, was nachhaltiges mittelfristiges Wachstum untermauerte.

Hemmnisse-Auswirkungsanalyse

| Hemmnis | (~) % Auswirkung auf CAGR-Prognose | Geografische Relevanz | Auswirkungszeitrahmen |

|---|---|---|---|

| Anbieter-Lock-in-Bedenken bezüglich proprietärer In-Memory-Formate | -1.8% | Global, insbesondere Multi-Cloud-Unternehmen betreffend | Kurzer Zeitraum (≤ 2 Jahre) |

| Hochverfügbarkeits-Design-Komplexität für >40 TB Cluster | -1.2% | Unternehmensbereitstellungen in Nordamerika & EU | Mittlerer Zeitraum (2-4 Jahre) |

| Datensouveränitätsgesetze (z.B. China CSL, EU GDPR) begrenzen globale Replikation | -0.9% | EU, China, mit Spillover zu multinationalen Bereitstellungen | Langer Zeitraum (≥ 4 Jahre) |

| Quelle: Mordor Intelligence | |||

Anbieter-Lock-in-Bedenken bezüglich proprietärer Formate

Redis' Lizenzwechsel in 2024 verstärkte die Käufer-Vorsicht gegenüber proprietären Formaten und spornte AWS, Google und Oracle an, die Valkey-Fork unter der Linux Foundation zu unterstützen. Unternehmen, die mehrjährige Datenbankprojekte budgetierten, berücksichtigten Exit-Kosten und verlangsamten Kaufzyklen. Zur Risikominderung adoptierten einige Multi-Datenbank-Orchestrierungsschichten, aber diese Abstraktionen führten Latenz-Strafen ein, die Speichergeschwindigkeits-Gewinne teilweise kompensierten.

Hochverfügbarkeits-Design-Komplexität für große Cluster

Cluster größer als 40 TB stießen auf Protokoll-Overhead, der Replikat-Synchronisationszeiten degradierte. Redis Clusters Gossip-Ansatz skalierte quadratisch, während Dragonflys alternative Orchestrierung sich verbesserte, aber immer noch komplexe Überwachungsskripte erforderte. Finanzdienstleistungs-Workloads, die fünf Neunen Uptime fordern, zögerten, die größten Datensätze vollständig in den Speicher zu migrieren und entschieden sich für Hybrid-Schichten, die Spitzenleistung verwässerten.

Segmentanalyse

Nach Verarbeitungstyp: HTAP emergiert als vereinheitlichte Architektur

Das OLTP-Segment hielt 45,3% des In-Memory Database-Marktanteils in 2024 und unterstrich die anhaltende Abhängigkeit von hochintegren Transaktions-Workloads in Banking, E-Commerce und ERP-Systemen. Die Nachfrage persistierte, da geschäftskritische Datensätze immer noch ACID-Compliance erforderten, wobei Unternehmen eine Leistungsprämie für Sub-Millisekunden-Commits zahlten. OLAP-Bereitstellungen adressierten etablierte Business-Intelligence-Front-Ends, wuchsen aber langsam, da Analytics zu flexibleren Engines verschoben.

HTAP kletterte mit einer 21,1% CAGR-Prognose von 2025 bis 2030, da Firmen Einfachheit einer einzigen Plattform suchten. GridGains Plattform zeigte bis zu 1.000× Geschwindigkeitssteigerungen über festplattenbasierte Systeme bei Beibehaltung von ANSI SQL-99-Unterstützung.[2]GridGain Systems, "Hybrid Transactional/Analytical Processing (HTAP)," gridgain.com Echtzeit-Risikoberechnungen und Supply-Chain-Zwillinge benötigten gleichzeitigen Lese-Schreib-Zugang, was HTAP zur bevorzugten Architektur machte. Die Konvergenz erschloss inkrementelles Budget von Abteilungen, die zuvor zwischen Betrieb und Analytics isoliert waren, und trieb den In-Memory Database-Markt zu vereinheitlichten Designs.

Notiz: Segmentanteile aller individuellen Segmente verfügbar beim Berichtskauf

Nach Bereitstellungsmodus: Edge Computing treibt eingebettetes Wachstum

On-Premise-Installationen eroberten 55,4% des 2024-Umsatzes, da regulierte Sektoren volle Kontrolle über Datenresidenz und maßgeschneiderte HA-Architekturen benötigten. Legacy-Unternehmenssoftware-Stacks integrierten eng mit On-Premise-Datenbanken und verankerten Ausgaben, selbst als Public Clouds reiften. Cloud-Bereitstellungen machten dennoch Fortschritte, da digital-native Firmen verwaltete Services adoptierten, um Infrastrukturverwaltung zu vermeiden.

Edge- und eingebettete Bereitstellungen zeigten einen 23,2% CAGR-Ausblick, befeuert durch vernetzte Autos und IIoT-Gateways. Moderne Fahrzeuge generieren etwa 300 TB jährlich, was In-Vehicle-Verarbeitung für autonome Features erfordert. TDengine erreichte 10× Kompression über Elasticsearch in Smart-Vehicle-Telemetrie und reduzierte Bandbreite für Upstream-Transfers. Hersteller wandten ähnliche Strategien in Produktionslinien an, um Defekte sofort zu erkennen. Die Verschiebung signalisierte, dass Leistungsgewinne, die einst Rechenzentren vorbehalten waren, jetzt am Edge unverzichtbar waren und den In-Memory Database-Marktfußabdruck erweiterten.

Nach Datenmodell: Multi-Model-Architekturen gewinnen Traktion

Relationale SQL-Engines behielten 60,4% Umsatz in 2024, da Jahrzehnte von Anwendungscode und Entwicklerfähigkeiten an das Modell gebunden blieben. Unternehmen zögerten, Kernsysteme umzuschreiben und bewahrten relationale Vorrangstellung, selbst als neue Anwendungsfälle entstanden. NoSQL-Kategorien-Key-Value, Document, Graph-adressierten flexible Schemas, bedienten aber schmalere Workloads.

Multi-Model-Plattformen prognostizierten eine 20,1% CAGR, da KI-Workloads vereinheitlichte Speicherung für strukturierte Datensätze, Vektoren und unstrukturierten Text erfordern. Hazelcast fügte Vektorsuche neben traditionellen Key-Value-APIs hinzu. Die Konsolidierung verschiedener Datentypen in einen einzigen Speicherpool senkte operative Komplexität und Latenz und ermöglichte konversationelle KI, Betrugsgraphen und Empfehlungs-Pipelines. Dieses Momentum soll den In-Memory Database-Markt über heterogene Datenlandschaften erweitern.

Nach Unternehmensgröße: KMU beschleunigen Cloud-Adoption

Großunternehmen machten 70,5% des Umsatzes in 2024 aus aufgrund der Kapitalintensität von Petabyte-Skalen-Bereitstellungen und strengen SLA-Anforderungen. Globale Banken, Telekom-Carrier und Luft- und Raumfahrtfirmen investierten in redundante Cluster mit Terabytes von DRAM zur Aufrechterhaltung der Geschäftskontinuität. Ihre Budgetkapazität schützte sie vor hohen Pro-Gigabyte-Kosten.

Kleine und mittlere Unternehmen sollen mit 18,1% CAGR durch verwaltete Services steigen. AWS führte Aurora DSQL ein, um verteilte SQL-Semantik mit In-Memory-ähnlicher Leistung zu kombinieren. Durch Auslagerung von Skalierung und Patching an Cloud-Anbieter erhielten Startups Zugang zu Unternehmensklassen-Latenz für Micro-SaaS-Produkte ohne Personalkosten-Overhead. ElastiCaches Valkey-Unterstützung senkte Lizenzkosten und beschleunigte die Demokratisierung des In-Memory Database-Marktes unter budgetbeschränkten Firmen.

Nach Anwendung: KI/ML-Model-Serving treibt Innovation

Echtzeitverarbeitung von Transaktionen behielt den größten Anteil mit 40,3% in 2024, wobei Aktienhandel, Zahlungs-Gateways und Lagersysteme auf sofortige Commits angewiesen waren. Operative Analytics lieferte Dashboards für Fertigung und IT-Observability, verlangsamte sich aber, da neuere KI-Anwendungsfälle Ausgaben eroberten.

KI/ML-Model-Serving soll mit 24,2% CAGR expandieren, da Unternehmen Vektorindizes und Embeddings direkt in Datenbanken für Inferenz einbetten. Microsoft schlug Managed Retention Memory vor, um Latenz bei großen Sprachmodell-Ausführungen zu reduzieren. Das Muster integriert Inferenz innerhalb der Transaktionsschicht und eliminiert WAN-Hops zwischen Model-Servern und Quelldaten. Hybrid-Workloads, die ACID-Updates mit Vektor-Ähnlichkeitssuchen kombinieren, sollen den inkrementellen In-Memory Database-Marktumsatz dominieren.

Nach Endnutzer-Industrie: Gesundheitswesen führt digitale Transformation

BFSI kommandierte 28,2% Umsatz in 2024 und spiegelte frühe Adoption für Hochfrequenzhandel und Betrugsprävention wider. Regulatorische Mandate für Echtzeit-Berichterstattung und strenge RTO-Anforderungen sicherten fortgesetzte Investitionen. Telekommunikation wendet In-Memory-Analytics für Netzwerk-Orchestrierung und Kundenerfahrungs-Insights an und erhält einen stabilen Anteil.

Gesundheitswesen und Biowissenschaften zeigen einen 18,1% CAGR-Ausblick. Corti veröffentlichte spezialisierte KI-Infrastruktur, die sofortigen Zugang zu Patientendaten für diagnostische Unterstützung erfordert. Electronic Health Record-Anbieter integrierten HTAP-Datenbanken zur Speisung klinischer Entscheidungsalgorithmen, verbesserten Pflegequalität und operative Effizienz. Fertigung investierte in prädiktive Wartung und Einzelhandel nutzte Personalisierungs-Engines, wodurch die gesamte In-Memory Database-Industrie diversifiziert blieb.

Geografieanalyse

Asien-Pazifik verzeichnete den größten regionalen Umsatz mit 32,2% in 2024 und behielt einen 17,1% CAGR-Ausblick. Nationale Industrie 4.0-Programme in China, Japan und Indien spornten Fabrikautomatisierung an, die In-Memory-Historian-Datenbanken für Sub-Sekunden-MES-Feedback-Schleifen erforderte. General Motors verknüpfte mehr als 100.000 operative Technologie-Verbindungen in seinem MES 4.0-Rollout und veranschaulichte das Ausmaß von Edge-Bereitstellungen. Lokale Anbieter wie Nautilus Technologies entwickelten fortgeschrittene einheimische relationale Engines und reduzierten die Abhängigkeit von ausländischem IP.[3]Nautilus Technologies, "Tsurugi MCP対応版をOSSにてリリース," prtimes.jp

Nordamerika formte einen reifen aber innovationsreichen Markt, der sich auf Finanzdienstleistungen, Hyperscale-Clouds und autonome Fahrzeug-F&E konzentrierte. Oracle und Google vertieften ihre Partnerschaft, um Oracle Database-Services nativ auf Google Cloud zu betreiben und Unternehmens-SQL-Fähigkeiten mit KI-Beschleunigern zu verbinden. Die Venture-Finanzierung der Region unterstützte aufkommende Player wie Dragonfly und intensivierte die Wettbewerbsbewegung.

Europa priorisierte Datensouveränitäts-Compliance unter GDPR und trieb Hybrid-Cloud-Adoption an, während On-Premise-Cluster kombiniert mit verwalteten Services in lokalen Rechenzentren bevorzugt wurden. Oracle erweiterte Database@Azure-Abdeckung auf zusätzliche EU-Regionen zur Erfüllung von Residenz-Regeln. Der Kontinent sah auch Gesundheitswesen-Bereitstellungen von HTAP-Datenbanken zur Förderung von KI-Diagnostik unter strengen Datenschutz-Frameworks.

Der Nahe Osten und Afrika investierten in Smart-City-Glasfaser- und 5G-Backbones, was zu Pilot-IIoT-Bereitstellungen führte, die Echtzeit-Analytics erfordern. Südamerika gewann Traktion in Bergbaubetrieben und digitalem Banking, wo niedriglatente Betrugserkennung Premium-speicherzentrierte Systeme rechtfertigte. Obwohl absolute Ausgaben in diesen beiden Regionen bescheiden blieben, erweiterte zweistelliges Wachstum die globale Vielfalt des In-Memory Database-Marktes.

Wettbewerbslandschaft

Der In-Memory Database-Markt blieb mäßig fragmentiert, wobei SAP, Oracle, Microsoft und IBM breite Unternehmens-Suiten nutzten, um Incumbent-Stellung zu behalten. Ihre Roadmaps integrieren In-Database-Vektor-Stores und ML-Beschleuniger, ausgerichtet auf Kundenanforderungen für vereinheitlichte Plattformen. Redis' Lizenzwechsel veranlasste Hyperscaler, Valkey zu unterstützen und veranschaulichte, wie Governance-Modelle Wettbewerbslinien umgestalten können.

Spezialist-Anbieter wie Aerospike und Hazelcast konkurrierten mit vorhersagbarer, niedriglatenter Skalierung und niedrigeren Gesamtkosten pro Gigabyte. Aerospikes Erfolg bei PayPal bewies die Kapazität zur Verarbeitung von Echtzeit-Betrugssignalen auf Commodity-Hardware. Hazelcast veröffentlichte Platform 5.5 mit erweiterten Konnektoren, die KI-Pipeline-Integrationen vereinfachten.[4]Hazelcast, "Announcing Hazelcast Platform 5.5 Release," hazelcast.com Dragonfly positionierte sich als Drop-in-Ersatz für Redis mit überlegener Single-Core-Effizienz und forderte Incumbents in der Entwickler-Community heraus.

Strategische Allianzen beschleunigten sich. Oracles April-2025-Vereinbarung mit Google Cloud ermöglichte Unternehmen, Datenbanken und KI-Toolchains ohne Cross-Cloud-Egress-Strafen zu konsolidieren. AWS bildete eine agentische KI-Gruppe, um Modellentwicklung enger mit In-Memory-Datenservices zu verknüpfen. Markteintrittsbarrieren stiegen um Ökosystem-Tiefe und integrierte KI-Features und konsolidierten Anteile unter Anbietern, die sowohl transaktionale Exzellenz als auch Vektorsuche nativ anbieten können.

In-Memory Database-Branchenführer

-

IBM Corporation

-

Microsoft Corporation

-

Oracle Corporation

-

SAP SE

-

TIBCO Software Inc.

- *Haftungsausschluss: Hauptakteure in keiner bestimmten Reihenfolge sortiert

Jüngste Branchenentwicklungen

- Mai 2025: AWS kündigte die allgemeine Verfügbarkeit von Amazon Aurora DSQL an, um verteilte SQL-Skalierbarkeit mit In-Memory-ähnlicher Leistung zu liefern.

- Mai 2025: Amazon ElastiCache und MemoryDB fügten Unterstützung für Valkey 7.2 hinzu und boten Open-Source-Kompatibilität und wettbewerbsfähige Preise.

- April 2025: Oracle und Google Cloud stellten ein Partnerprogramm vor, das Oracle Database-Services nativ auf Google Cloud betreibt.

- März 2025: AWS schuf eine neue agentische KI-Gruppe unter Swami Sivasubramanian zur Integration von KI mit Datenbank-Infrastruktur.

Globaler In-Memory Database-Marktberichtsumfang

In-Memory Databases sind zweckgebaute Systeme, die Daten hauptsächlich im Speicher ablegen, im Gegensatz zu Datenbanken, die Informationen auf Festplatten oder SSDs speichern. In-Memory-Datenspeicherung ist darauf ausgelegt, schnelle Reaktionszeiten durch Beseitigung der Notwendigkeit für Festplattenzugriff zu bieten.

Der In-Memory Database-Markt ist segmentiert nach Branchengröße (klein, mittel und groß), Endnutzer (BFSI, Einzelhandel, Logistik und Transport, Unterhaltung und Medien, Gesundheitswesen, IT und Telekommunikation und andere) und Geografie (Nordamerika (USA, Kanada), Europa (Deutschland, UK, Frankreich und übriges Europa), Asien-Pazifik (Indien, China, Japan und übriges Asien-Pazifik) und Rest der Welt).

Die Marktgrößen und Prognosen werden in Werten (USD Millionen) für alle oben genannten Segmente bereitgestellt.

| OLTP |

| OLAP |

| Hybrid Transactional/Analytical Processing (HTAP) |

| On-Premise |

| Cloud |

| Edge/Eingebettet |

| Relational (SQL) |

| NoSQL (Key-Value, Document, Graph) |

| Multi-Model |

| Kleine und mittlere Unternehmen (KMU) |

| Großunternehmen |

| Echtzeitverarbeitung von Transaktionen |

| Operative Analytics und BI-Dashboards |

| KI/ML-Model-Serving |

| Caching und Session-Stores |

| BFSI |

| Telekommunikation und IT |

| Einzelhandel und E-Commerce |

| Gesundheitswesen und Biowissenschaften |

| Fertigung und Industrial IoT |

| Medien und Unterhaltung |

| Regierung und Verteidigung |

| Andere (Energie, Bildung, etc.) |

| Nordamerika | Vereinigte Staaten | |

| Kanada | ||

| Mexiko | ||

| Europa | Deutschland | |

| Frankreich | ||

| Vereinigtes Königreich | ||

| Nordics | ||

| Übriges Europa | ||

| Asien-Pazifik | China | |

| Taiwan | ||

| Südkorea | ||

| Japan | ||

| Indien | ||

| Übriges Asien-Pazifik | ||

| Südamerika | Brasilien | |

| Mexiko | ||

| Argentinien | ||

| Übriges Südamerika | ||

| Naher Osten und Afrika | Naher Osten | Saudi-Arabien |

| Vereinigte Arabische Emirate | ||

| Türkei | ||

| Übriger Naher Osten | ||

| Afrika | Südafrika | |

| Übriges Afrika | ||

| Nach Verarbeitungstyp | OLTP | ||

| OLAP | |||

| Hybrid Transactional/Analytical Processing (HTAP) | |||

| Nach Bereitstellungsmodus | On-Premise | ||

| Cloud | |||

| Edge/Eingebettet | |||

| Nach Datenmodell | Relational (SQL) | ||

| NoSQL (Key-Value, Document, Graph) | |||

| Multi-Model | |||

| Nach Unternehmensgröße | Kleine und mittlere Unternehmen (KMU) | ||

| Großunternehmen | |||

| Nach Anwendung | Echtzeitverarbeitung von Transaktionen | ||

| Operative Analytics und BI-Dashboards | |||

| KI/ML-Model-Serving | |||

| Caching und Session-Stores | |||

| Nach Endnutzer-Industrie | BFSI | ||

| Telekommunikation und IT | |||

| Einzelhandel und E-Commerce | |||

| Gesundheitswesen und Biowissenschaften | |||

| Fertigung und Industrial IoT | |||

| Medien und Unterhaltung | |||

| Regierung und Verteidigung | |||

| Andere (Energie, Bildung, etc.) | |||

| Nach Geografie | Nordamerika | Vereinigte Staaten | |

| Kanada | |||

| Mexiko | |||

| Europa | Deutschland | ||

| Frankreich | |||

| Vereinigtes Königreich | |||

| Nordics | |||

| Übriges Europa | |||

| Asien-Pazifik | China | ||

| Taiwan | |||

| Südkorea | |||

| Japan | |||

| Indien | |||

| Übriges Asien-Pazifik | |||

| Südamerika | Brasilien | ||

| Mexiko | |||

| Argentinien | |||

| Übriges Südamerika | |||

| Naher Osten und Afrika | Naher Osten | Saudi-Arabien | |

| Vereinigte Arabische Emirate | |||

| Türkei | |||

| Übriger Naher Osten | |||

| Afrika | Südafrika | ||

| Übriges Afrika | |||

Im Bericht beantwortete Schlüsselfragen

Wie hoch ist der aktuelle Wert des In-Memory Database-Marktes?

Der In-Memory Database-Markt wurde mit USD 7,08 Milliarden in 2025 bewertet und wird voraussichtlich USD 13,62 Milliarden bis 2030 erreichen.

Welche Region führt das In-Memory Database-Marktwachstum?

Asien-Pazifik führte mit 32,2% Umsatz in 2024 und wird voraussichtlich eine CAGR von 17,1% bis 2030 verzeichnen.

Warum sind HTAP-Architekturen wichtig für KI-Workloads?

HTAP vereinigt transaktionale und analytische Verarbeitung und ermöglicht Echtzeit-Inferenz ohne ETL-Verzögerungen, wie von Oracle HeatWave GenAI gezeigt.

Wie beeinflussen fallende DRAM-Preise die Adoption?

Niedrigere USD/GB-Preise und neue persistente Speicheroptionen reduzieren die Gesamtbetriebskosten und machen In-Memory-Bereitstellungen wirtschaftlich viabel.

Welche Herausforderungen begrenzen sehr große In-Memory-Cluster?

Hochverfügbarkeits-Architektur wird komplex jenseits von 40 TB, wobei Clustering-Protokolle Leistungs-Overhead verursachen.

Seite zuletzt aktualisiert am: