Tamanho e Participação do Mercado de dados centro lâmina servidor

Análise do Mercado de dados centro lâmina servidor pela Mordor inteligência

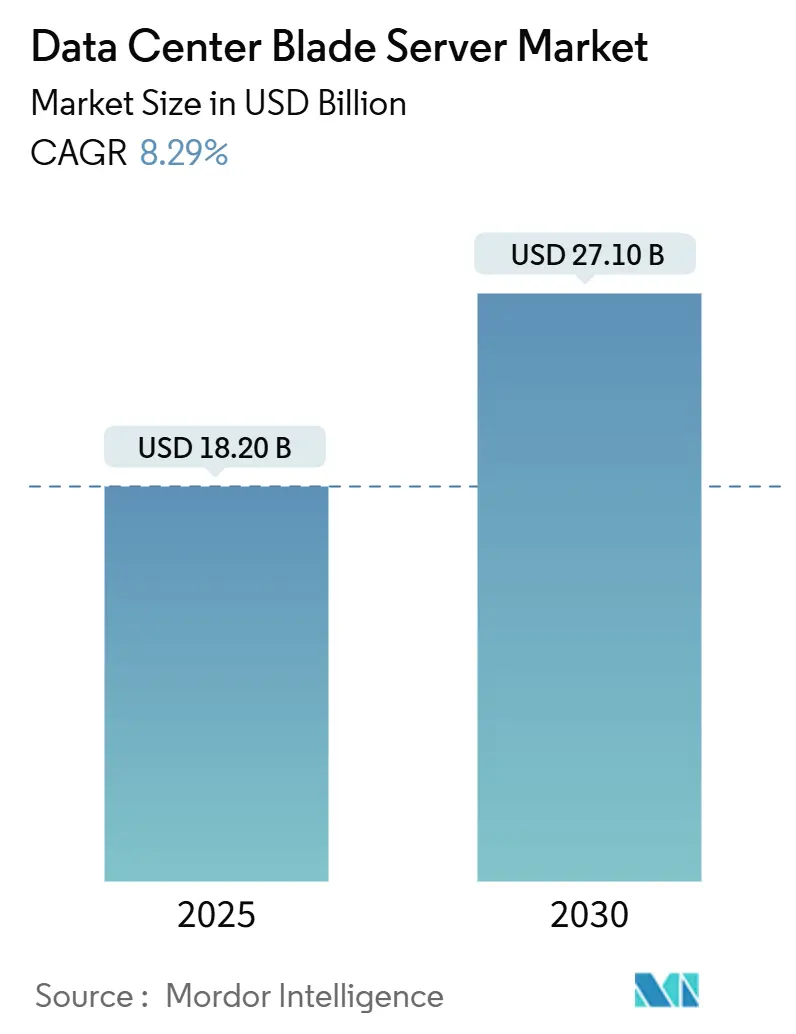

O mercado de dados centro lâmina servidor está avaliado em USD 18,2 bilhões em 2025 e previsto para atingir USD 27,10 bilhões até 2030, expandindo um uma CAGR de 8,29%. O aumento da implantação de cargas de trabalho de IA e aprendizado de máquina está remodelando os requisitos de densidade de computação, empurrando fornecedores em direção um designs de lâmina composáveis e desagregados que separam recursos de computação, armazenamento e rede. Esta mudançum arquitetural permite maior utilização e rápida realocação de cargas de trabalho, enquanto resfriamento líquido direto, backplanes de fotônica de silício e software avançado de gestão de chassis ajudam operadores um gerenciar envelopes de energia de rack que agora excedem 30 kW. um América do Norte mantém liderançum de escala, mas um Ásia-Pacífico está crescendo mais rapidamente com base em grandes construções greenfield na Índia, China e Singapura. Instalações de colocation permanecem o maior grupo de clientes, mas hyperscalers estão definindo um agenda técnica ao migrar para sistemas de lâmina de IA construídos para propósito específico que entregam maior eficiência ao nível do rack.

Principais Conclusões do Relatório

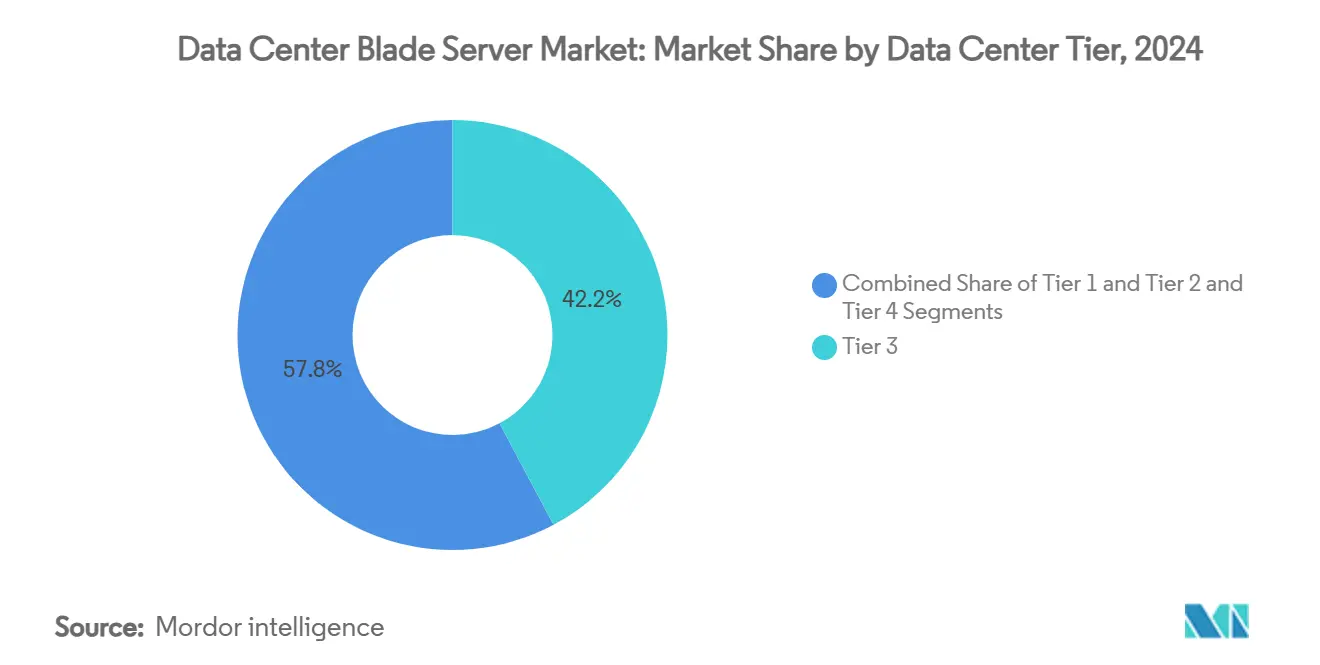

- Por tier de dados centro, instalações Tier 3 lideraram com 42,21% da participação do mercado de dados centro lâmina servidor em 2024, enquanto sites Tier 4 são projetados para crescer um uma CAGR de 12,2% até 2030.

- Por fator de forma, blades de meia altura representaram 48,41% da participação de receita em 2024; blades de um quarto de altura e micro-blades são previstos para expandir um uma CAGR de 14,12% até 2030.

- Por aplicação, virtualização e nuvem privada detiveram 39,12% do tamanho do mercado de dados centro lâmina servidor em 2024; cargas de trabalho de IA/ML devem crescer um uma CAGR de 16,54% entre 2025-2030.

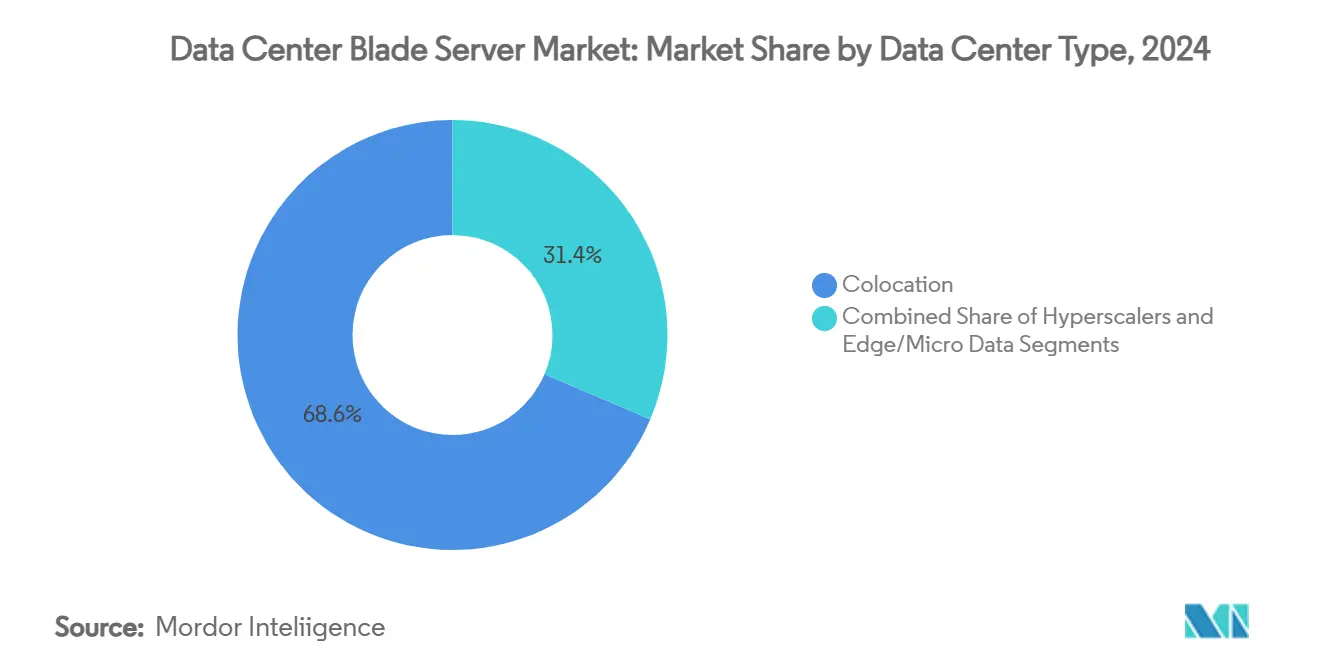

- Por tipo de dados centro, colocation capturou 68,6% de participação do tamanho do mercado de dados centro lâmina servidor em 2024, enquanto hyperscalers estão avançando um uma CAGR de 13,2% no mesmo poríodo.

- Por indústria de uso final, bfsi comandou 26,24% de participação em 2024, e cargas de trabalho de TI-e-telecomunicações são esperadas para registrar uma CAGR de 11,24% até 2030.

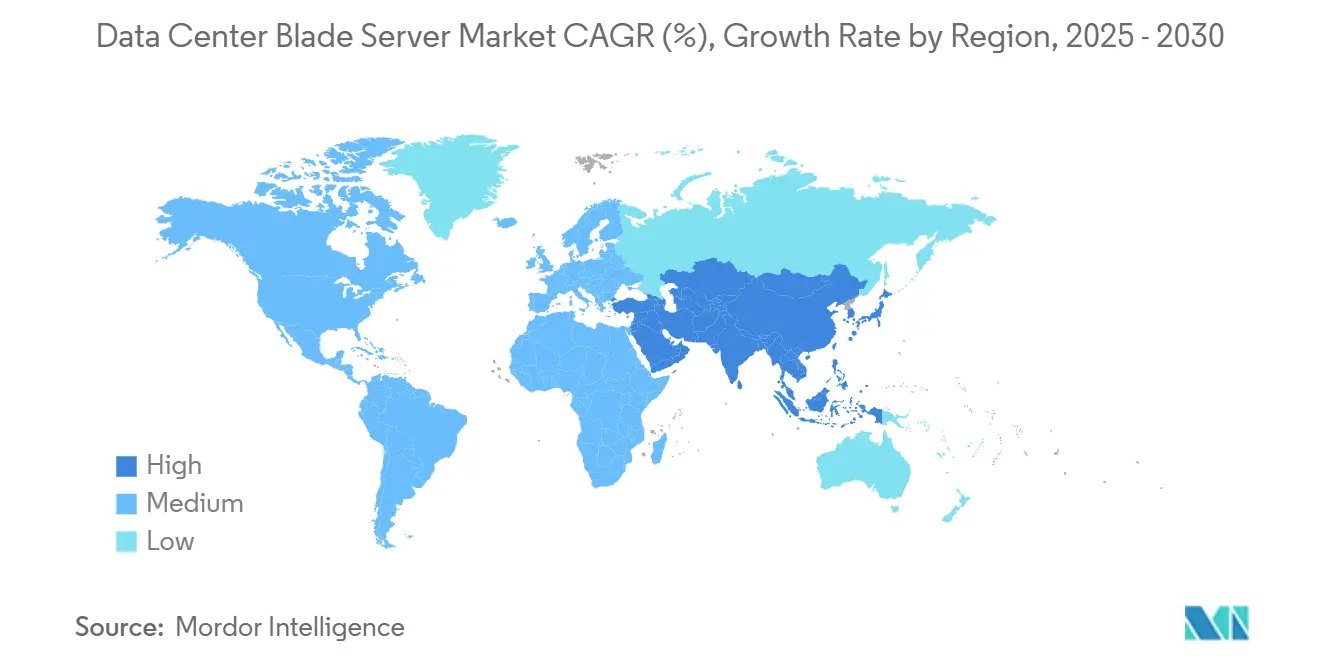

- Regionalmente, América do Norte liderou com 42,23% de participação em 2024; Ásia-Pacífico exibe o crescimento mais rápido um 12,54% CAGR até 2030.

Tendências e Insights do Mercado Global de dados centro lâmina servidor

Análise de Impacto dos Direcionadores

| Direcionador | (~) % Impacto na Previsão CAGR | Relevância Geográfica | Cronograma de Impacto |

|---|---|---|---|

| Aumento da densidade de energia ao nível do rack acomoda cargas de trabalho de IA/ML | 2.8% | Global, com ganhos iniciais na América do Norte, núcleo APAC | Médio prazo (2-4 anos) |

| Convergência borda-nuvem acelerando implantação em DCs micro-modulares | 1.9% | Global, expansão para mercados emergentes | Longo prazo (≥ 4 anos) |

| Altas taxas de consolidação de servidores reduzem OPEX e custo imobiliário | 1.5% | América do Norte & UE, expandindo para APAC | Curto prazo (≤ 2 anos) |

| Chassis preparados para resfriamento líquido ganhando incentivos regulatórios (UE, Singapura) | 1.2% | Núcleo UE, Singapura, expandindo para regiões de clima quente | Médio prazo (2-4 anos) |

| Crescente preferência de hyperscaler por blades composáveis desagregados | 2.1% | Mercados hiperescala globais | Médio prazo (2-4 anos) |

| Ciclos de atualização de hardware permanente (modelo Opex) | 0.8% | Mercados empresariais globalmente | Longo prazo (≥ 4 anos) |

| Fonte: Mordor Intelligence | |||

Aumento da Densidade de Energia ao Nível do Rack Acomoda Cargas de Trabalho de IA/ML

Clusters de inferência e treinamento de IA agora empurram envelopes de rack de 10-15 kW em direção um 30-50 kW. um especificação OSAI do Open Compute projeto visa arquiteturas de rack de 250 kW um 1 MW, incentivando fornecedores de lâmina um integrar reguladores de voltagem de alta eficiência e resfriamento líquido direto.[1]Open Compute projeto, "OCP Open sistemas para artificial inteligência visão," opencompute.org O PowerEdge XE9680L da Dell demonstra como fluxo de ar ao nível do chassis, loops de placa fria, e aceleradores específicos de IA podem coexistir sem throttling térmico. um Agência Internacional de Energia projeta que dados centros focados em IA poderiam consumir 945 TWh até 2030, o que mantém o design de lâmina energeticamente eficiente no centro das estratégias dos operadores.[2]International energia Agency, "energia e IA," iea.org

Convergência Edge-Nuvem Acelerando Implantação em DCs Micro-Modulares

Rollouts de 5g e serviços de ultra-baixa latência empurram computação para um borda da rede, gerando demanda por dados centros micro-modulares que podem ser enviados pré-cabeados e pré-resfriados. um patente do Google para instalações borda modulares confirma um importância de montagens de rack seguras e multilocatário com energia integrada e troca de calor. Operadores de telecomunicações estão alocando uma parcela considerável de seu plano despesas de capital de USD 600 bilhões para tais sites borda, dando aos fornecedores de lâmina uma abertura para fornecer nós de um quarto de altura adaptados para pegadas restritas

Altas Taxas de Consolidação de Servidores Reduzem OPEX e Custo Imobiliário

Blades dual-socket de nova geração alimentados por CPUs de alto número de núcleos podem substituir racks de equipamentos legados. um Supermicro ilustra que um servidor H14 Hyper DP pode executar 3,78× como transações de quatro unidades mais antigas, economizando até USD 2,8 milhões ao longo de cinco anos em licenciamento, energia e custos de espaço. Os estudos de atualização da Lenovo mostram um ROI de 392% quando torres legadas de quatro sockets são trocadas por blades densos de 4U, uma narrativa que ressoa com operadores Tier 3 procurando recuperar espaço no piso

Chassis Preparados para Resfriamento Líquido Ganhando Incentivos Regulatórios

um Regulamentação Ecodesign 2019/424 da UE e um estrutura de localização de dados centro de Singapura recompensam instalações que adotam resfriamento eficiente. um HPE já enviou 200.000 nós resfriados por líquido direto e está avançando variantes 100% sem ventilador voltadas para o próximo ciclo de atualização de IA. Fornecedores capazes de agrupar unidades de distribuição de resfriamento com prateleiras de lâmina ganham vantagem inicial no processo de licitação para sites recém-licenciados.[3]Hewlett Packard empresa, "HPE IA Day Transcript," hpe.com

Análise de Impacto das Restrições

| Restrição | (~) % Impacto na Previsão CAGR | Relevância Geográfica | Cronograma de Impacto |

|---|---|---|---|

| Pico de despesas de capital da fotônica de silício e migração de backplane 800 Gb e | -1.4% | Mercados avançados com requisitos de alta velocidade | Curto prazo (≤ 2 anos) |

| Concentração de fornecedor em ecossistemas de chassis proprietários | -0.9% | Global, com maior impacto em segmentos empresariais | Médio prazo (2-4 anos) |

| Lacuna de habilidades no gerenciamento de arquiteturas múltiplo-fabric desagregadas | -1.1% | Global, aguda em mercados emergentes | Longo prazo (≥ 4 anos) |

| Monetização atrasada de ORAN/5g prolongando ROI para DCs de telecomunicações | -0.7% | Mercados pesados em telecomunicações, particularmente APAC e UE | Médio prazo (2-4 anos) |

| Fonte: Mordor Intelligence | |||

Pico de CapEx da Fotônica de Silício e Migração de Backplane 800 GbE

Mudar para circuitos integrados fotônicos e tecidos de 800 GbE libera ganhos de latência e largura de banda, mas exige novos chassis, conectores mid-plane e placas retimer. Agências nacionais reconhecem o lado positivo da eficiência, mas alertam que implementações precoces suportam custos de capital pesados, particularmente para empresas de médio porte. Pesquisa em desagregação de memória sobre CXL sugere um retorno de múltiplos anos, paraçando operadores um escalonar atualizações

Concentração de Fornecedor em Ecossistemas de Chassis Proprietários

Plataformas de lâmina frequentemente prendem clientes em mid-planes específicos de fornecedor, placas mezzanine e suítes de gerenciamento. Ecossistemas proprietários de grandes incumbentes inflam custos de ciclo de vida e complicam estratégias de nuvem híbrida. Grupos da indústria como o Open Compute projeto respondem com iniciativas de chassis aberto, embora um migração permaneçum incremental porque empresas têm extensas imagens legadas e ferramentas alinhadas um fornecedores atuais

Análise de Segmento

Por Tier de Data Center: Tier 4 Impulsiona Adoção de Inovação

Instalações Tier 3 possuíam 42,21% do mercado de dados centro lâmina servidor em 2024, já que seu perfil de redundância N+1 se alinha com SLAs empresariais mainstream. Sites Tier 4, embora menores em contagem, são previstos para crescer um 12,2% CAGR graçcomo um demandas de tolerância um falhas de clusters de treinamento de IA. Este momentum posiciona Tier 4 como o campo de prova para chassis 100% resfriados um líquido e interconexões de fotônica de silício.

Operadores de instalações Tier 1 e Tier 2, tipicamente servindo cargas de trabalho de agregação borda ou filial, adotam blades padronizados para manter disciplina de custo enquanto ganham melhor automação. O relatório infraestrutura Masons vincula 90% do crescimento atual de energia ao treinamento de modelos de IA, uma carga agora se propagando para sites modestos que devem acomodar maior consumo de energia e densidade de rack. Como resultado, fornecedores estão empacotando kits que retrofitam salas de tier mais baixo com corredores de contenção e trocadores de calor de porta traseira, preservando momentum para o mercado mais amplo de dados centro lâmina servidor.

Nota: Participações de segmento de todos os segmentos individuais disponíveis mediante compra do relatório

Por Fator de Forma: Micro-Blades Remodelam Implantações Edge

Blades de meia altura entregaram 48,41% da receita em 2024, suportando CPUs dual-socket, amplos slots DIMM e expansão PCIe para um maioria das tarefas de virtualização e banco de dados. Eles permanecem o cavalo de trabalho dos racks de colocation empresarial. Modelos de altura completa continuam um servir cargas de trabalho quad-socket e memória-bound como análises em memória.

Nós de um quarto de altura e micro-lâmina são um fatia de crescimento mais rápido um 14,12% CAGR porque cabem 16-32 sleds de computação por prateleira 10U, ideal para pegadas borda limitadas. Fornecedores agora integram aceleradores GPU nesses sleds compactos, permitindo inferência em tempo real em sites de torre celular. Compatibilidade com especificações Open rack v3 permite implantação mista dentro do mesmo gabinete, sustentando um narrativa de expansão borda do mercado de dados centro lâmina servidor.

Por Aplicação/Carga de Trabalho: IA/ML Transforma Requisitos de Servidor

Cargas de trabalho de virtualização e nuvem privada ainda comandam 39,12% do tamanho do mercado de dados centro lâmina servidor em 2024, aproveitando um alta largura de banda de memória e rede quente-swap integrada em chassis modernos. Esses ambientes valorizam o plano de gerenciamento consolidado que blades fornecem através de milhares de VMs.

Clusters de IA e ML, no entanto, exibem um trajetória mais forte com uma CAGR de 16,54% à medida que todos os setores integram modelos generativos nas operações diárias. OEMs respondem oferecendo sleds compatíveis com OCP que hospedam oito GPUs ligadas através de NVLink e alimentadas por conectores OCP Plus de 1000 W. Blades centrados em armazenamento agora incorporam dirige EDSFF para alimentar esses aceleradores com largura de banda PCIe Gen 5 sustentada, garantindo que o mercado de dados centro lâmina servidor permaneçum um espinha dorsal de computação para algoritmos intensivos em dados.

Por Tipo de Data Center: Hyperscalers Impulsionam Inovação Técnica

Provedores de colocation detiveram 68,6% de participação do tamanho do mercado de dados centro lâmina servidor em 2024, monetizando gaiolas de alta densidade em um modelo por quilowatt. Popularidade entre PMEs e indústrias regulamentadas sustenta essa dominância. Muitas novas construções colo na Índia e Malásia incluem trocadores de porta traseira de água gelada para se qualificar para cargas de trabalho de IA.

Hyperscalers registram uma CAGR de 13,2% até 2030, usando designs de lâmina personalizados para acelerar treinamento de IA, sharding de banco de dados e armazenamento em larga escala. um arquitetura de rack OSAI da OCP foi amplamente criada por engenheiros de hyperscaler, sublinhando sua influência nas prioridades do roteiro. Empresas seguem sua liderançum pilotando pools menores de lâmina composáveis para aplicações sensíveis à latência, adicionando ainda mais profundidade ao mercado de dados centro lâmina servidor.

Nota: Participações de segmento de todos os segmentos individuais disponíveis mediante compra do relatório

Por Indústria de Uso Final: BFSI Lidera Curva de Adoção

um vertical bfsi representou 26,24% da participação do mercado de dados centro lâmina servidor em 2024, refletindo o apetite do setor por latência determinística e redundância multicamadas em plataformas de pagamento, risco e fraude. Blades AMD e Intel de alto núcleo alimentam simulações Monte Carlo em larga escala e negociação de alta frequência.

Provedores de telecomunicações e serviços em nuvem estão em um caminho de CAGR de 11,24% enquanto implementam estruturas 5g e ORAN que dependem de nuvens borda e funções de rede containerizadas. O Bare metal Orchestrator da Dell automatiza provisionamento de lâmina nessas nuvens telco, espelhando metodologias de hyperscaler. Saúde, manufatura, energia e agências do setor público todos elevam demanda de lâmina introduzindo pipelines de inferência de IA em configurações regulamentadas, ampliando ainda mais o mercado de dados centro lâmina servidor.

Análise Geográfica

um América do Norte controlou 42,23% do mercado de dados centro lâmina servidor em 2024, alimentado por campi hiperescala no Norte da Virgínia, Texas e Vale do Silício. O Lawrence Berkeley National laboratório calculou 176 TWh de uso de eletricidade de dados centro dos EUA em 2023, aumentando um urgência para blades resfriados um líquido que cortam PUEs de instalação. Canadá e México adicionam demanda incremental através de zonas regionais de nuvem soberana e recuperação de desastres.

um Ásia-Pacífico é o teatro de crescimento mais rápido um 12,54% CAGR de 2025-2030. um China implanta clusters massivos de nuvem de IA, enquanto um Índia precisa expandir capacidade instalada de 1,35 GW para 5 GW até 2030 para acompanhar o ritmo das metas da economia digital. Estruturas de política em Singapura concedem licençcomo de capacidade preferencialmente um designs que incluem blades de alta densidade e chillers de recuperação de calor. Japão e Austrália estendem um pegada borda ao longo de estações de aterragem de cabo submarino, incorporando blades de um quarto de altura para cache de conteúdo.

um Europa mostra expansão constante sob regras rigorosas de eficiência e soberania de dados. Revisões do Ecodesign 2019/424 encorajam chassis de lâmina que suportam resfriamento com água morna acima de 35 °c, facilitando integração com loops de calor distrital. O Oriente Médio e África atraem investimento para sobre-ramps de nuvem servindo clientes de fintech e jogos. Instalações da América do Sul se agrupam ao redor dos hubs de intercâmbio de Internet do Brasil, onde operadores implementam blades composáveis para atender picos de tráfego sazonal. Essas dinâmicas regionais reforçam um relevância global do mercado de dados centro lâmina servidor.

Cenário Competitivo

O mercado de dados centro lâmina servidor apresenta plataformas estabelecidas da Dell tecnologias, Hewlett Packard empresa e Cisco sistemas que combinam servidores, armazenamento e gerenciamento de fabric sob conjuntos de ferramentas unificadas. Esses líderes complementam blades x86 com opções ARM e GPU para acompanhar o ritmo de cargas de trabalho de IA e confiançum zero. um Supermicro acelera ganhos de participação entregando chassis de blocos de construção que integram resfriamento líquido direto e tecidos PCIe Gen 5 enquanto encurta lead times através de customização em massa modular.

um competição gira em torno da integração vertical em silício e resfriamento. Os blades mais recentes da Dell combinam CPUs AMD EPYC 9005 com placas frias DLC, e um HPE envia nós imersos em líquido sem ventilador para fábricas de IA em escala de rack. um Cisco reforçum sua linha UCS com chips de fabric unificado que colapsam tráfego ethernet e fibra Channel em uma única pista, reduzindo custos de cabeamento.

Oportunidades de espaço em branco estão em mid-planes de padrão aberto que mitigam fornecedor trancar-em e em micro-blades otimizados para borda entregando uplinks de 40 Gbit dentro de profundidades de 250 mm. Start-ups como Liqid permitem pools composáveis de clarão e GPU que se conectam sobre fabric PCIe, permitindo que operadores rebalanceiem recursos dinamicamente. Pressão regulatória do energia STAR 4.0 continua um empurrar o ecossistema em direção um metas de eficiência mais altas, garantindo que inovação em energia e resfriamento permaneçum central à estratégia competitiva

Líderes da Indústria de dados centro lâmina servidor

-

Cisco sistemas Inc.

-

Hewlett Packard empresa Co

-

Dell, Inc.

-

Huawei tecnologias

-

Lenovo grupo

- *Isenção de responsabilidade: Principais participantes classificados em nenhuma ordem específica

Desenvolvimentos Recentes da Indústria

- Maio de 2025: Dell tecnologias lançou o lâmina servidor PowerEdge M7725, projetado para computação de alta densidade com dois processadores AMD EPYC 9005 Series e Resfriamento Líquido Direto, compatível com especificações Open rack v3.

- Março de 2025: Supermicro introduziu um lâmina de armazenamento todos-clarão petascale usando um CPU NVIDIA Grace, suportando 983 TB por nó e escalando para 39,3 PB por rack.

- Janeiro de 2025: O Open Compute projeto lançou um iniciativa Open sistemas para IA (OSAI) para padronizar racks modulares de servidor de IA suportando envelopes de energia de 250 kW-1 MW. Open Compute projeto

- Janeiro de 2025: Supermicro iniciou embarques em volume de servidores de máxima desempenho apresentando processadores Intel Xeon 6900 com resfriamento líquido direct-para-chip para cargas de trabalho de IA e HPC. Supermicro

- Outubro de 2024: Hewlett Packard empresa destacou progresso em resfriamento líquido direto e blades de nuvem híbrida, observando embarque de mais de 200.000 nós DLC desde 2018. Hewlett Packard empresa

- Setembro de 2024: O Open Compute projeto Global Summit exibiu protótipos de lâmina desagregados e designs de rack de IA generativa com distribuição automatizada de refrigerante. Open Compute projeto

Escopo do Relatório Global do Mercado de dados centro lâmina servidor

Um lâmina servidor é um pequeno servidor autônomo composto por unidades centrais de processamento que podem caber dentro de um gabinete com outros lâmina servidores. lâmina servidores são projetados para superar como restrições de espaço e energia de um ambiente típico de dados centro. O estudo do mercado de dados centro lâmina servidor está limitado aos tipos de dados centro lâmina servidores oferecidos pelos fornecedores para aplicação em uma ampla gama de indústrias ao redor do mundo.

O Mercado de dados centro lâmina servidor é segmentado por Tipo de dados centro (Tier 1, Tier 2, Tier 3, Tier 4), vertical de Usuário Final (bfsi, Manufatura, Energia e Utilidades, Saúde), e Geografia (América do Norte (Estados Unidos, Canadá), Europa (Alemanha, Reino Unido), Ásia-Pacífico (China, Japão, Índia), América Latina (Brasil, México), e Oriente Médio e África (Emirados Árabes Unidos, Arábia Saudita)).

Os tamanhos e previsões do mercado são fornecidos em termos de valor (USD milhões) para todos os segmentos acima.

| Tier 1 e 2 |

| Tier 3 |

| Tier 4 |

| Blades de Meia Altura |

| Blades de Altura Completa |

| Blades de Um Quarto de Altura / Micro-blades |

| Virtualização e Nuvem Privada |

| Computação de Alto Desempenho (HPC) |

| Inteligência Artificial/Aprendizado de Máquina e Análise de Dados |

| Centrado em Armazenamento |

| Gateways Edge / IoT |

| Hyperscalers/Provedor de Serviços em Nuvem |

| Instalações de Colocation |

| Empresarial e Edge |

| BFSI |

| TI e Telecom / CSPs |

| Saúde e Ciências da Vida |

| Manufatura e Indústria 4.0 |

| Energia e Utilidades |

| Governo e Defesa |

| América do Norte | Estados Unidos |

| Canadá | |

| México | |

| Europa | Reino Unido |

| Alemanha | |

| França | |

| Itália | |

| Espanha | |

| Resto da Europa | |

| Ásia-Pacífico | China |

| Japão | |

| Índia | |

| Singapura | |

| Austrália | |

| Malásia | |

| Resto da Ásia-Pacífico | |

| América do Sul | Brasil |

| Chile | |

| Argentina | |

| Resto da América do Sul | |

| Oriente Médio | Emirados Árabes Unidos |

| Arábia Saudita | |

| Turquia | |

| Resto do Oriente Médio | |

| África | África do Sul |

| Nigéria | |

| Resto da África |

| Por Tier de Data Center | Tier 1 e 2 | |

| Tier 3 | ||

| Tier 4 | ||

| Por Fator de Forma | Blades de Meia Altura | |

| Blades de Altura Completa | ||

| Blades de Um Quarto de Altura / Micro-blades | ||

| Por Aplicação / Carga de Trabalho | Virtualização e Nuvem Privada | |

| Computação de Alto Desempenho (HPC) | ||

| Inteligência Artificial/Aprendizado de Máquina e Análise de Dados | ||

| Centrado em Armazenamento | ||

| Gateways Edge / IoT | ||

| Por Tipo de Data Center | Hyperscalers/Provedor de Serviços em Nuvem | |

| Instalações de Colocation | ||

| Empresarial e Edge | ||

| Por Indústria de Uso Final | BFSI | |

| TI e Telecom / CSPs | ||

| Saúde e Ciências da Vida | ||

| Manufatura e Indústria 4.0 | ||

| Energia e Utilidades | ||

| Governo e Defesa | ||

| Por Geografia | América do Norte | Estados Unidos |

| Canadá | ||

| México | ||

| Europa | Reino Unido | |

| Alemanha | ||

| França | ||

| Itália | ||

| Espanha | ||

| Resto da Europa | ||

| Ásia-Pacífico | China | |

| Japão | ||

| Índia | ||

| Singapura | ||

| Austrália | ||

| Malásia | ||

| Resto da Ásia-Pacífico | ||

| América do Sul | Brasil | |

| Chile | ||

| Argentina | ||

| Resto da América do Sul | ||

| Oriente Médio | Emirados Árabes Unidos | |

| Arábia Saudita | ||

| Turquia | ||

| Resto do Oriente Médio | ||

| África | África do Sul | |

| Nigéria | ||

| Resto da África | ||

Principais Questões Respondidas no Relatório

Qual é o tamanho atual do Mercado de dados centro lâmina servidor?

O Mercado de dados centro lâmina servidor está projetado para registrar uma CAGR de 8,29% durante o poríodo de previsão (2025-2030)

Qual é o tamanho atual do mercado de dados centro lâmina servidor?

O tamanho do mercado de dados centro lâmina servidor está em USD 18,2 bilhões em 2025 e é projetado para atingir USD 27,10 bilhões até 2030.

Qual tier de dados centro implanta mais lâmina servidores hoje?

Instalações Tier 3 lideram com 42,21% de participação de mercado porque sua redundância N+1 equilibra tempo de atividade e custo para cargas de trabalho empresariais mainstream.

Quão rápido está crescendo o segmento de carga de trabalho de IA/ML dentro de ambientes lâmina?

Cargas de trabalho de IA/ML em blades são previstas para expandir um uma CAGR de 16,54% de 2025-2030, superando em muito um virtualização tradicional.

Por que blades resfriados um líquido estão ganhando tração?

Regulamentações na UE e Singapura recompensam resfriamento eficiente, e racks de IA frequentemente excedem 30 kW, tornando o resfriamento líquido direto essencial para desempenho e economia de energia

Qual região está expandindo capacidade de lâmina servidor mais rapidamente?

Ásia-Pacífico é um região de crescimento mais rápido, pronta para uma CAGR de 12,54% à medida que países como Índia, China e Singapura constroem novos sites hiperescala e borda.

Quais fatores restringem adoção mais ampla de lâmina em empresas de médio porte?

Alto despesas de capital inicial para backplanes de fotônica de silício e dependência de ecossistemas de chassis proprietários retardam implantação para operadores com orçamentos restringidos.

Página atualizada pela última vez em: