Tamanho e Participação do Mercado de Banco de Dados em Memória

Análise do Mercado de Banco de Dados em Memória pela Mordor Intelligence

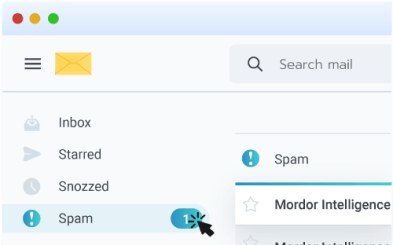

O tamanho do mercado global de Banco de Dados em Memória foi de USD 7,08 bilhões em 2025 e deve atingir USD 13,62 bilhões até 2030, avançando a uma TCAC de 13,98% durante o período de previsão. Requisitos de performance em sub-milissegundos de microsserviços nativos da nuvem, motores de inferência de IA e plataformas de análise de streaming continuaram a empurrar as empresas em direção a arquiteturas centradas em memória. Preços mais baixos de DRAM e a chegada de módulos de memória persistente baseados em CXL reduziram o custo total de propriedade, incentivando mais cargas de trabalho a migrar de sistemas baseados em disco. Implementações na borda em veículos conectados e plantas de IoT industrial expandiram ainda mais a demanda porque o processamento local evita penalidades de latência de rede. A dinâmica competitiva permaneceu fluida à medida que fornecedores tradicionais aprofundaram integrações com nuvens de hiperescala enquanto forks open-source ganharam impulso, oferecendo aos compradores novos caminhos para evitar o vendor lock-in.

Principais Conclusões do Relatório

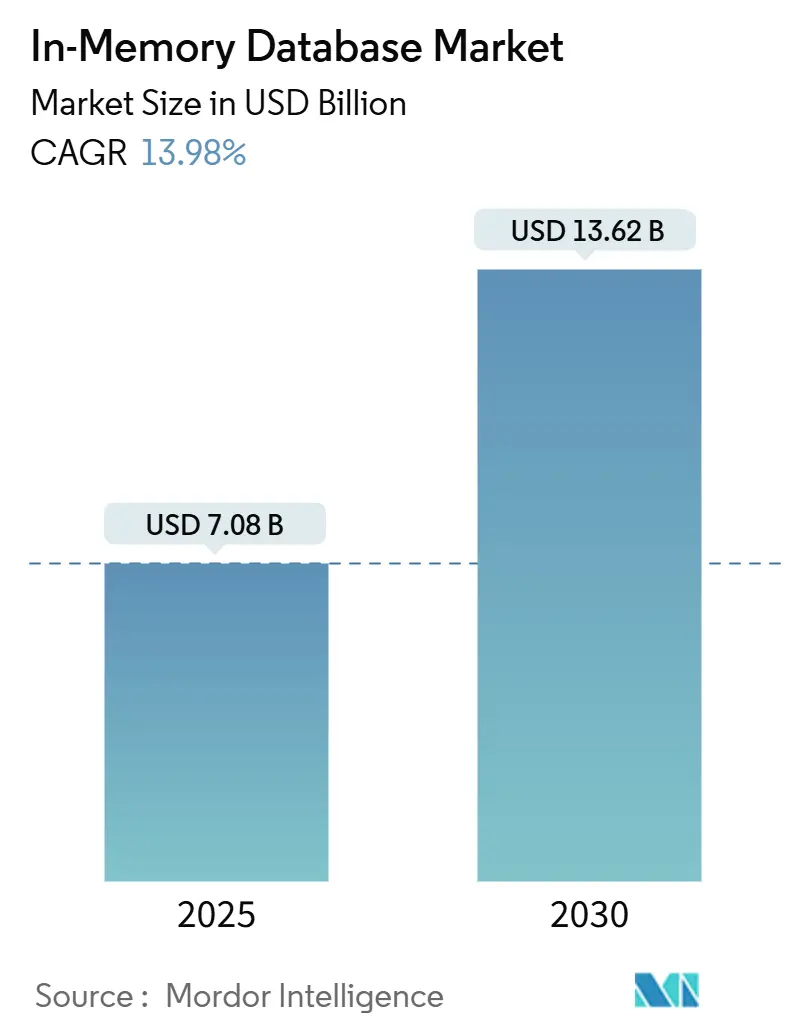

- Por tipo de processamento, o Processamento de Transações Online (OLTP) liderou com 45,3% da participação do mercado de Banco de Dados em Memória em 2024, enquanto o Processamento Transacional/Analítico Híbrido (HTAP) está projetado para crescer a uma TCAC de 21,1% até 2030.

- Por modo de implementação, instalações on-premise mantiveram 55,4% da participação de receita em 2024; implementações na borda e embarcadas estão previstas para expandir a uma TCAC de 23,2% até 2030.

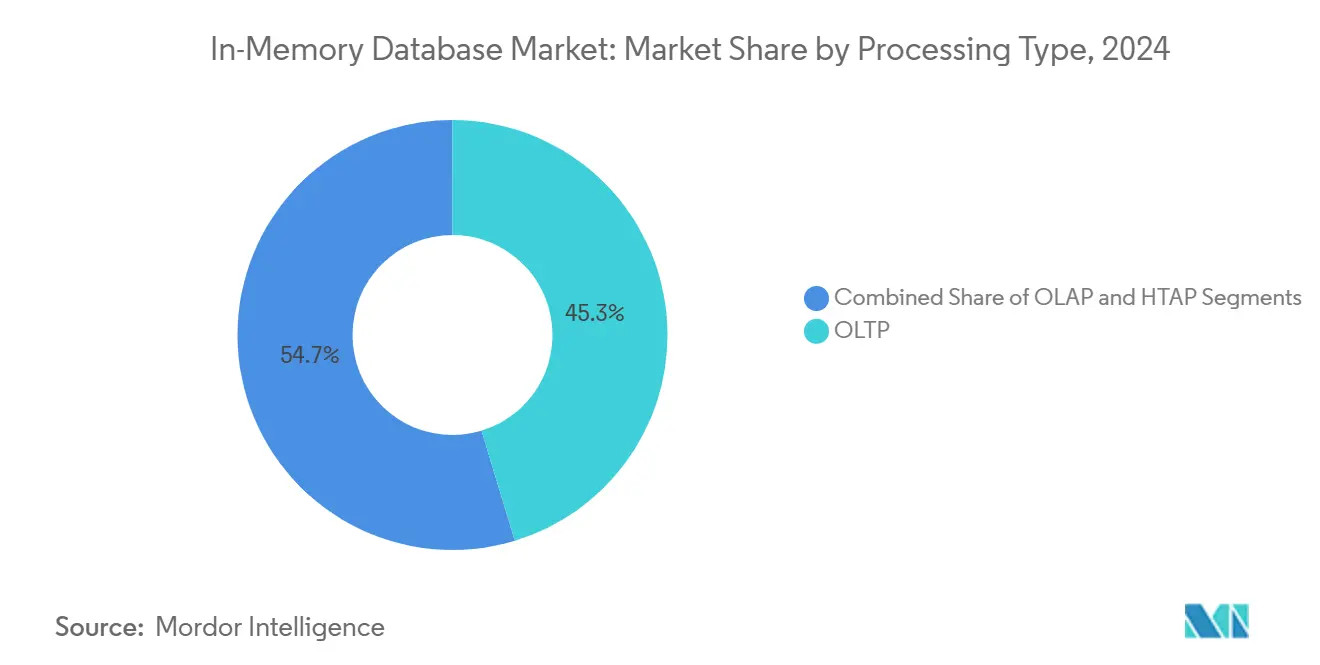

- Por modelo de dados, SQL relacional capturou 60,4% da participação em 2024, enquanto plataformas multi-modelo estão definidas para registrar uma TCAC de 20,1% entre 2025 e 2030.

- Por tamanho da organização, grandes empresas detiveram 70,5% da participação do tamanho do mercado de Banco de Dados em Memória em 2024; pequenas e médias empresas registrarão a TCAC mais rápida de 18,1% até 2030.

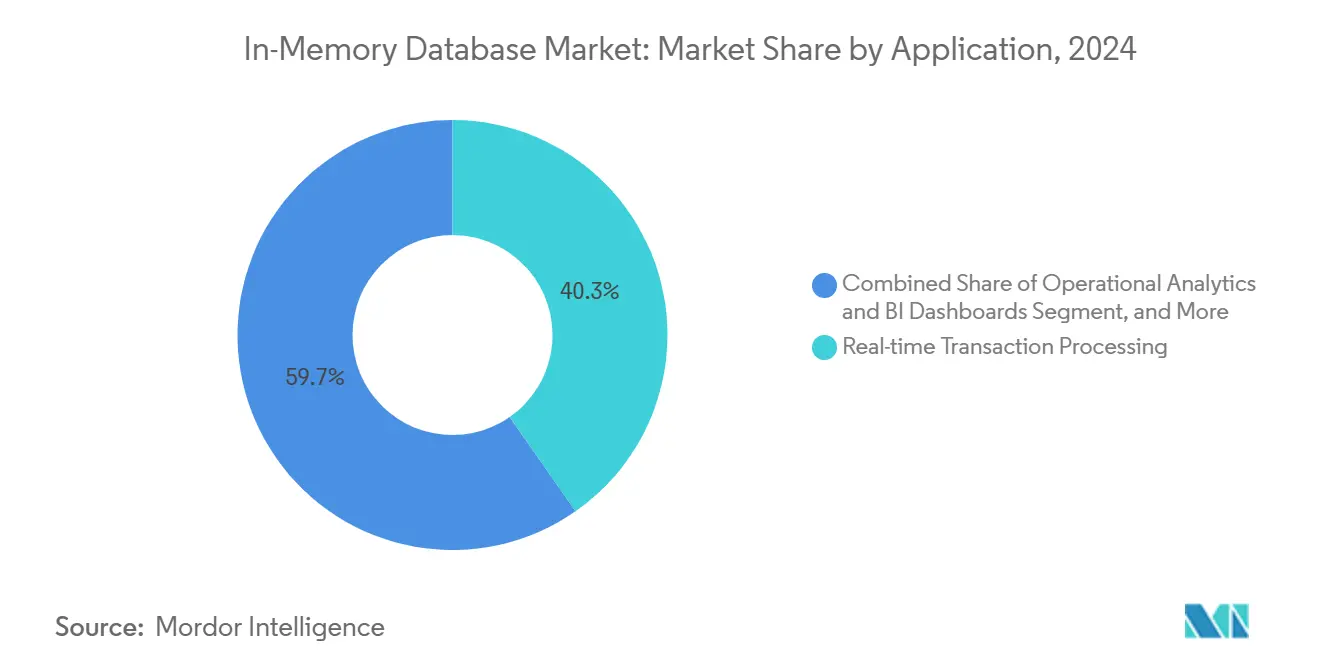

- Por aplicação, processamento de transações em tempo real representou 40,3% do tamanho do mercado de Banco de Dados em Memória em 2024, enquanto o serviço de modelos de IA/ML está previsto para expandir a uma TCAC de 24,2% até 2030.

- Por setor do usuário final, BFSI dominou com 28,2% da participação de receita em 2024; saúde e ciências da vida estão posicionadas para uma TCAC de 18,1% até 2030.

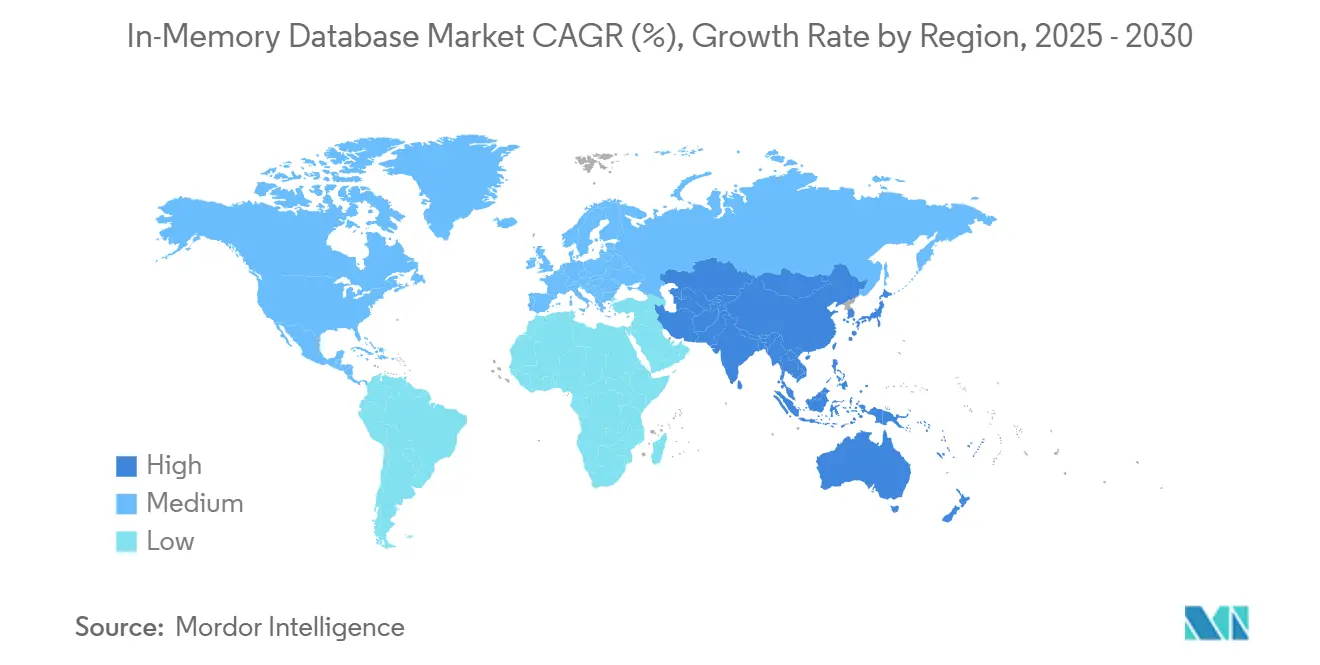

- Por geografia, Ásia-Pacífico comandou 32,2% da receita global em 2024 e permanece a região de crescimento mais rápido com TCAC de 17,1% até 2030.

Tendências e Insights do Mercado Global de Banco de Dados em Memória

Análise de Impacto dos Direcionadores

| Direcionador | (~) % Impacto na Previsão de TCAC | Relevância Geográfica | Cronograma de Impacto |

|---|---|---|---|

| Microsserviços nativos da nuvem exigindo latência sub-milissegundos | +3.2% | Global, com concentração na América do Norte e UE | Prazo curto (≤ 2 anos) |

| Queda do USD/GB de DRAM e memória persistente ampliando a diferença de TCO vs. disco | +2.8% | Global, adoção precoce em hubs de manufatura da APAC | Prazo médio (2-4 anos) |

| Adoção de análise de streaming em BFSI e telecom para fraude e QoS de rede | +2.1% | Centros financeiros da América do Norte e UE, infraestrutura de telecom da APAC | Prazo curto (≤ 2 anos) |

| Arquiteturas HTAP acelerando o serviço de modelos de IA/ML na saúde | +1.9% | Global, com adoção orientada por regulamentação na UE e América do Norte | Prazo médio (2-4 anos) |

| Casos de uso de edge-compute (veículos conectados, IIoT) requerendo IMDB embarcado | +2.4% | Manufatura da APAC, corredores automotivos da América do Norte | Prazo longo (≥ 4 anos) |

| Fonte: Mordor Intelligence | |||

Microsserviços Nativos da Nuvem Exigindo Latência Sub-Milissegundos

A adoção nativa da nuvem reformulou as linhas de base de performance à medida que microsserviços containerizados precisavam de acesso a dados em microssegundos. Armazenamentos de sessão, motores de personalização e plataformas de negociação de alta frequência mudaram de bancos de dados baseados em disco para armazenamentos centrados em memória porque cada milissegundo de atraso reduzia as taxas de conversão ou lucro de negociação. O Dragonfly demonstrou 6,43 milhões de operações por segundo no silício AWS Graviton3E, destacando o teto agora esperado das camadas de banco de dados.[1]DragonflyDB, "2024 New Year, New Number," dragonflydb.io Instituições financeiras e operadores de comércio digital que migraram monólitos para sistemas distribuídos viram melhorias no tempo de resposta se traduzir em ganhos tangíveis de receita, reforçando a importância de curto prazo do direcionador.

Queda dos Custos de DRAM e Memória Persistente Ampliando a Diferença de TCO

Os preços spot globais dos módulos DDR4 e DDR5 continuaram a deslizar, enquanto o protótipo Samsung CXL Memory Module Hybrid mostrou latência da classe DRAM com persistência, criando um perfil de custo atraente. Operadores de hiperescala agruparam memória entre racks, reduzindo capacidade ociosa e ciclos de backup. As empresas pivotaram roadmaps em direção à implementação em memória porque o prêmio sobre arrays SSD se estreitou, especialmente para cargas de trabalho de análise com janelas de SLA apertadas. O efeito é visível nos hubs de manufatura da Ásia-Pacífico onde grandes conjuntos de dados de historiadores são movidos para a memória para análise de gêmeo digital em tempo real.

Adoção de Análise de Streaming em BFSI e Telecom

Bancos implementaram sistemas de detecção de fraude em streaming que processaram milhões de autorizações de cartão por segundo usando o motor em memória da Aerospike. Operadores de telecom implementando 5G monitoraram logs de rede de acesso por rádio em tempo real para manter a qualidade do serviço, aproveitando pesquisas vetoriais no MongoDB para sinalizar anomalias. Regulamentações na América do Norte e Europa exigiram relatórios de atividade suspeita em tempo real, empurrando a curva de adoção do direcionador acentuadamente para cima.

Arquiteturas HTAP Acelerando o Serviço de Modelos de IA/ML

O Processamento Transacional/Analítico Híbrido removeu atrasos de ETL unificando escritas e análises no mesmo pool de memória. A Oracle incorporou modelos de linguagem grandes dentro do HeatWave GenAI para que registros de pacientes pudessem ser consultados e pontuados para decisões clínicas sem movimentação de dados. Provedores de saúde adotaram armazenamentos HTAP para servir previsões durante consultas, melhorando resultados e reduzindo sobrecarga de infraestrutura, o que sustentou o crescimento sustentado de médio prazo.

Análise de Impacto das Restrições

| Restrição | (~) % Impacto na Previsão de TCAC | Relevância Geográfica | Cronograma de Impacto |

|---|---|---|---|

| Preocupações de vendor lock-in em torno de formatos proprietários em memória | -1.8% | Global, particularmente afetando empresas multi-nuvem | Prazo curto (≤ 2 anos) |

| Complexidade de design de alta disponibilidade para clusters >40 TB | -1.2% | Implementações empresariais na América do Norte & UE | Prazo médio (2-4 anos) |

| Leis de soberania de dados (ex. CSL da China, GDPR da UE) limitando replicação global | -0.9% | UE, China, com repercussão em implementações multinacionais | Prazo longo (≥ 4 anos) |

| Fonte: Mordor Intelligence | |||

Preocupações de Vendor Lock-in em Torno de Formatos Proprietários

A mudança de licença do Redis em 2024 aumentou a cautela dos compradores em relação a formatos proprietários, estimulando AWS, Google e Oracle a apoiar o fork Valkey sob a Linux Foundation. Empresas orçando projetos de banco de dados multi-anuais fatoraram custos de saída, desacelerando ciclos de compra. Para mitigar riscos, algumas adotaram camadas de orquestração multi-banco de dados, mas essas abstrações introduziram penalidades de latência que parcialmente compensaram os ganhos de velocidade da memória.

Complexidade de Design de Alta Disponibilidade para Clusters Grandes

Clusters maiores que 40 TB encontraram sobrecarga de protocolo que degradou os tempos de sincronização de réplicas. A abordagem de gossip do Redis Cluster escalou quadraticamente, enquanto a orquestração alternativa do Dragonfly melhorou mas ainda exigiu scripts de monitoramento intrincados. Cargas de trabalho de serviços financeiros exigindo uptime de cinco noves hesitaram em migrar os maiores conjuntos de dados totalmente para a memória, optando por camadas híbridas que diluíram o pico de performance.

Análise de Segmentação

Por Tipo de Processamento: HTAP Emerge como Arquitetura Unificada

O segmento OLTP deteve 45,3% da participação do mercado de Banco de Dados em Memória em 2024, sublinhando a dependência contínua de cargas de trabalho transacionais de alta integridade em bancos, e-commerce e sistemas ERP. A demanda persistiu porque registros de missão crítica ainda exigiam conformidade ACID, com empresas pagando um prêmio de performance por commits sub-milissegundos. Implementações OLAP abordaram front-ends de business intelligence estabelecidos, mas cresceram lentamente à medida que a análise mudou em direção a motores mais flexíveis.

HTAP subiu com uma previsão de TCAC de 21,1% de 2025 a 2030 à medida que as empresas buscaram simplicidade de plataforma única. A plataforma da GridGain mostrou até 1.000× aceleração sobre sistemas baseados em disco mantendo suporte ANSI SQL-99.[2]GridGain Systems, "Hybrid Transactional/Analytical Processing (HTAP)," gridgain.com Cálculos de risco em tempo real e gêmeos de cadeia de suprimentos precisavam de acesso simultâneo de leitura-escrita, tornando HTAP a arquitetura preferida. A convergência desbloqueou orçamento incremental de departamentos anteriormente isolados entre operações e análises, empurrando o mercado de Banco de Dados em Memória em direção a designs unificados.

Nota: Participações de segmento de todos os segmentos individuais disponíveis mediante compra do relatório

Por Modo de Implementação: Edge Computing Impulsiona Crescimento Embarcado

Instalações on-premise capturaram 55,4% da receita de 2024 porque setores regulamentados exigiam controle total sobre residência de dados e arquiteturas HA personalizadas. Pilhas de software empresarial legado integraram-se estreitamente com bancos de dados on-premise, ancorando gastos mesmo quando nuvens públicas amadurecem. Implementações em nuvem, não obstante, avançaram à medida que empresas digitally-native adotaram serviços gerenciados para evitar administração de infraestrutura.

Implementações na borda e embarcadas exibiram uma perspectiva de TCAC de 23,2%, alimentada por carros conectados e gateways IIoT. Veículos modernos geram cerca de 300 TB anualmente, o que demanda processamento no veículo para recursos autônomos. TDengine alcançou compressão 10× sobre Elasticsearch em telemetria de veículos inteligentes, cortando largura de banda para transferências upstream. Fabricantes aplicaram estratégias similares em linhas de produção para detectar defeitos instantaneamente. A mudança sinalizou que ganhos de performance uma vez reservados para data centers agora são indispensáveis na borda, expandindo a pegada do mercado de Banco de Dados em Memória.

Por Modelo de Dados: Arquiteturas Multi-Modelo Ganham Tração

Motores SQL relacionais retiveram 60,4% da receita em 2024 porque décadas de código de aplicação e habilidades de desenvolvedor permaneceram atadas ao modelo. Corporações hesitaram em reescrever sistemas centrais, preservando a primazia relacional mesmo quando novos casos de uso emergiram. Categorias NoSQL-chave-valor, documento, grafo-abordaram esquemas flexíveis, mas serviram cargas de trabalho mais estreitas.

Plataformas multi-modelo preveem uma TCAC de 20,1% à medida que cargas de trabalho de IA demandam armazenamento unificado para registros estruturados, vetores e texto não estruturado. Hazelcast adicionou pesquisa vetorial junto com APIs tradicionais chave-valor. Consolidar tipos de dados variados em um único pool de memória reduziu complexidade operacional e latência, habilitando IA conversacional, grafos de fraude e pipelines de recomendação. Esse impulso deve expandir o mercado de Banco de Dados em Memória através de paisagens de dados heterogêneas.

Por Tamanho da Organização: PMEs Aceleram Adoção da Nuvem

Grandes empresas representaram 70,5% da receita em 2024 devido à intensidade de capital de implementações em escala de petabytes e demandas rigorosas de SLA. Bancos globais, operadoras de telecom e empresas aeroespaciais investiram em clusters redundantes com terabytes de DRAM para sustentar continuidade de negócios. Sua capacidade orçamentária os protegeu de altos custos por gigabyte.

Pequenas e médias empresas estão projetadas para subir a uma TCAC de 18,1% através de serviços gerenciados. AWS introduziu Aurora DSQL para combinar semântica SQL distribuída com performance no estilo em memória. Ao terceirizar escalabilidade e correções para fornecedores de nuvem, startups acessaram latência de nível empresarial para produtos micro-SaaS sem sobrecarga de pessoal. O suporte Valkey do ElastiCache reduziu despesas de licenciamento, acelerando a democratização do mercado de Banco de Dados em Memória entre empresas com restrições orçamentárias.

Por Aplicação: Serviço de Modelos de IA/ML Impulsiona Inovação

Processamento de transações em tempo real manteve a maior fatia com 40,3% em 2024, com negociação de ações, gateways de pagamento e sistemas de inventário dependentes de commits instantâneos. Análise operacional entregou dashboards para manufatura e observabilidade de TI, mas desacelerou à medida que novos casos de uso de IA capturaram gastos.

Serviço de modelos de IA/ML está previsto para expandir a 24,2% de TCAC à medida que empresas incorporam índices vetoriais e embeddings diretamente em bancos de dados para inferência. Microsoft propôs Managed Retention Memory para reduzir latência na execução de modelos de linguagem grandes. O padrão integra inferência dentro da camada transacional, eliminando saltos WAN entre servidores de modelo e dados de origem. Cargas de trabalho híbridas que combinam atualizações ACID com pesquisas de similaridade vetorial estão definidas para dominar a receita incremental do mercado de Banco de Dados em Memória.

Por Setor do Usuário Final: Saúde Lidera Transformação Digital

BFSI comandou 28,2% da receita em 2024, refletindo adoção precoce para negociação de alta frequência e prevenção de fraude. Mandatos regulamentários para relatórios em tempo real e requisitos rigorosos de RTO asseguraram investimento contínuo. Telecomunicações aplica análises em memória para orquestração de rede e insights de experiência do cliente, sustentando uma participação estável.

Saúde e ciências da vida mostram uma perspectiva de TCAC de 18,1%. Corti lançou infraestrutura de IA especializada exigindo acesso imediato a dados de pacientes para suporte diagnóstico. Fornecedores de registros eletrônicos de saúde integraram bancos de dados HTAP para alimentar algoritmos de decisão clínica, melhorando qualidade do cuidado e eficiência operacional. Manufatura investiu em manutenção preditiva, e varejo aproveitou motores de personalização, mantendo a indústria geral de Banco de Dados em Memória diversificada.

Análise Geográfica

Ásia-Pacífico registrou a maior receita regional com 32,2% em 2024 e manteve uma perspectiva de TCAC de 17,1%. Programas nacionais de Indústria 4.0 na China, Japão e Índia estimularam automação fabril que exigiu bancos de dados historiadores em memória para loops de feedback MES em sub-segundos. General Motors conectou mais de 100.000 conexões de tecnologia operacional em seu rollout MES 4.0, ilustrando a escala de implementações na borda. Fornecedores locais como Nautilus Technologies avançaram motores relacionais indígenas, reduzindo dependência de IP estrangeiro.[3]Nautilus Technologies, "Tsurugi MCP対応版をOSSにてリリース," prtimes.jp

América do Norte formou um mercado maduro mas rico em inovação centrado em serviços financeiros, nuvens de hiperescala e P&D de veículos autônomos. Oracle e Google aprofundaram sua parceria para executar serviços Oracle Database nativamente no Google Cloud, casando capacidades SQL empresariais com aceleradores de IA. O financiamento de capital de risco da região apoiou players emergentes como Dragonfly, intensificando a agitação competitiva.

Europa priorizou conformidade de soberania de dados sob GDPR, impulsionando adoção de nuvem híbrida e favorecendo clusters on-premise combinados com serviços gerenciados em data centers locais. Oracle expandiu a cobertura Database@Azure para regiões adicionais da UE para satisfazer regras de residência. O continente também viu implementações de saúde de bancos de dados HTAP para alimentar diagnósticos de IA sob estruturas rígidas de privacidade.

Oriente Médio e África investiram em backbones de fibra e 5G de cidades inteligentes, levando a implementações piloto de IIoT que exigem análises em tempo real. América do Sul ganhou tração em operações de mineração e bancos digitais, onde detecção de fraude de baixa latência justificou sistemas premium centrados em memória. Embora o gasto absoluto nessas duas regiões tenha permanecido modesto, crescimento de dois dígitos expandiu a diversidade global do mercado de Banco de Dados em Memória.

Cenário Competitivo

O mercado de Banco de Dados em Memória permaneceu moderadamente fragmentado, com SAP, Oracle, Microsoft e IBM aproveitando suítes empresariais amplas para reter incumbência. Seus roadmaps integram armazenamentos vetoriais in-database e aceleradores ML, alinhando-se com demandas dos clientes por plataformas unificadas. A mudança de licença do Redis levou hiperescalers a endossar Valkey, ilustrando como modelos de governança podem remodelar linhas competitivas.

Fornecedores especialistas como Aerospike e Hazelcast competiram em latência previsível e de baixa latência em escala e menor custo total por gigabyte. O sucesso da Aerospike no PayPal provou a capacidade de processar sinais de fraude em tempo real em hardware commodity. Hazelcast lançou Platform 5.5 com conectores estendidos que simplificaram integrações de pipeline de IA.[4]Hazelcast, "Announcing Hazelcast Platform 5.5 Release," hazelcast.com Dragonfly se posicionou como um substituto drop-in para Redis com eficiência superior de núcleo único, desafiando incumbentes na comunidade de desenvolvedores.

Alianças estratégicas aceleraram. O acordo da Oracle de abril de 2025 com Google Cloud habilitou empresas a consolidar bancos de dados e toolchains de IA sem penalidades de egress cross-cloud. AWS formou um grupo de IA agêntica para vincular desenvolvimento de modelo mais estreitamente a serviços de dados em memória. Barreiras de entrada ao mercado subiram em torno da profundidade do ecossistema e recursos integrados de IA, consolidando participação entre fornecedores que podem oferecer tanto excelência transacional quanto pesquisa vetorial nativamente.

Líderes da Indústria de Banco de Dados em Memória

-

IBM Corporation

-

Microsoft Corporation

-

Oracle Corporation

-

SAP SE

-

TIBCO Software Inc.

- *Isenção de responsabilidade: Principais participantes classificados em nenhuma ordem específica

Desenvolvimentos Recentes da Indústria

- Maio de 2025: AWS anunciou a disponibilidade geral do Amazon Aurora DSQL para entregar escalabilidade SQL distribuída com performance no estilo em memória.

- Maio de 2025: Amazon ElastiCache e MemoryDB adicionaram suporte para Valkey 7.2, oferecendo compatibilidade open-source e preços competitivos.

- Abril de 2025: Oracle e Google Cloud revelaram um programa de parceria que executa serviços Oracle Database nativamente no Google Cloud.

- Março de 2025: AWS criou um novo grupo de IA agêntica sob Swami Sivasubramanian para integrar IA com infraestrutura de banco de dados.

Escopo do Relatório Global do Mercado de Banco de Dados em Memória

Bancos de dados em memória são sistemas construídos especificamente que armazenam dados principalmente na memória, em oposição a bancos de dados que armazenam informações em discos ou SSDs. O armazenamento de dados em memória tem a intenção de fornecer tempos de resposta rápidos removendo a necessidade de acesso ao disco.

O mercado de banco de dados em memória é segmentado por tamanho da indústria (pequeno, médio e grande), usuário final (BFSI, varejo, logística e transporte, entretenimento e mídia, saúde, TI e telecomunicação, e outros), e geografia (América do Norte (EUA, Canadá), Europa (Alemanha, Reino Unido, França, e Resto da Europa), Ásia Pacífico (Índia, China, Japão, e Resto da Ásia-Pacífico), e Resto do Mundo).

Os tamanhos de mercado e previsões são fornecidos em termos de valor (milhões USD) para todos os segmentos acima.

| OLTP |

| OLAP |

| Processamento Transacional/Analítico Híbrido (HTAP) |

| On-premise |

| Nuvem |

| Borda/Embarcado |

| Relacional (SQL) |

| NoSQL (Chave-Valor, Documento, Grafo) |

| Multi-modelo |

| Pequenas e Médias Empresas (PMEs) |

| Grandes Empresas |

| Processamento de Transações em Tempo Real |

| Análise Operacional e Dashboards de BI |

| Serviço de Modelos de IA/ML |

| Cache e Armazenamentos de Sessão |

| BFSI |

| Telecomunicações e TI |

| Varejo e E-commerce |

| Saúde e Ciências da Vida |

| Manufatura e IoT Industrial |

| Mídia e Entretenimento |

| Governo e Defesa |

| Outros (Energia, Educação, etc.) |

| América do Norte | Estados Unidos | |

| Canadá | ||

| México | ||

| Europa | Alemanha | |

| França | ||

| Reino Unido | ||

| Países Nórdicos | ||

| Resto da Europa | ||

| Ásia-Pacífico | China | |

| Taiwan | ||

| Coreia do Sul | ||

| Japão | ||

| Índia | ||

| Resto da Ásia-Pacífico | ||

| América do Sul | Brasil | |

| México | ||

| Argentina | ||

| Resto da América do Sul | ||

| Oriente Médio e África | Oriente Médio | Arábia Saudita |

| Emirados Árabes Unidos | ||

| Turquia | ||

| Resto do Oriente Médio | ||

| África | África do Sul | |

| Resto da África | ||

| Por Tipo de Processamento | OLTP | ||

| OLAP | |||

| Processamento Transacional/Analítico Híbrido (HTAP) | |||

| Por Modo de Implementação | On-premise | ||

| Nuvem | |||

| Borda/Embarcado | |||

| Por Modelo de Dados | Relacional (SQL) | ||

| NoSQL (Chave-Valor, Documento, Grafo) | |||

| Multi-modelo | |||

| Por Tamanho da Organização | Pequenas e Médias Empresas (PMEs) | ||

| Grandes Empresas | |||

| Por Aplicação | Processamento de Transações em Tempo Real | ||

| Análise Operacional e Dashboards de BI | |||

| Serviço de Modelos de IA/ML | |||

| Cache e Armazenamentos de Sessão | |||

| Por Setor do Usuário Final | BFSI | ||

| Telecomunicações e TI | |||

| Varejo e E-commerce | |||

| Saúde e Ciências da Vida | |||

| Manufatura e IoT Industrial | |||

| Mídia e Entretenimento | |||

| Governo e Defesa | |||

| Outros (Energia, Educação, etc.) | |||

| Por Geografia | América do Norte | Estados Unidos | |

| Canadá | |||

| México | |||

| Europa | Alemanha | ||

| França | |||

| Reino Unido | |||

| Países Nórdicos | |||

| Resto da Europa | |||

| Ásia-Pacífico | China | ||

| Taiwan | |||

| Coreia do Sul | |||

| Japão | |||

| Índia | |||

| Resto da Ásia-Pacífico | |||

| América do Sul | Brasil | ||

| México | |||

| Argentina | |||

| Resto da América do Sul | |||

| Oriente Médio e África | Oriente Médio | Arábia Saudita | |

| Emirados Árabes Unidos | |||

| Turquia | |||

| Resto do Oriente Médio | |||

| África | África do Sul | ||

| Resto da África | |||

Principais Questões Respondidas no Relatório

Qual é o valor atual do mercado de Banco de Dados em Memória?

O mercado de Banco de Dados em Memória foi avaliado em USD 7,08 bilhões em 2025 e está projetado para atingir USD 13,62 bilhões até 2030.

Qual região lidera o crescimento do mercado de Banco de Dados em Memória?

Ásia-Pacífico liderou com 32,2% da receita em 2024 e deve registrar uma TCAC de 17,1% até 2030.

Por que as arquiteturas HTAP são importantes para cargas de trabalho de IA?

HTAP unifica processamento transacional e analítico, habilitando inferência em tempo real sem atrasos de ETL, como mostrado pelo Oracle HeatWave GenAI.

Como a queda dos preços de DRAM está afetando a adoção?

Preços mais baixos de USD/GB e novas opções de memória persistente reduzem o custo total de propriedade, tornando implementações em memória economicamente viáveis.

Quais desafios limitam clusters muito grandes em memória?

A arquitetura de alta disponibilidade torna-se complexa além de 40 TB, com protocolos de clustering incorrendo em sobrecarga de performance.

Página atualizada pela última vez em: