Taille et part du marché des bases de données en mémoire

Analyse du marché des bases de données en mémoire par Mordor Intelligence

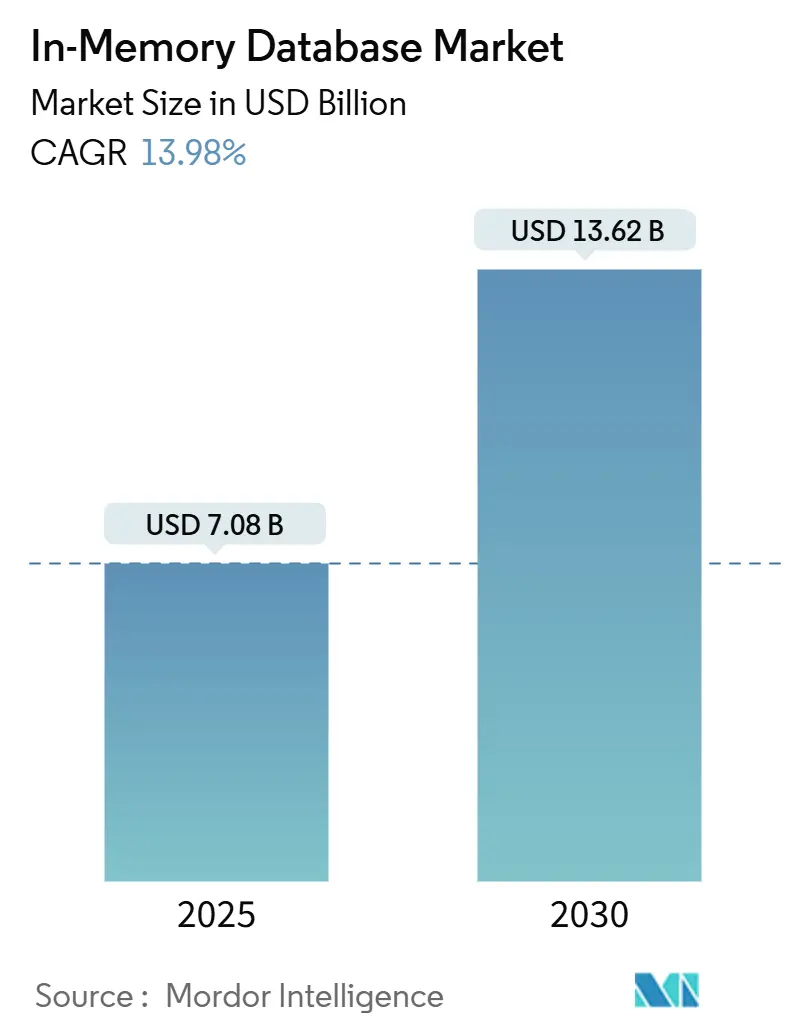

La taille du marché mondial des bases de données en mémoire s'élevait à 7,08 milliards USD en 2025 et devrait atteindre 13,62 milliards USD d'ici 2030, progressant à un TCAC de 13,98 % sur la période de prévision. Les exigences de performance sub-millisecondes des microservices cloud-natifs, des moteurs d'inférence IA et des plateformes d'analyse de streaming ont continué de pousser les entreprises vers des architectures centrées sur la mémoire. La baisse des prix de la DRAM et l'arrivée des modules de mémoire persistante basés sur CXL ont réduit le coût total de possession, encourageant plus de charges de travail à migrer depuis les systèmes basés sur disque. Les déploiements en périphérie dans les véhicules connectés et les installations IoT industrielles ont encore élargi la demande car le traitement local évite les pénalités de latence réseau. La dynamique concurrentielle est restée fluide alors que les fournisseurs traditionnels ont approfondi les intégrations avec les clouds hyperscale tandis que les forks open-source ont gagné en momentum, donnant aux acheteurs de nouvelles voies pour éviter le verrouillage fournisseur.

Points clés du rapport

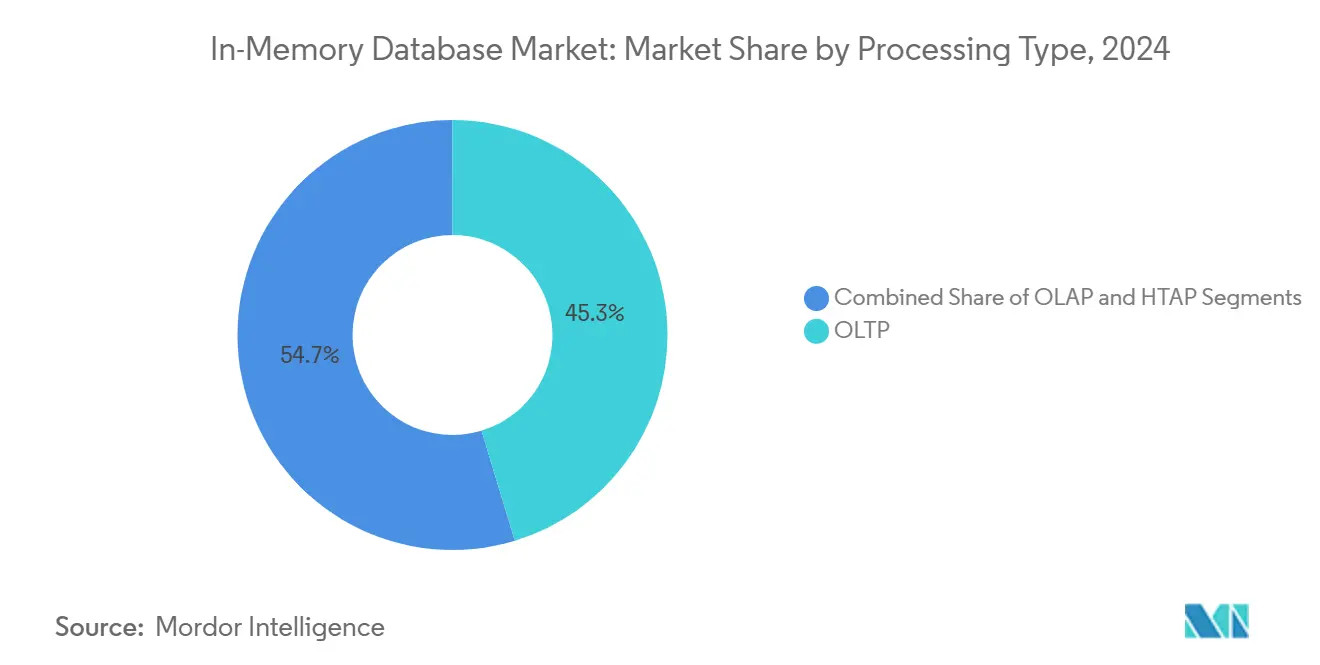

- Par type de traitement, le traitement transactionnel en ligne (OLTP) a dominé avec 45,3 % de la part du marché des bases de données en mémoire en 2024, tandis que le traitement transactionnel/analytique hybride (HTAP) devrait croître à un TCAC de 21,1 % jusqu'en 2030.

- Par mode de déploiement, les installations sur site ont conservé 55,4 % de part de revenus en 2024 ; les déploiements en périphérie et intégrés devraient s'étendre à un TCAC de 23,2 % jusqu'en 2030.

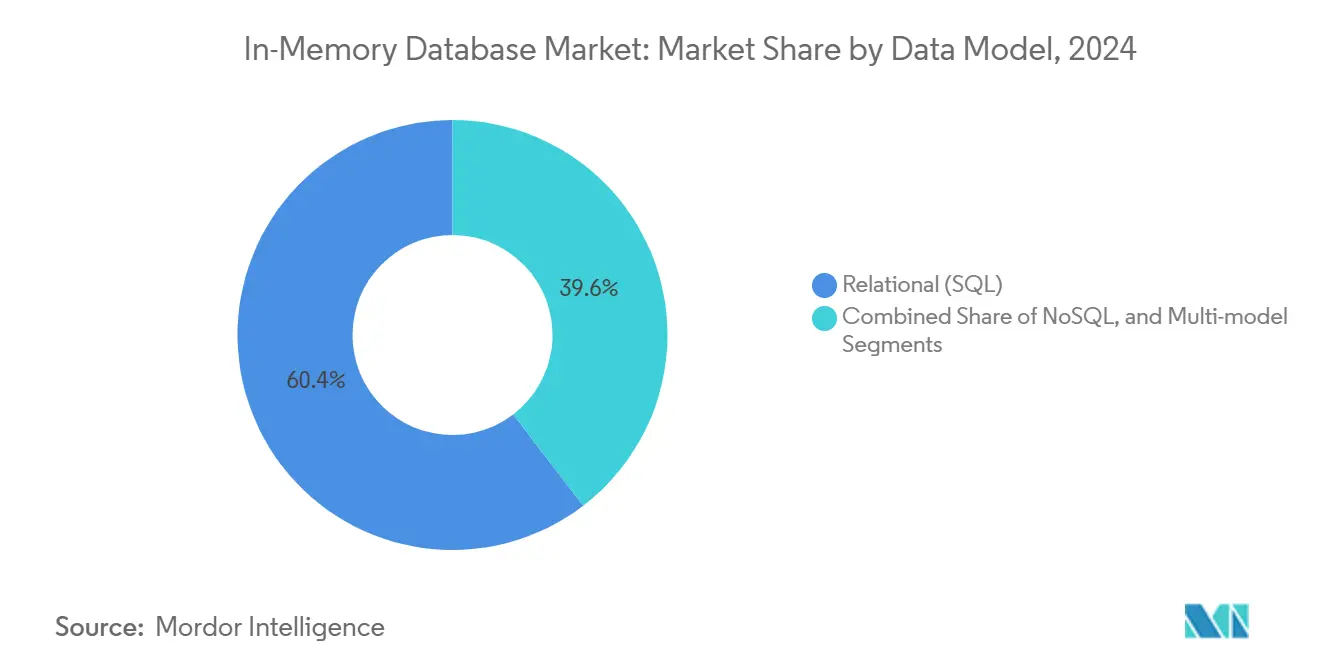

- Par modèle de données, le SQL relationnel a capturé une part de 60,4 % en 2024, tandis que les plateformes multi-modèles devraient afficher un TCAC de 20,1 % entre 2025 et 2030.

- Par taille d'organisation, les grandes entreprises détenaient 70,5 % de part de la taille du marché des bases de données en mémoire en 2024 ; les petites et moyennes entreprises enregistreront le TCAC le plus rapide de 18,1 % jusqu'en 2030.

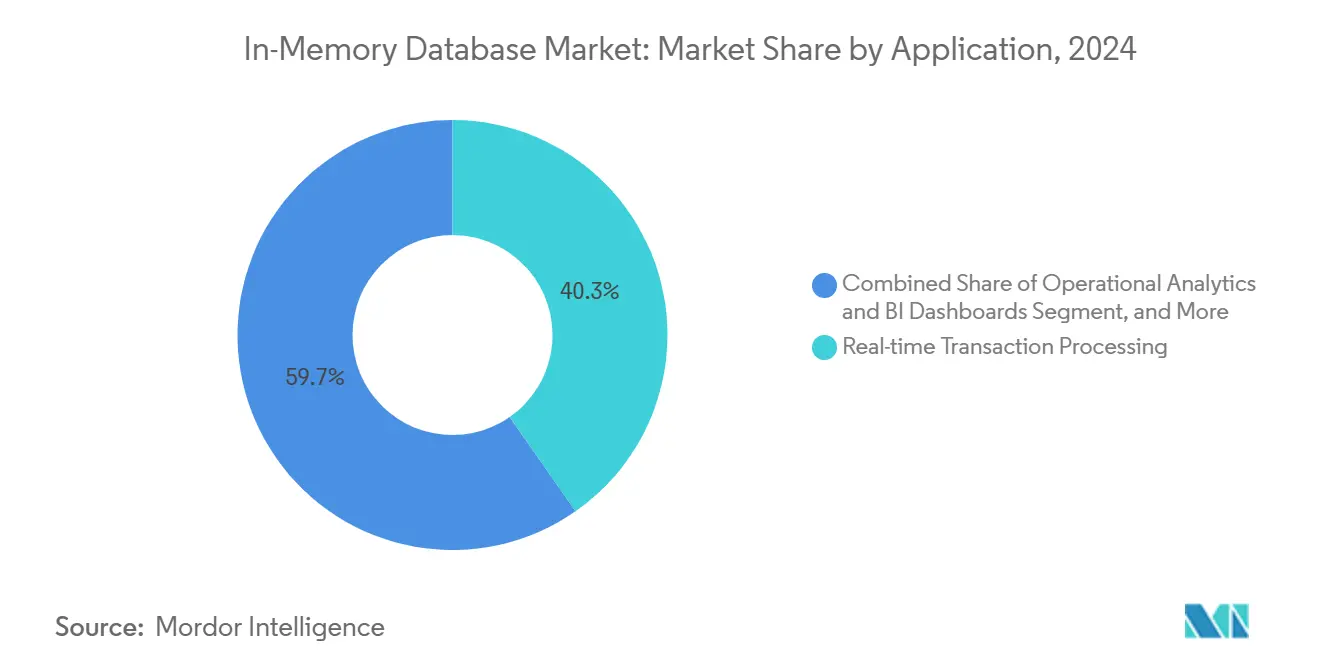

- Par application, le traitement de transactions en temps réel représentait 40,3 % de la taille du marché des bases de données en mémoire en 2024, tandis que le service de modèles IA/ML devrait s'étendre à un TCAC de 24,2 % jusqu'en 2030.

- Par secteur d'utilisateur final, le BFSI a dominé avec 28,2 % de part de revenus en 2024 ; la santé et les sciences de la vie sont positionnées pour un TCAC de 18,1 % jusqu'en 2030.

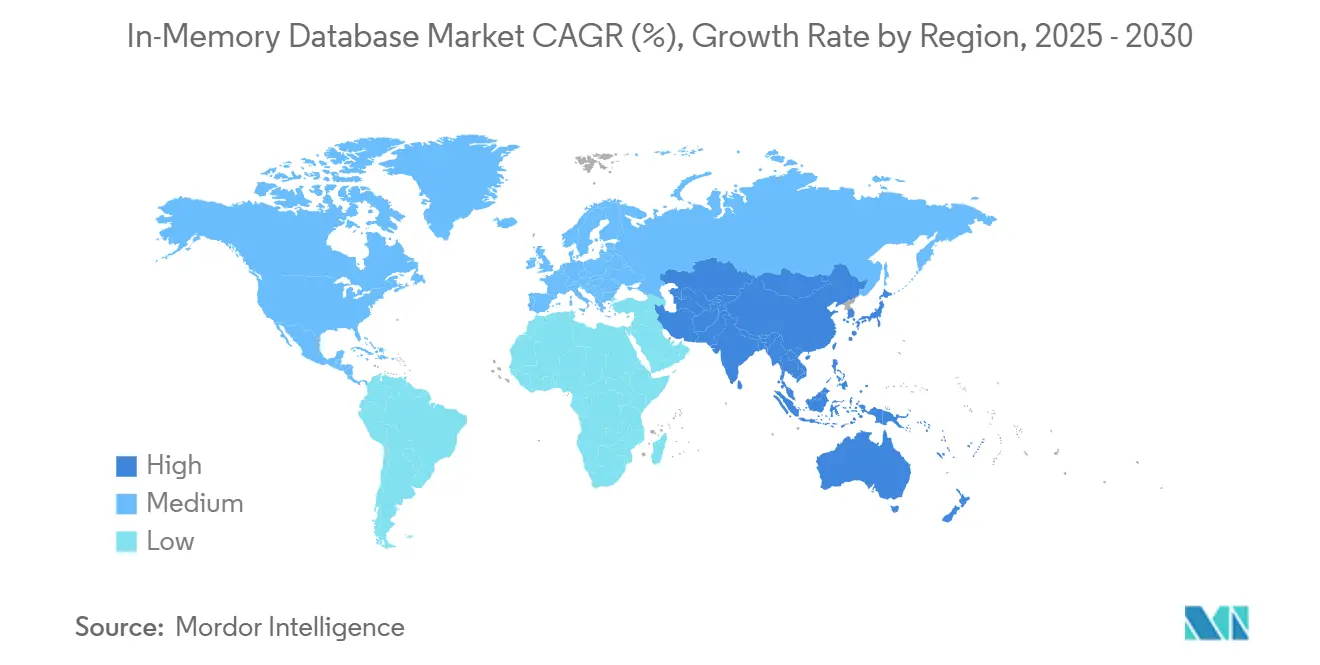

- Par géographie, l'Asie-Pacifique a commandé 32,2 % des revenus mondiaux en 2024 et reste la région à croissance la plus rapide avec un TCAC de 17,1 % jusqu'en 2030.

Tendances et perspectives du marché mondial des bases de données en mémoire

Analyse d'impact des moteurs

| Moteur | (~) % Impact sur les prévisions TCAC | Pertinence géographique | Chronologie d'impact |

|---|---|---|---|

| Microservices cloud-natifs exigeant une latence sub-millisecondes | +3.2% | Mondial, avec une concentration en Amérique du Nord et UE | Court terme (≤ 2 ans) |

| Baisse des coûts DRAM et mémoire persistante USD/GB élargissant l'écart TCO vs. disque | +2.8% | Mondial, adoption précoce dans les hubs manufacturiers APAC | Moyen terme (2-4 ans) |

| Adoption d'analyses de streaming dans BFSI et télécom pour fraude et QoS réseau | +2.1% | Centres financiers Amérique du Nord et UE, infrastructure télécom APAC | Court terme (≤ 2 ans) |

| Architectures HTAP accélérant le service de modèles IA/ML en santé | +1.9% | Mondial, avec adoption réglementaire en UE et Amérique du Nord | Moyen terme (2-4 ans) |

| Cas d'usage edge-compute (véhicules connectés, IIoT) nécessitant des bases de données en mémoire intégrées | +2.4% | Manufacturier APAC, corridors automobiles Amérique du Nord | Long terme (≥ 4 ans) |

| Source: Mordor Intelligence | |||

Microservices cloud-natifs exigeant une latence sub-millisecondes

L'adoption cloud-native a reconfiguré les références de performance alors que les microservices conteneurisés nécessitaient un accès aux données en microsecondes. Les magasins de sessions, moteurs de personnalisation et plateformes de trading haute fréquence ont migré des bases de données basées sur disque vers des magasins centrés sur la mémoire car chaque milliseconde de délai réduisait les taux de conversion ou les profits de trading. Dragonfly a démontré 6,43 millions d'opérations par seconde sur du silicium AWS Graviton3E, soulignant le plafond désormais attendu des niveaux de base de données.[1]DragonflyDB, "2024 New Year, New Number," dragonflydb.io Les institutions financières et opérateurs de commerce numérique qui ont migré les monolithes vers des systèmes distribués ont vu les améliorations de temps de réponse se traduire en gains de revenus tangibles, renforçant l'importance à court terme du moteur.

Baisse des coûts DRAM et mémoire persistante élargissant l'écart TCO

Les prix spot mondiaux des modules DDR4 et DDR5 ont continué de chuter, tandis que le prototype de module de mémoire hybride CXL de Samsung a montré une latence de classe DRAM avec persistance, créant un profil coût convaincant. Les opérateurs hyperscale ont mutualisé la mémoire à travers les racks, réduisant la capacité bloquée et les cycles de sauvegarde. Les entreprises ont pivoté leurs feuilles de route vers le déploiement en mémoire car la prime par rapport aux baies SSD s'est rétrécie, notamment pour les charges de travail analytiques avec des fenêtres SLA serrées. L'effet est visible dans les hubs manufacturiers Asie-Pacifique où de larges jeux de données d'historien sont déplacés en mémoire pour des analyses de jumeau numérique en temps réel.

Adoption d'analyses de streaming dans BFSI et télécom

Les banques ont déployé des systèmes de détection de fraude en streaming qui traitaient des millions d'autorisations de cartes par seconde en utilisant le moteur en mémoire d'Aerospike. Les opérateurs télécoms déployant la 5G ont surveillé les journaux de réseau d'accès radio en temps réel pour maintenir la qualité de service, exploitant les recherches vectorielles sur MongoDB pour signaler les anomalies. La réglementation en Amérique du Nord et Europe a exigé des rapports d'activités suspectes en temps réel, poussant la courbe d'adoption du moteur fortement vers le haut.

Architectures HTAP accélérant le service de modèles IA/ML

Le traitement transactionnel/analytique hybride a supprimé les délais ETL en unifiant les écritures et analyses dans le même pool mémoire. Oracle a intégré de grands modèles de langage dans HeatWave GenAI pour que les dossiers patients puissent être interrogés et notés pour les décisions cliniques sans mouvement de données. Les prestataires de santé ont adopté des magasins HTAP pour servir des prédictions pendant les consultations, améliorant les résultats et réduisant la surcharge d'infrastructure, ce qui a soutenu une croissance soutenue à moyen terme.

Analyse d'impact des contraintes

| Contrainte | (~) % Impact sur les prévisions TCAC | Pertinence géographique | Chronologie d'impact |

|---|---|---|---|

| Préoccupations de verrouillage fournisseur autour des formats propriétaires en mémoire | -1.8% | Mondial, affectant particulièrement les entreprises multi-cloud | Court terme (≤ 2 ans) |

| Complexité de conception haute disponibilité pour clusters >40 To | -1.2% | Déploiements d'entreprise en Amérique du Nord & UE | Moyen terme (2-4 ans) |

| Lois de souveraineté des données (ex. CSL Chine, RGPD UE) limitant la réplication globale | -0.9% | UE, Chine, avec retombées sur les déploiements multinationaux | Long terme (≥ 4 ans) |

| Source: Mordor Intelligence | |||

Préoccupations de verrouillage fournisseur autour des formats propriétaires

Le changement de licence de Redis en 2024 a accru la méfiance des acheteurs envers les formats propriétaires, poussant AWS, Google et Oracle à soutenir le fork Valkey sous la Linux Foundation. Les entreprises budgétisant des projets de base de données pluriannuels ont factorisé les coûts de sortie, ralentissant les cycles d'achat. Pour atténuer le risque, certaines ont adopté des couches d'orchestration multi-base de données, mais ces abstractions ont introduit des pénalités de latence qui ont partiellement compensé les gains de vitesse mémoire.

Complexité de conception haute disponibilité pour grands clusters

Les clusters dépassant 40 To ont rencontré une surcharge protocolaire qui a dégradé les temps de synchronisation des répliques. L'approche gossip de Redis Cluster s'est mise à l'échelle quadratiquement, tandis que l'orchestration alternative de Dragonfly s'est améliorée mais nécessitait encore des scripts de surveillance complexes. Les charges de travail de services financiers exigeant une disponibilité de cinq neuf ont hésité à migrer entièrement les plus grands jeux de données en mémoire, optant pour des niveaux hybrides qui ont dilué les performances de pointe.

Analyse de segment

Par type de traitement : HTAP émerge comme architecture unifiée

Le segment OLTP détenait 45,3 % de la part du marché des bases de données en mémoire en 2024, soulignant la dépendance continue aux charges de travail transactionnelles à haute intégrité à travers les systèmes bancaires, e-commerce et ERP. La demande a persisté car les enregistrements critiques nécessitaient encore la conformité ACID, les entreprises payant une prime de performance pour des validations sub-millisecondes. Les déploiements OLAP ont adressé les interfaces établies de business intelligence mais ont crû lentement alors que l'analytique migrait vers des moteurs plus flexibles.

HTAP a grimpé avec un TCAC prévu de 21,1 % de 2025 à 2030 alors que les entreprises cherchaient la simplicité de plateforme unique. La plateforme GridGain a montré jusqu'à 1 000× d'accélérations par rapport aux systèmes basés sur disque tout en conservant le support ANSI SQL-99.[2]GridGain Systems, "Hybrid Transactional/Analytical Processing (HTAP)," gridgain.com Les calculs de risque en temps réel et jumeaux de chaîne d'approvisionnement nécessitaient un accès simultané lecture-écriture, faisant d'HTAP l'architecture préférée. La convergence a débloqué un budget supplémentaire des départements auparavant cloisonnés entre opérations et analytique, poussant le marché des bases de données en mémoire vers des conceptions unifiées.

Note: Parts de segments de tous les segments individuels disponibles à l'achat du rapport

Par mode de déploiement : l'edge computing stimule la croissance intégrée

Les installations sur site ont capturé 55,4 % des revenus 2024 car les secteurs réglementés nécessitaient un contrôle complet sur la résidence des données et des architectures HA personnalisées. Les piles logicielles d'entreprise héritées étroitement intégrées avec les bases de données sur site ont ancré les dépenses même si les clouds publics maturent. Les déploiements cloud ont néanmoins progressé alors que les entreprises digital-native adoptaient les services gérés pour éviter l'administration d'infrastructure.

Les déploiements edge et intégrés ont affiché une perspective TCAC de 23,2 %, alimentée par les voitures connectées et passerelles IIoT. Les véhicules modernes génèrent environ 300 To annuellement, ce qui demande un traitement dans le véhicule pour les fonctionnalités autonomes. TDengine a atteint 10× de compression par rapport à Elasticsearch dans la télémétrie de véhicules intelligents, réduisant la bande passante pour les transferts en amont. Les manufacturiers ont appliqué des stratégies similaires sur les lignes de production pour détecter instantanément les défauts. Le changement a signalé que les gains de performance autrefois réservés aux centres de données étaient désormais indispensables en périphérie, étendant l'empreinte du marché des bases de données en mémoire.

Par modèle de données : les architectures multi-modèles gagnent en traction

Les moteurs SQL relationnels ont conservé 60,4 % des revenus en 2024 car des décennies de code d'application et de compétences de développeur restaient liées au modèle. Les corporations ont hésité à réécrire les systèmes centraux, préservant la primauté relationnelle même si de nouveaux cas d'usage émergeaient. Les catégories NoSQL-clé-valeur, document, graphe-ont adressé des schémas flexibles mais servi des charges de travail plus étroites.

Les plateformes multi-modèles prévoient un TCAC de 20,1 % alors que les charges de travail IA demandent un stockage unifié pour les enregistrements structurés, vecteurs et texte non structuré. Hazelcast a ajouté la recherche vectorielle aux côtés des API clé-valeur traditionnelles. Consolider des types de données variés dans un seul pool mémoire a réduit la complexité opérationnelle et la latence, permettant l'IA conversationnelle, graphes de fraude et pipelines de recommandation. Ce momentum devrait étendre le marché des bases de données en mémoire à travers des paysages de données hétérogènes.

Par taille d'organisation : les PME accélèrent l'adoption cloud

Les grandes entreprises ont représenté 70,5 % des revenus en 2024 en raison de l'intensité capitalistique des déploiements à l'échelle pétaoctet et des exigences SLA strictes. Les banques mondiales, opérateurs télécoms et entreprises aérospatiales ont investi dans des clusters redondants avec des téraoctets de DRAM pour maintenir la continuité business. Leur capacité budgétaire les a protégées des coûts élevés par gigaoctet.

Les petites et moyennes entreprises devraient croître à un TCAC de 18,1 % via les services gérés. AWS a introduit Aurora DSQL pour combiner la sémantique SQL distribuée avec des performances de style en mémoire. En déchargeant la mise à l'échelle et les correctifs aux fournisseurs cloud, les startups ont accédé à la latence de niveau entreprise pour des produits micro-SaaS sans surcharge d'effectifs. Le support Valkey d'ElastiCache a réduit les dépenses de licence, accélérant la démocratisation du marché des bases de données en mémoire parmi les entreprises contraintes par le budget.

Par application : le service de modèles IA/ML stimule l'innovation

Le traitement de transactions en temps réel a conservé la plus grande part à 40,3 % en 2024, avec le trading d'actions, passerelles de paiement et systèmes d'inventaire dépendants de validations instantanées. L'analytique opérationnelle a livré des tableaux de bord pour la fabrication et l'observabilité IT, mais a décéléré alors que de nouveaux cas d'usage IA capturaient les dépenses.

Le service de modèles IA/ML devrait s'étendre à un TCAC de 24,2 % alors que les entreprises intègrent des index vectoriels et embeddings directement dans les bases de données pour l'inférence. Microsoft a proposé la mémoire de rétention gérée pour réduire la latence dans l'exécution de grands modèles de langage. Le modèle intègre l'inférence dans la couche transactionnelle, éliminant les sauts WAN entre serveurs de modèles et données sources. Les charges de travail hybrides qui combinent mises à jour ACID et recherches de similarité vectorielle devraient dominer les revenus supplémentaires du marché des bases de données en mémoire.

Par secteur d'utilisateur final : la santé mène la transformation numérique

Le BFSI a commandé 28,2 % des revenus en 2024, reflétant une adoption précoce pour le trading haute fréquence et la prévention de fraude. Les mandats réglementaires pour les rapports en temps réel et les exigences RTO strictes ont sécurisé les investissements continus. Les télécommunications appliquent l'analytique en mémoire pour l'orchestration réseau et les insights d'expérience client, maintenant une part stable.

La santé et sciences de la vie montrent une perspective TCAC de 18,1 %. Corti a publié une infrastructure IA spécialisée nécessitant un accès immédiat aux données patients pour le support diagnostique. Les fournisseurs de dossiers médicaux électroniques ont intégré des bases de données HTAP pour alimenter les algorithmes de décision clinique, améliorant la qualité des soins et l'efficacité opérationnelle. La fabrication a investi dans la maintenance prédictive, et la vente au détail a exploité les moteurs de personnalisation, gardant l'industrie globale des bases de données en mémoire diversifiée.

Analyse géographique

L'Asie-Pacifique a enregistré les plus grands revenus régionaux à 32,2 % en 2024 et a maintenu une perspective TCAC de 17,1 %. Les programmes nationaux Industrie 4.0 en Chine, Japon et Inde ont stimulé l'automation d'usine qui nécessitait des bases de données d'historien en mémoire pour des boucles de rétroaction MES sub-secondes. General Motors a lié plus de 100 000 connexions de technologie opérationnelle dans son déploiement MES 4.0, illustrant l'échelle des déploiements edge. Les fournisseurs locaux comme les moteurs relationnels indigènes avancés de Nautilus Technologies ont réduit la dépendance à la propriété intellectuelle étrangère.[3]Nautilus Technologies, "Tsurugi MCP対応版をOSSにてリリース," prtimes.jp

L'Amérique du Nord a formé un marché mature mais riche en innovation centré sur les services financiers, clouds hyperscale et R&D véhicules autonomes. Oracle et Google ont approfondi leur partenariat pour exécuter les services Oracle Database nativement sur Google Cloud, mariant les capacités SQL d'entreprise avec les accélérateurs IA. Le financement venture de la région a soutenu les acteurs émergents comme Dragonfly, intensifiant le brassage concurrentiel.

L'Europe a priorisé la conformité de souveraineté des données sous RGPD, stimulant l'adoption cloud hybride et favorisant les clusters sur site combinés avec des services gérés dans les centres de données locaux. Oracle a étendu la couverture Database@Azure à des régions UE supplémentaires pour satisfaire les règles de résidence. Le continent a aussi vu des déploiements de santé de bases de données HTAP pour alimenter les diagnostics IA sous des cadres de confidentialité stricts.

Le Moyen-Orient et l'Afrique ont investi dans la fibre de ville intelligente et les dorsales 5G, menant à des déploiements pilotes IIoT qui nécessitent une analytique en temps réel. L'Amérique du Sud a gagné en traction dans les opérations minières et la banque numérique, où la détection de fraude à faible latence justifiait les systèmes premium centrés sur la mémoire. Bien que les dépenses absolues dans ces deux régions restaient modestes, la croissance à deux chiffres a étendu la diversité globale du marché des bases de données en mémoire.

Paysage concurrentiel

Le marché des bases de données en mémoire est resté modérément fragmenté, avec SAP, Oracle, Microsoft et IBM exploitant de larges suites d'entreprise pour maintenir leur position. Leurs feuilles de route intègrent des magasins de vecteurs en base de données et des accélérateurs ML, s'alignant avec les demandes clients pour des plateformes unifiées. Le changement de licence de Redis a incité les hyperscalers à approuver Valkey, illustrant comment les modèles de gouvernance peuvent remodeler les lignes concurrentielles.

Les fournisseurs spécialisés comme Aerospike et Hazelcast ont concouru sur la latence prévisible et faible à l'échelle et le coût total inférieur par gigaoctet. Le succès d'Aerospike chez PayPal a prouvé la capacité de traiter des signaux de fraude en temps réel sur du matériel de base. Hazelcast a publié Platform 5.5 avec des connecteurs étendus qui ont simplifié les intégrations de pipeline IA.[4]Hazelcast, "Announcing Hazelcast Platform 5.5 Release," hazelcast.com Dragonfly s'est positionné comme un remplacement direct de Redis avec une efficacité mono-cœur supérieure, défiant les incumbents dans la communauté des développeurs.

Les alliances stratégiques ont accéléré. L'accord d'Oracle d'avril 2025 avec Google Cloud a permis aux entreprises de consolider les bases de données et chaînes d'outils IA sans pénalités de sortie inter-cloud. AWS a formé un groupe IA agentique pour lier plus étroitement le développement de modèles aux services de données en mémoire. Les barrières à l'entrée du marché ont monté autour de la profondeur d'écosystème et des fonctionnalités IA intégrées, consolidant la part parmi les fournisseurs qui peuvent déployer à la fois l'excellence transactionnelle et la recherche vectorielle nativement.

Leaders de l'industrie des bases de données en mémoire

-

IBM Corporation

-

Microsoft Corporation

-

Oracle Corporation

-

SAP SE

-

TIBCO Software Inc.

- *Avis de non-responsabilité : les principaux acteurs sont triés sans ordre particulier

Développements récents de l'industrie

- Mai 2025 : AWS a annoncé la disponibilité générale d'Amazon Aurora DSQL pour livrer une scalabilité SQL distribuée avec des performances de style en mémoire.

- Mai 2025 : Amazon ElastiCache et MemoryDB ont ajouté le support pour Valkey 7.2, offrant la compatibilité open-source et une tarification compétitive.

- Avril 2025 : Oracle et Google Cloud ont dévoilé un programme partenaire qui exécute les services Oracle Database nativement sur Google Cloud.

- Mars 2025 : AWS a créé un nouveau groupe IA agentique sous Swami Sivasubramanian pour intégrer l'IA avec l'infrastructure de base de données.

Portée du rapport mondial du marché des bases de données en mémoire

Les bases de données en mémoire sont des systèmes spécialisés qui stockent les données largement en mémoire, par opposition aux bases de données qui stockent les informations sur disques ou SSD. Le stockage de données en mémoire vise à fournir des temps de réaction rapides en supprimant l'exigence d'accès disque.

Le marché des bases de données en mémoire est segmenté par taille d'industrie (petite, moyenne et grande), utilisateur final (BFSI, vente au détail, logistique et transport, divertissement et médias, santé, IT et télécommunication, et autres), et géographie (Amérique du Nord (États-Unis, Canada), Europe (Allemagne, Royaume-Uni, France, et reste de l'Europe), Asie-Pacifique (Inde, Chine, Japon, et reste de l'Asie-Pacifique), et reste du monde).

Les tailles et prévisions de marché sont fournies en termes de valeur (millions USD) pour tous les segments ci-dessus.

| OLTP |

| OLAP |

| Traitement transactionnel/analytique hybride (HTAP) |

| Sur site |

| Cloud |

| Edge/Intégré |

| Relationnel (SQL) |

| NoSQL (Clé-valeur, Document, Graphe) |

| Multi-modèle |

| Petites et moyennes entreprises (PME) |

| Grandes entreprises |

| Traitement de transactions en temps réel |

| Analytique opérationnelle et tableaux de bord BI |

| Service de modèles IA/ML |

| Cache et magasins de sessions |

| BFSI |

| Télécommunications et IT |

| Vente au détail et e-commerce |

| Santé et sciences de la vie |

| Fabrication et IoT industriel |

| Médias et divertissement |

| Gouvernement et défense |

| Autres (énergie, éducation, etc.) |

| Amérique du Nord | États-Unis | |

| Canada | ||

| Mexique | ||

| Europe | Allemagne | |

| France | ||

| Royaume-Uni | ||

| Pays nordiques | ||

| Reste de l'Europe | ||

| Asie-Pacifique | Chine | |

| Taïwan | ||

| Corée du Sud | ||

| Japon | ||

| Inde | ||

| Reste de l'Asie-Pacifique | ||

| Amérique du Sud | Brésil | |

| Mexique | ||

| Argentine | ||

| Reste de l'Amérique du Sud | ||

| Moyen-Orient et Afrique | Moyen-Orient | Arabie saoudite |

| Émirats arabes unis | ||

| Turquie | ||

| Reste du Moyen-Orient | ||

| Afrique | Afrique du Sud | |

| Reste de l'Afrique | ||

| Par type de traitement | OLTP | ||

| OLAP | |||

| Traitement transactionnel/analytique hybride (HTAP) | |||

| Par mode de déploiement | Sur site | ||

| Cloud | |||

| Edge/Intégré | |||

| Par modèle de données | Relationnel (SQL) | ||

| NoSQL (Clé-valeur, Document, Graphe) | |||

| Multi-modèle | |||

| Par taille d'organisation | Petites et moyennes entreprises (PME) | ||

| Grandes entreprises | |||

| Par application | Traitement de transactions en temps réel | ||

| Analytique opérationnelle et tableaux de bord BI | |||

| Service de modèles IA/ML | |||

| Cache et magasins de sessions | |||

| Par secteur d'utilisateur final | BFSI | ||

| Télécommunications et IT | |||

| Vente au détail et e-commerce | |||

| Santé et sciences de la vie | |||

| Fabrication et IoT industriel | |||

| Médias et divertissement | |||

| Gouvernement et défense | |||

| Autres (énergie, éducation, etc.) | |||

| Par géographie | Amérique du Nord | États-Unis | |

| Canada | |||

| Mexique | |||

| Europe | Allemagne | ||

| France | |||

| Royaume-Uni | |||

| Pays nordiques | |||

| Reste de l'Europe | |||

| Asie-Pacifique | Chine | ||

| Taïwan | |||

| Corée du Sud | |||

| Japon | |||

| Inde | |||

| Reste de l'Asie-Pacifique | |||

| Amérique du Sud | Brésil | ||

| Mexique | |||

| Argentine | |||

| Reste de l'Amérique du Sud | |||

| Moyen-Orient et Afrique | Moyen-Orient | Arabie saoudite | |

| Émirats arabes unis | |||

| Turquie | |||

| Reste du Moyen-Orient | |||

| Afrique | Afrique du Sud | ||

| Reste de l'Afrique | |||

Questions clés répondues dans le rapport

Quelle est la valeur actuelle du marché des bases de données en mémoire ?

Le marché des bases de données en mémoire était évalué à 7,08 milliards USD en 2025 et devrait atteindre 13,62 milliards USD d'ici 2030.

Quelle région mène la croissance du marché des bases de données en mémoire ?

L'Asie-Pacifique a mené avec 32,2 % de revenus en 2024 et devrait afficher un TCAC de 17,1 % jusqu'en 2030.

Pourquoi les architectures HTAP sont-elles importantes pour les charges de travail IA ?

HTAP unifie le traitement transactionnel et analytique, permettant l'inférence en temps réel sans délais ETL, comme démontré par Oracle HeatWave GenAI.

Comment la baisse des prix DRAM affecte-t-elle l'adoption ?

La tarification USD/Go plus faible et les nouvelles options de mémoire persistante réduisent le coût total de possession, rendant les déploiements en mémoire économiquement viables.

Quels défis limitent les très grands clusters en mémoire ?

L'architecture haute disponibilité devient complexe au-delà de 40 To, avec des protocoles de clustering encourant une surcharge de performance.

Dernière mise à jour de la page le: