Tamaño y participación del mercado de bases de datos en memoria

Análisis del mercado de bases de datos en memoria por Mordor Intelligence

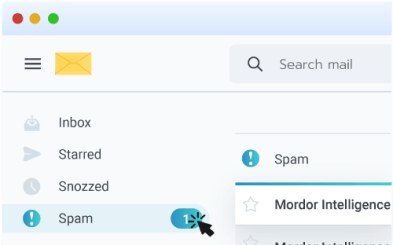

El tamaño del mercado global de bases de datos en memoria se situó en 7,08 mil millones de dólares en 2025 y se espera que alcance los 13,62 mil millones de dólares en 2030, avanzando a una TCAC del 13,98% durante el período de pronóstico. Los requisitos de rendimiento de submilisegundos de microservicios nativos de la nube, motores de inferencia de IA y plataformas de análisis de streaming continuaron empujando a las empresas hacia arquitecturas centradas en memoria. Los precios más bajos de la DRAM y la llegada de módulos de memoria persistente basados en CXL han reducido el costo total de propiedad, alentando a más cargas de trabajo a migrar desde sistemas respaldados por disco. Las implementaciones de edge en vehículos conectados y plantas de IoT industrial ampliaron aún más la demanda porque el procesamiento local evita las penalizaciones de latencia de red. La dinámica competitiva se mantuvo fluida ya que los proveedores tradicionales profundizaron las integraciones con nubes hiperescala mientras que las bifurcaciones de código abierto ganaron impulso, dando a los compradores nuevos caminos para evitar el bloqueo de proveedor.

Conclusiones clave del informe

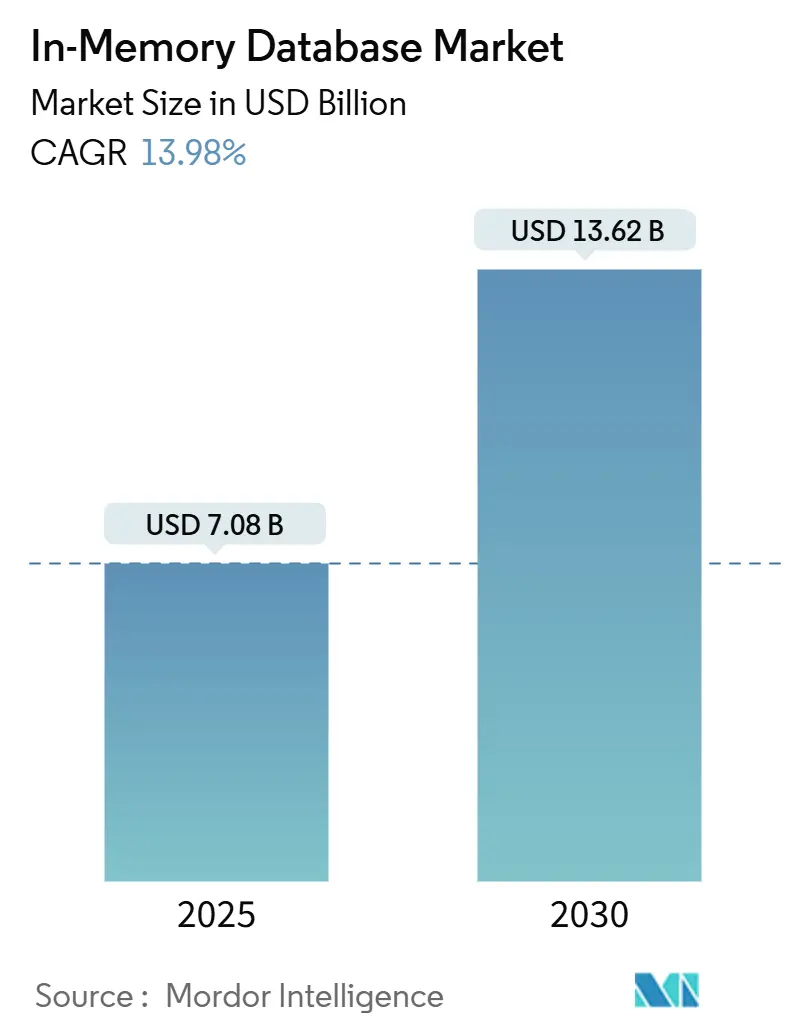

- Por tipo de procesamiento, el procesamiento de transacciones en línea (OLTP) lideró con el 45,3% de la participación del mercado de bases de datos en memoria en 2024, mientras que se proyecta que el procesamiento transaccional/analítico híbrido (HTAP) crezca a una TCAC del 21,1% hasta 2030.

- Por modo de implementación, las instalaciones on-premise mantuvieron el 55,4% de la participación de ingresos en 2024; se prevé que las implementaciones de edge e integradas se expandan a una TCAC del 23,2% hasta 2030.

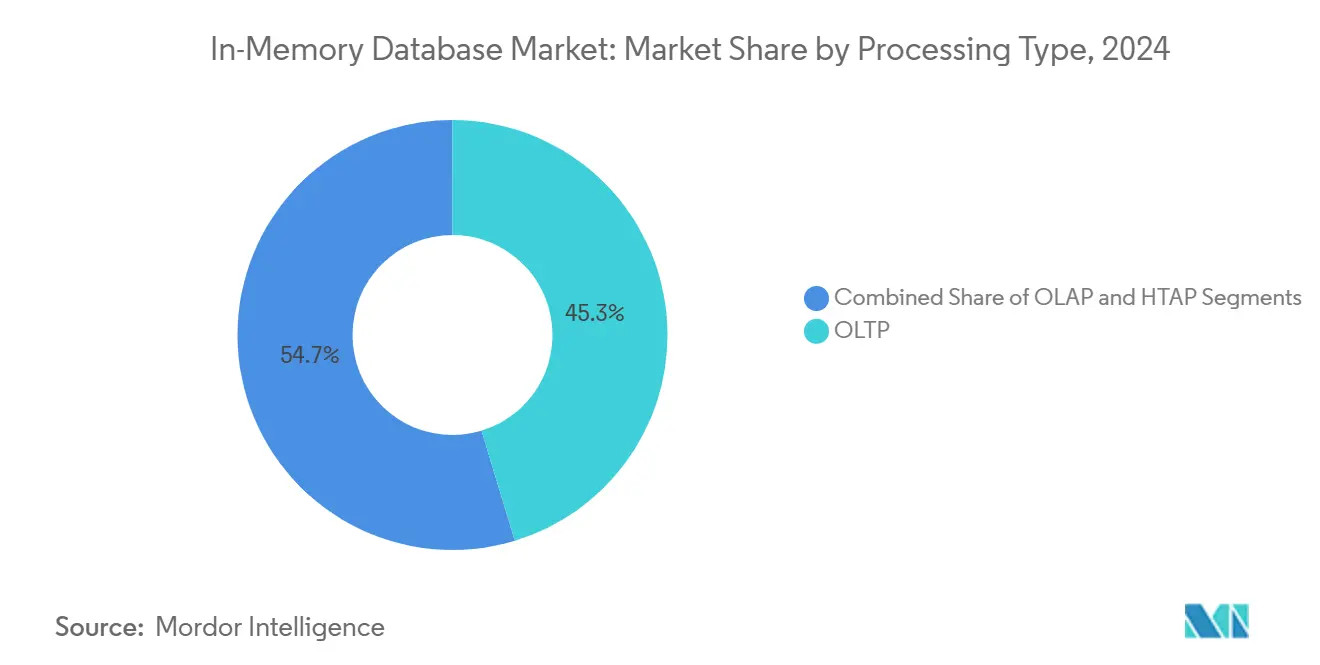

- Por modelo de datos, SQL relacional capturó una participación del 60,4% en 2024, mientras que las plataformas multimodelo están configuradas para registrar una TCAC del 20,1% entre 2025 y 2030.

- Por tamaño de organización, las grandes empresas mantuvieron el 70,5% de participación del tamaño del mercado de bases de datos en memoria en 2024; las pequeñas y medianas empresas registrarán la TCAC más rápida del 18,1% hasta 2030.

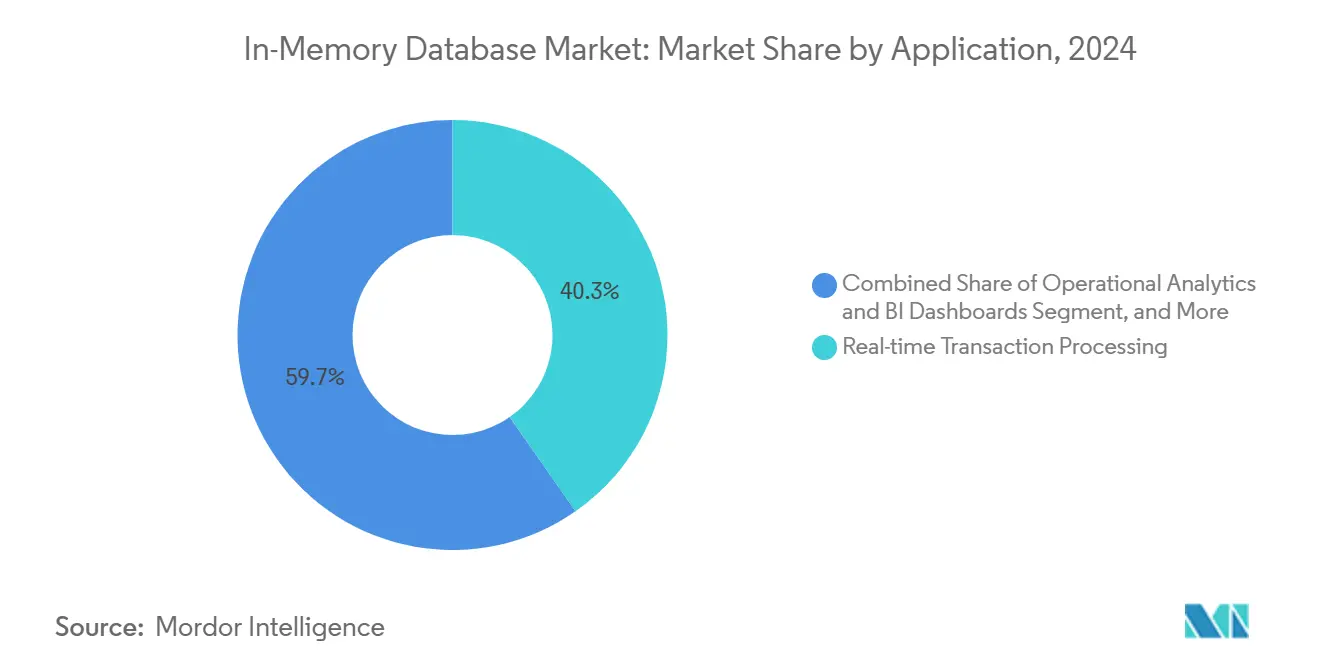

- Por aplicación, el procesamiento de transacciones en tiempo real representó el 40,3% del tamaño del mercado de bases de datos en memoria en 2024, mientras que se prevé que el servicio de modelos de IA/ML se expanda a una TCAC del 24,2% hasta 2030.

- Por industria de usuario final, BFSI dominó con el 28,2% de participación de ingresos en 2024; la atención sanitaria y ciencias de la vida están posicionadas para una TCAC del 18,1% hasta 2030.

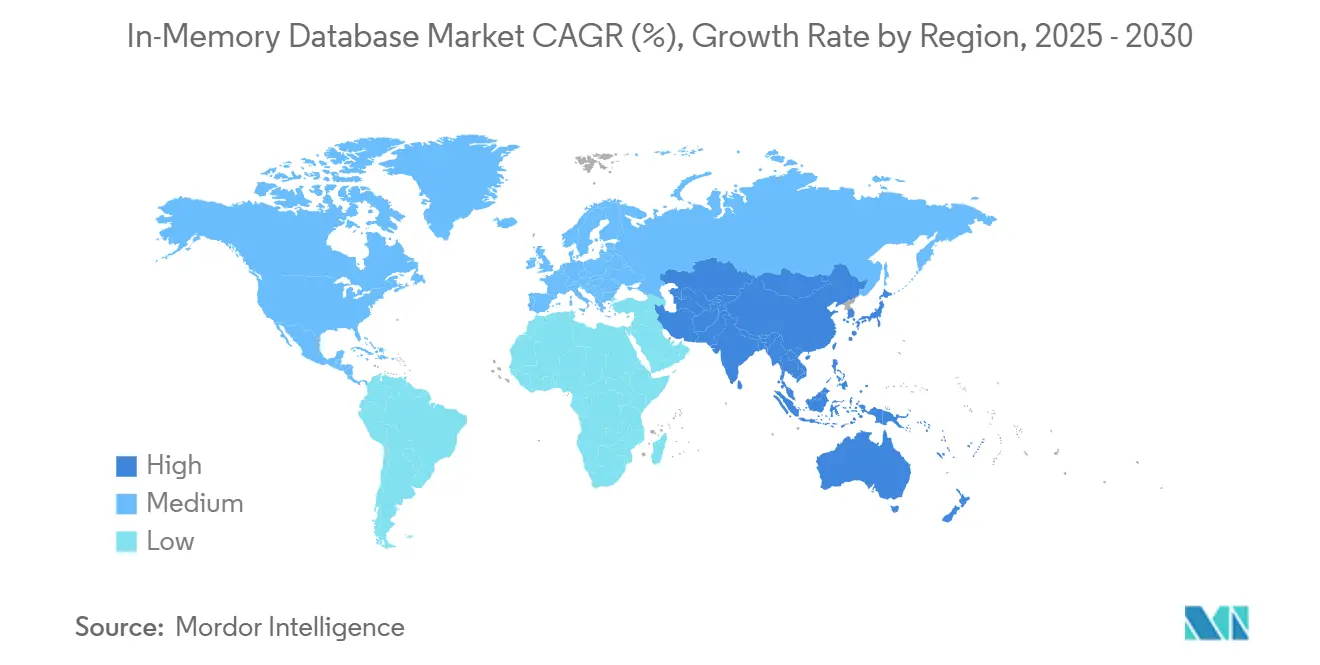

- Por geografía, Asia-Pacífico comandó el 32,2% de los ingresos globales en 2024 y se mantiene como la región de más rápido crecimiento con una TCAC del 17,1% hasta 2030.

Tendencias y perspectivas del mercado global de bases de datos en memoria

Análisis de impacto de impulsores

| Impulsor | (~) % de impacto en el pronóstico de TCAC | Relevancia geográfica | Cronograma de impacto |

|---|---|---|---|

| Microservicios nativos de la nube que demandan latencia de submilisegundos | +3.2% | Global, con concentración en América del Norte y UE | Corto plazo (≤ 2 años) |

| Caída del USD/GB de DRAM y memoria persistente ampliando la brecha de TCO vs. disco | +2.8% | Global, adopción temprana en centros de fabricación de APAC | Mediano plazo (2-4 años) |

| Adopción de análisis de streaming en BFSI y telecomunicaciones para fraude y QoS de red | +2.1% | Centros financieros de América del Norte y UE, infraestructura de telecomunicaciones de APAC | Corto plazo (≤ 2 años) |

| Arquitecturas HTAP acelerando el servicio de modelos de IA/ML en atención sanitaria | +1.9% | Global, con adopción impulsada por regulación en UE y América del Norte | Mediano plazo (2-4 años) |

| Casos de uso de edge-compute (vehículos conectados, IIoT) que requieren IMDB integrada | +2.4% | Fabricación de APAC, corredores automotrices de América del Norte | Largo plazo (≥ 4 años) |

| Fuente: Mordor Intelligence | |||

Microservicios nativos de la nube que demandan latencia de submilisegundos

La adopción nativa de la nube remodeló las líneas base de rendimiento ya que los microservicios en contenedores necesitaban acceso a datos en microsegundos. Los almacenes de sesiones, motores de personalización y plataformas de trading de alta frecuencia cambiaron de bases de datos respaldadas por disco a almacenes centrados en memoria porque cada milisegundo de retraso reducía las tasas de conversión o el beneficio del trading. Dragonfly demostró 6,43 millones de operaciones por segundo en silicio AWS Graviton3E, destacando el techo ahora esperado de los niveles de base de datos.[1]DragonflyDB, "2024 New Year, New Number," dragonflydb.io Las instituciones financieras y operadores de comercio digital que migraron monolitos a sistemas distribuidos vieron mejoras en tiempo de respuesta traducirse en ganancias de ingresos tangibles, reforzando la importancia a corto plazo del impulsor.

Caída de los costos de DRAM y memoria persistente ampliando la brecha de TCO

Los precios al contado globales de módulos DDR4 y DDR5 continuaron deslizándose, mientras que el prototipo híbrido de módulo de memoria CXL de Samsung mostró latencia de clase DRAM con persistencia, creando un perfil de costo convincente. Los operadores hiperescala agruparon memoria a través de racks, reduciendo la capacidad varada y los ciclos de respaldo. Las empresas pivotaron hojas de ruta hacia la implementación en memoria porque la prima sobre los arrays SSD se estrechó, especialmente para cargas de trabajo de análisis con ventanas SLA estrechas. El efecto es visible en los centros de fabricación de Asia-Pacífico donde grandes conjuntos de datos de historiadores se mueven a memoria para análisis de gemelos digitales en tiempo real.

Adopción de análisis de streaming en BFSI y telecomunicaciones

Los bancos implementaron sistemas de detección de fraude de streaming que procesaron millones de autorizaciones de tarjetas por segundo usando el motor en memoria de Aerospike. Los operadores de telecomunicaciones desplegando 5G monitorearon registros de red de acceso por radio en tiempo real para mantener la calidad del servicio, aprovechando búsquedas vectoriales en MongoDB para marcar anomalías. La regulación en América del Norte y Europa requirió informes de actividad sospechosa en tiempo real, empujando la curva de adopción del impulsor abruptamente hacia arriba.

Arquitecturas HTAP acelerando el servicio de modelos de IA/ML

El procesamiento transaccional/analítico híbrido eliminó los retrasos de ETL al unificar escrituras y análisis en el mismo pool de memoria. Oracle integró modelos de lenguaje grandes dentro de HeatWave GenAI para que los registros de pacientes pudieran ser consultados y puntuados para decisiones clínicas sin movimiento de datos. Los proveedores de atención sanitaria adoptaron almacenes HTAP para servir predicciones durante consultas, mejorando resultados y reduciendo gastos generales de infraestructura, lo que sustentó el crecimiento sostenido a mediano plazo.

Análisis de impacto de restricciones

| Restricción | (~) % de impacto en el pronóstico de TCAC | Relevancia geográfica | Cronograma de impacto |

|---|---|---|---|

| Preocupaciones de bloqueo de proveedor en torno a formatos en memoria propietarios | -1.8% | Global, particularmente afectando empresas multi-nube | Corto plazo (≤ 2 años) |

| Complejidad de diseño de alta disponibilidad para clústeres >40 TB | -1.2% | Implementaciones empresariales en América del Norte y UE | Mediano plazo (2-4 años) |

| Leyes de soberanía de datos (ej., China CSL, UE GDPR) limitando la replicación global | -0.9% | UE, China, con efectos secundarios a implementaciones multinacionales | Largo plazo (≥ 4 años) |

| Fuente: Mordor Intelligence | |||

Preocupaciones de bloqueo de proveedor en torno a formatos propietarios

El cambio de licencia de Redis en 2024 aumentó la cautela del comprador sobre formatos propietarios, estimulando a AWS, Google y Oracle a respaldar la bifurcación Valkey bajo la Linux Foundation. Las empresas presupuestando proyectos de base de datos multi-año factorizaron costos de salida, ralentizando los ciclos de compra. Para mitigar el riesgo, algunos adoptaron capas de orquestación multi-base de datos, pero esas abstracciones introdujeron penalizaciones de latencia que parcialmente compensaron las ganancias de velocidad de memoria.

Complejidad de diseño de alta disponibilidad para clústeres grandes

Los clústeres más grandes de 40 TB encontraron gastos generales de protocolo que degradaron los tiempos de sincronización de réplicas. El enfoque de gossip de Redis Cluster escaló cuadráticamente, mientras que la orquestación alternativa de Dragonfly mejoró pero aún requería scripts de monitoreo intrincados. Las cargas de trabajo de servicios financieros que demandaban disponibilidad de cinco nueves dudaron en migrar los conjuntos de datos más grandes completamente a memoria, optando por niveles híbridos que diluyeron el rendimiento máximo.

Análisis de segmento

Por tipo de procesamiento: HTAP emerge como arquitectura unificada

El segmento OLTP mantuvo el 45,3% de la participación del mercado de bases de datos en memoria en 2024, subrayando la continua dependencia en cargas de trabajo transaccionales de alta integridad a través de sistemas bancarios, de comercio electrónico y ERP. La demanda persistió porque los registros de misión crítica aún requerían cumplimiento ACID, con empresas pagando una prima de rendimiento por commits de submilisegundos. Las implementaciones OLAP abordaron front ends de inteligencia de negocios establecidos pero crecieron lentamente ya que los análisis se desplazaron hacia motores más flexibles.

HTAP subió con un pronóstico de TCAC del 21,1% de 2025 a 2030 ya que las firmas buscaron simplicidad de plataforma única. La plataforma de GridGain mostró aceleraciones de hasta 1,000× sobre sistemas basados en disco mientras mantenía soporte ANSI SQL-99.[2]GridGain Systems, "Hybrid Transactional/Analytical Processing (HTAP)," gridgain.com Los cálculos de riesgo en tiempo real y gemelos de cadena de suministro necesitaban acceso simultáneo de lectura-escritura, haciendo de HTAP la arquitectura preferida. La convergencia desbloqueó presupuesto incremental de departamentos anteriormente aislados entre operaciones y análisis, empujando el mercado de bases de datos en memoria hacia diseños unificados.

Nota: Las participaciones de segmento de todos los segmentos individuales están disponibles con la compra del informe

Por modo de implementación: la computación de edge impulsa el crecimiento integrado

Las instalaciones on-premise capturaron el 55,4% de los ingresos de 2024 porque los sectores regulados requerían control total sobre la residencia de datos y arquitecturas de HA personalizadas. Los stacks de software empresarial heredado se integraron estrechamente con bases de datos on-premise, anclando el gasto incluso mientras las nubes públicas maduran. Las implementaciones en la nube, no obstante, han avanzado ya que las firmas nativas digitales adoptaron servicios gestionados para evitar la administración de infraestructura.

Las implementaciones de edge e integradas mostraron una perspectiva de TCAC del 23,2%, alimentadas por autos conectados y gateways de IIoT. Los vehículos modernos generan alrededor de 300 TB anualmente, lo que demanda procesamiento en el vehículo para características autónomas. TDengine logró 10× compresión sobre Elasticsearch en telemetría de vehículos inteligentes, cortando ancho de banda para transferencias upstream. Los fabricantes aplicaron estrategias similares en líneas de producción para detectar defectos instantáneamente. El cambio señaló que las ganancias de rendimiento una vez reservadas para centros de datos ahora eran indispensables en el edge, expandiendo la huella del mercado de bases de datos en memoria.

Por modelo de datos: las arquitecturas multimodelo ganan tracción

Los motores SQL relacionales retuvieron el 60,4% de ingresos en 2024 porque décadas de código de aplicación y habilidades de desarrollador permanecieron vinculadas al modelo. Las corporaciones dudaron en reescribir sistemas centrales, preservando la primacía relacional incluso cuando surgieron nuevos casos de uso. Las categorías NoSQL-clave-valor, documento, grafo-abordaron esquemas flexibles pero sirvieron cargas de trabajo más estrechas.

Las plataformas multimodelo pronosticaron una TCAC del 20,1% ya que las cargas de trabajo de IA demandan almacenamiento unificado para registros estructurados, vectores y texto no estructurado. Hazelcast añadió búsqueda vectorial junto a APIs tradicionales de clave-valor. Consolidar tipos de datos variados en un pool de memoria único redujo la complejidad operacional y latencia, habilitando IA conversacional, grafos de fraude y pipelines de recomendación. Se espera que este impulso expanda el mercado de bases de datos en memoria a través de paisajes de datos heterogéneos.

Por tamaño de organización: las PYMES aceleran la adopción en la nube

Las grandes empresas representaron el 70,5% de ingresos en 2024 debido a la intensidad de capital de implementaciones a escala de petabytes y demandas de SLA estrictas. Los bancos globales, operadores de telecomunicaciones y firmas aeroespaciales invirtieron en clústeres redundantes con terabytes de DRAM para mantener la continuidad del negocio. Su capacidad presupuestaria los protegió de altos costos por gigabyte.

Se proyecta que las pequeñas y medianas empresas suban a una TCAC del 18,1% a través de servicios gestionados. AWS introdujo Aurora DSQL para combinar semánticas SQL distribuidas con rendimiento estilo en memoria. Al descargar escalado y parcheo a proveedores de nube, las startups accedieron a latencia de grado empresarial para productos micro-SaaS sin gastos generales de personal. El soporte de Valkey de ElastiCache redujo gastos de licencias, acelerando la democratización del mercado de bases de datos en memoria entre firmas con restricciones presupuestarias.

Por aplicación: el servicio de modelos de IA/ML impulsa la innovación

El procesamiento de transacciones en tiempo real mantuvo la porción más grande en 40,3% en 2024, con trading de acciones, gateways de pago y sistemas de inventario dependientes de commits instantáneos. Los análisis operacionales entregaron dashboards para fabricación y observabilidad de TI, pero desaceleraron ya que nuevos casos de uso de IA capturaron gasto.

Se prevé que el servicio de modelos de IA/ML se expanda a una TCAC del 24,2% ya que las empresas integran índices vectoriales e embeddings directamente en bases de datos para inferencia. Microsoft propuso Managed Retention Memory para reducir la latencia en ejecución de modelos de lenguaje grandes. El patrón integra inferencia dentro de la capa transaccional, eliminando saltos WAN entre servidores de modelo y datos fuente. Se espera que las cargas de trabajo híbridas que combinan actualizaciones ACID con búsquedas de similitud vectorial dominen los ingresos incrementales del mercado de bases de datos en memoria.

Por industria de usuario final: la atención sanitaria lidera la transformación digital

BFSI comandó el 28,2% de ingresos en 2024, reflejando adopción temprana para trading de alta frecuencia y prevención de fraude. Los mandatos regulatorios para informes en tiempo real y requisitos RTO estrictos aseguraron inversión continua. Las telecomunicaciones aplican análisis en memoria para orquestación de red y perspectivas de experiencia del cliente, sosteniendo una participación estable.

La atención sanitaria y ciencias de la vida muestran una perspectiva de TCAC del 18,1%. Corti lanzó infraestructura de IA especializada que requiere acceso inmediato a datos de pacientes para soporte diagnóstico. Los proveedores de registros electrónicos de salud integraron bases de datos HTAP para alimentar algoritmos de decisión clínica, mejorando la calidad de atención y eficiencia operacional. La fabricación invirtió en mantenimiento predictivo, y el retail aprovechó motores de personalización, manteniendo diversificada la industria general de bases de datos en memoria.

Análisis geográfico

Asia-Pacífico registró los mayores ingresos regionales con 32,2% en 2024 y mantuvo una perspectiva de TCAC del 17,1%. Los programas nacionales de Industria 4.0 en China, Japón e India estimularon la automatización de fábricas que requería bases de datos de historiadores en memoria para bucles de retroalimentación MES de subsegundos. General Motors vinculó más de 100,000 conexiones de tecnología operacional en su despliegue MES 4.0, ilustrando la escala de implementaciones de edge. Proveedores locales como los motores relacionales indígenas avanzados de Nautilus Technologies, reduciendo la dependencia de IP extranjera.[3]Nautilus Technologies, "Tsurugi MCP対応版をOSSにてリリース," prtimes.jp

América del Norte formó un mercado maduro pero rico en innovación centrado en servicios financieros, nubes hiperescala e I+D de vehículos autónomos. Oracle y Google profundizaron su asociación para ejecutar servicios de Oracle Database nativamente en Google Cloud, casando capacidades SQL empresariales con aceleradores de IA. La financiación de capital de riesgo de la región apoyó jugadores emergentes como Dragonfly, intensificando la agitación competitiva.

Europa priorizó el cumplimiento de soberanía de datos bajo GDPR, impulsando la adopción de nube híbrida y favoreciendo clústeres on-premise combinados con servicios gestionados en centros de datos locales. Oracle expandió la cobertura de Database@Azure a regiones adicionales de la UE para satisfacer las reglas de residencia. El continente también vio implementaciones de atención sanitaria de bases de datos HTAP para potenciar diagnósticos de IA bajo marcos de privacidad estrictos.

Oriente Medio y África invirtieron en backbones de fibra de ciudad inteligente y 5G, llevando a implementaciones piloto de IIoT que requieren análisis en tiempo real. América del Sur ganó tracción en operaciones mineras y banca digital, donde la detección de fraude de baja latencia justificó sistemas premium centrados en memoria. Aunque el gasto absoluto en estas dos regiones permaneció modesto, el crecimiento de dos dígitos expandió la diversidad global del mercado de bases de datos en memoria.

Panorama competitivo

El mercado de bases de datos en memoria se mantuvo moderadamente fragmentado, con SAP, Oracle, Microsoft e IBM aprovechando suites empresariales amplias para retener incumbencia. Sus hojas de ruta integran almacenes vectoriales en base de datos y aceleradores ML, alineándose con demandas de clientes por plataformas unificadas. El cambio de licencia de Redis impulsó a los hiperescaladores a respaldar Valkey, ilustrando cómo los modelos de gobernanza pueden remodelar las líneas competitivas.

Proveedores especialistas como Aerospike y Hazelcast compitieron en latencia predecible y baja a escala y menor costo total por gigabyte. El éxito de Aerospike en PayPal probó la capacidad de procesar señales de fraude en tiempo real en hardware commodity. Hazelcast lanzó Platform 5.5 con conectores extendidos que simplificaron integraciones de pipelines de IA.[4]Hazelcast, "Announcing Hazelcast Platform 5.5 Release," hazelcast.com Dragonfly se posicionó como un reemplazo directo para Redis con eficiencia de núcleo único superior, desafiando incumbentes en la comunidad de desarrolladores.

Las alianzas estratégicas se aceleraron. El acuerdo de Oracle de abril de 2025 con Google Cloud habilitó a las empresas consolidar bases de datos y toolchains de IA sin penalizaciones de egreso inter-nube. AWS formó un grupo de IA agéntica para vincular el desarrollo de modelos más estrechamente a servicios de datos en memoria. Las barreras de entrada al mercado se elevaron en torno a la profundidad del ecosistema y características de IA integradas, consolidando participación entre proveedores que pueden ofrecer tanto excelencia transaccional como búsqueda vectorial nativamente.

Líderes de la industria de bases de datos en memoria

-

IBM Corporation

-

Microsoft Corporation

-

Oracle Corporation

-

SAP SE

-

TIBCO Software Inc.

- *Nota aclaratoria: los principales jugadores no se ordenaron de un modo en especial

Desarrollos recientes de la industria

- Mayo de 2025: AWS anunció la disponibilidad general de Amazon Aurora DSQL para entregar escalabilidad SQL distribuida con rendimiento estilo en memoria.

- Mayo de 2025: Amazon ElastiCache y MemoryDB añadieron soporte para Valkey 7.2, ofreciendo compatibilidad de código abierto y precios competitivos.

- Abril de 2025: Oracle y Google Cloud desvelaron un programa de socios que ejecuta servicios de Oracle Database nativamente en Google Cloud.

- Marzo de 2025: AWS creó un nuevo grupo de IA agéntica bajo Swami Sivasubramanian para integrar IA con infraestructura de base de datos.

Alcance del informe global del mercado de bases de datos en memoria

Las bases de datos en memoria son sistemas construidos específicamente que almacenan datos en gran medida en memoria, a diferencia de las bases de datos que almacenan información en discos o SSD. El almacenamiento de datos en memoria está diseñado para proporcionar tiempos de respuesta rápidos eliminando el requisito de acceso a disco.

El mercado de bases de datos en memoria está segmentado por tamaño de industria (pequeña, mediana y grande), usuario final (BFSI, retail, logística y transporte, entretenimiento y medios, atención sanitaria, TI y telecomunicaciones, y otros), y geografía (América del Norte (EE.UU., Canadá), Europa (Alemania, Reino Unido, Francia, y resto de Europa), Asia Pacífico (India, China, Japón, y resto de Asia-Pacífico), y resto del mundo).

Los tamaños de mercado y pronósticos se proporcionan en términos de valor (millones de USD) para todos los segmentos mencionados anteriormente.

| OLTP |

| OLAP |

| Procesamiento transaccional/analítico híbrido (HTAP) |

| On-premise |

| Nube |

| Edge/Integrado |

| Relacional (SQL) |

| NoSQL (Clave-valor, Documento, Grafo) |

| Multimodelo |

| Pequeñas y medianas empresas (PYMES) |

| Grandes empresas |

| Procesamiento de transacciones en tiempo real |

| Análisis operacional y dashboards de BI |

| Servicio de modelos de IA/ML |

| Caché y almacenes de sesión |

| BFSI |

| Telecomunicaciones y TI |

| Retail y comercio electrónico |

| Atención sanitaria y ciencias de la vida |

| Fabricación e IoT industrial |

| Medios y entretenimiento |

| Gobierno y defensa |

| Otros (Energía, Educación, etc.) |

| América del Norte | Estados Unidos | |

| Canadá | ||

| México | ||

| Europa | Alemania | |

| Francia | ||

| Reino Unido | ||

| Países nórdicos | ||

| Resto de Europa | ||

| Asia-Pacífico | China | |

| Taiwán | ||

| Corea del Sur | ||

| Japón | ||

| India | ||

| Resto de Asia-Pacífico | ||

| América del Sur | Brasil | |

| México | ||

| Argentina | ||

| Resto de América del Sur | ||

| Oriente Medio y África | Oriente Medio | Arabia Saudita |

| Emiratos Árabes Unidos | ||

| Turquía | ||

| Resto de Oriente Medio | ||

| África | Sudáfrica | |

| Resto de África | ||

| Por tipo de procesamiento | OLTP | ||

| OLAP | |||

| Procesamiento transaccional/analítico híbrido (HTAP) | |||

| Por modo de implementación | On-premise | ||

| Nube | |||

| Edge/Integrado | |||

| Por modelo de datos | Relacional (SQL) | ||

| NoSQL (Clave-valor, Documento, Grafo) | |||

| Multimodelo | |||

| Por tamaño de organización | Pequeñas y medianas empresas (PYMES) | ||

| Grandes empresas | |||

| Por aplicación | Procesamiento de transacciones en tiempo real | ||

| Análisis operacional y dashboards de BI | |||

| Servicio de modelos de IA/ML | |||

| Caché y almacenes de sesión | |||

| Por industria de usuario final | BFSI | ||

| Telecomunicaciones y TI | |||

| Retail y comercio electrónico | |||

| Atención sanitaria y ciencias de la vida | |||

| Fabricación e IoT industrial | |||

| Medios y entretenimiento | |||

| Gobierno y defensa | |||

| Otros (Energía, Educación, etc.) | |||

| Por geografía | América del Norte | Estados Unidos | |

| Canadá | |||

| México | |||

| Europa | Alemania | ||

| Francia | |||

| Reino Unido | |||

| Países nórdicos | |||

| Resto de Europa | |||

| Asia-Pacífico | China | ||

| Taiwán | |||

| Corea del Sur | |||

| Japón | |||

| India | |||

| Resto de Asia-Pacífico | |||

| América del Sur | Brasil | ||

| México | |||

| Argentina | |||

| Resto de América del Sur | |||

| Oriente Medio y África | Oriente Medio | Arabia Saudita | |

| Emiratos Árabes Unidos | |||

| Turquía | |||

| Resto de Oriente Medio | |||

| África | Sudáfrica | ||

| Resto de África | |||

Preguntas clave respondidas en el informe

¿Cuál es el valor actual del mercado de bases de datos en memoria?

El mercado de bases de datos en memoria fue valorado en 7,08 mil millones de dólares en 2025 y se proyecta que alcance los 13,62 mil millones de dólares en 2030.

¿Qué región lidera el crecimiento del mercado de bases de datos en memoria?

Asia-Pacífico lideró con el 32,2% de ingresos en 2024 y se espera que registre una TCAC del 17,1% hasta 2030.

¿Por qué son importantes las arquitecturas HTAP para las cargas de trabajo de IA?

HTAP unifica el procesamiento transaccional y analítico, habilitando inferencia en tiempo real sin retrasos de ETL, como se muestra por Oracle HeatWave GenAI.

¿Cómo están afectando los precios decrecientes de DRAM la adopción?

Los precios más bajos de USD/GB y las nuevas opciones de memoria persistente reducen el costo total de propiedad, haciendo las implementaciones en memoria económicamente viables.

¿Qué desafíos limitan los clústeres en memoria muy grandes?

La arquitectura de alta disponibilidad se vuelve compleja más allá de 40 TB, con protocolos de clusterización incurriendo en gastos generales de rendimiento.

Última actualización de la página el: