Taille et parts du marché du Big Données En tant que service

Analyse du marché du Big Données En tant que service par Mordor Intelligence

La taille du marché du Big Données En tant que service est estimée à 41,55 milliards USD en 2025, et devrait atteindre 141,71 milliards USD d'ici 2030, à un TCAC de 27,81% pendant la période de prévision (2025-2030).

Le marché du big Données En tant que service un atteint 41,55 milliards USD en 2025 et devrait grimper à 141,71 milliards USD d'ici 2030, reflétant un taux de croissance annuel composé de 27,81%. La demande s'intensifie à mesure que les entreprises remplacent les systèmes sur site à forte intensité capitalistique par des analyses cloud basées sur l'utilisation qui s'adaptent aux charges de travail d'intelligence artificielle. Une poussée dans les pilotes d'IA générative, des déploiements IoT industriels plus larges, et un changement mondial vers une tarification à l'usage ont réduit les barrières à l'adoption. Les fournisseurs hyperscale ont donc investi plus de 105 milliards USD chaque année dans de nouvelles capacités pour répondre aux besoins élastiques de traitement de données.[1]Ari Levy, "Cloud giants pour USD 105 billion into Données-center build-outs," cnbc.com L'Amérique du Nord conserve le leadership, mais l'Asie-Pacifique montre la trajectoire la plus forte alors que les fabricants et institutions financières accélèrent les migrations cloud. Ensemble, ces forces soutiennent des perspectives solides pour le marché du big Données En tant que service à travers la décennie.

Points clés du rapport

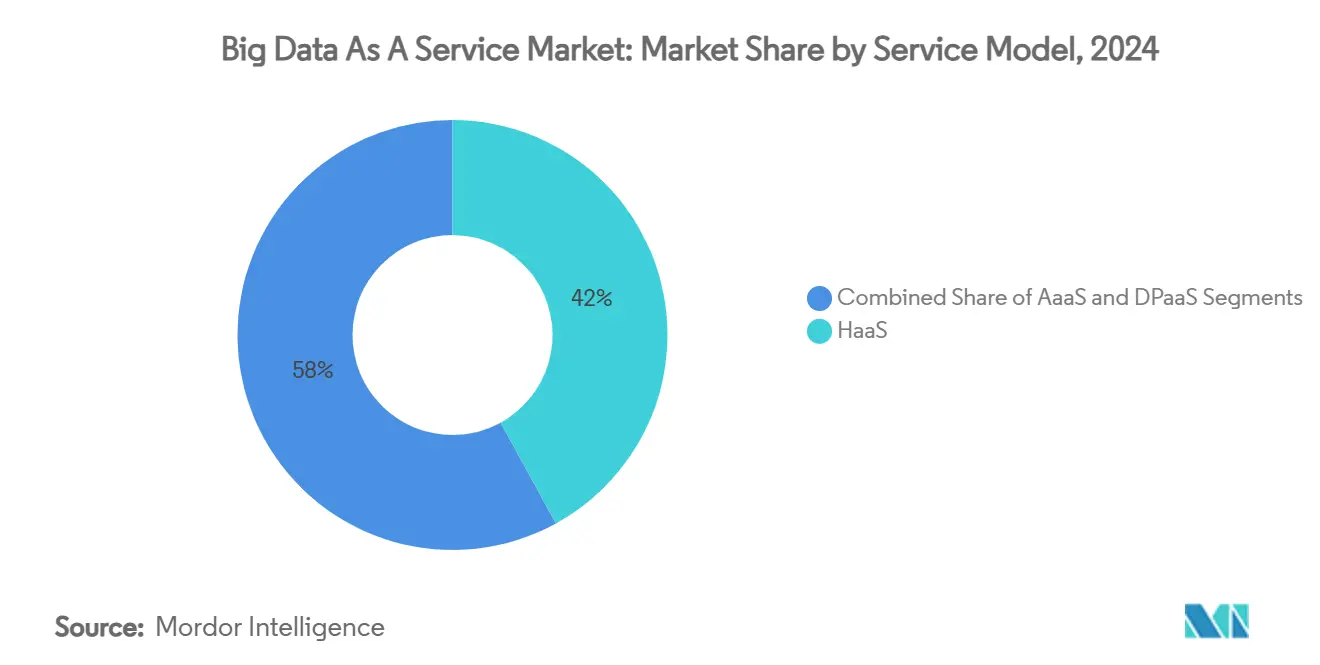

- Par modèle de service, Hadoop-en tant que service un dominé avec 42% de part de revenus du marché du big Données En tant que service en 2024 ; Analytique-en tant que service devrait s'étendre à un TCAC de 30,61% jusqu'en 2030.

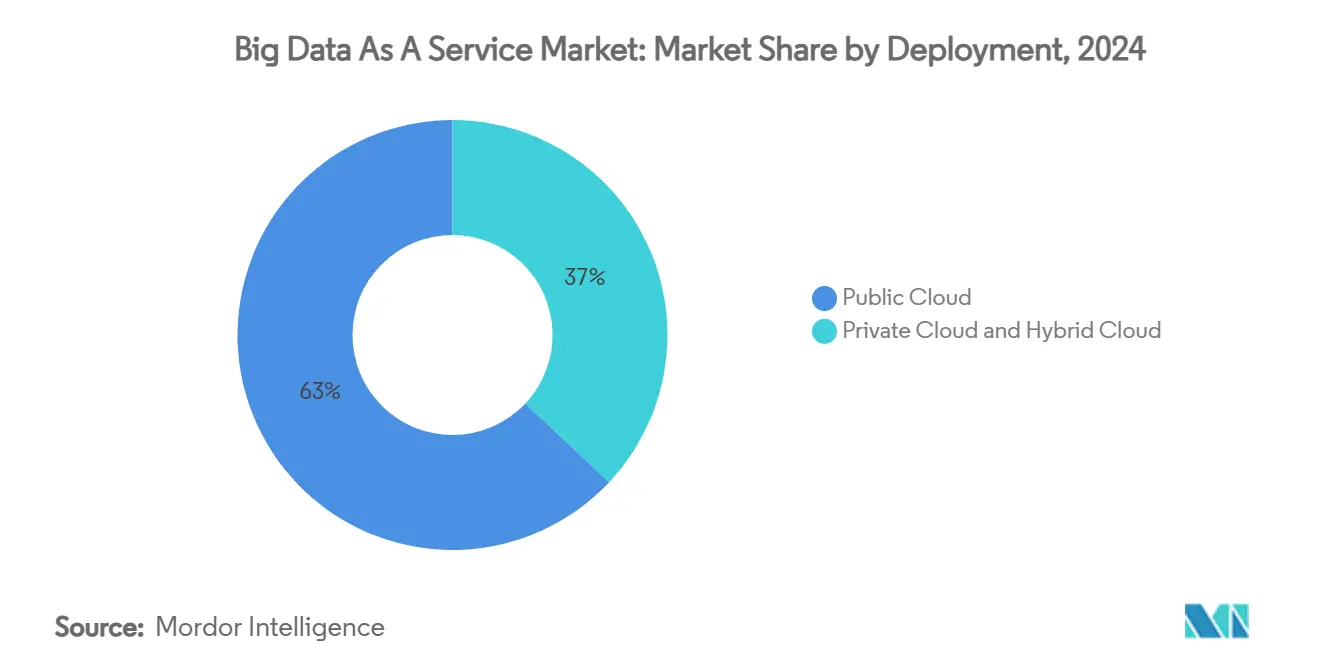

- Par déploiement, le cloud public un détenu 63% de la taille du marché du big Données En tant que service en 2024, tandis que le cloud hybride devrait enregistrer le TCAC le plus rapide de 29,51% jusqu'en 2030.

- Par secteur d'utilisateur final, BFSI un représenté 28% de part du marché du big Données En tant que service en 2024 ; la santé croît à un TCAC de 27,91% jusqu'en 2030.

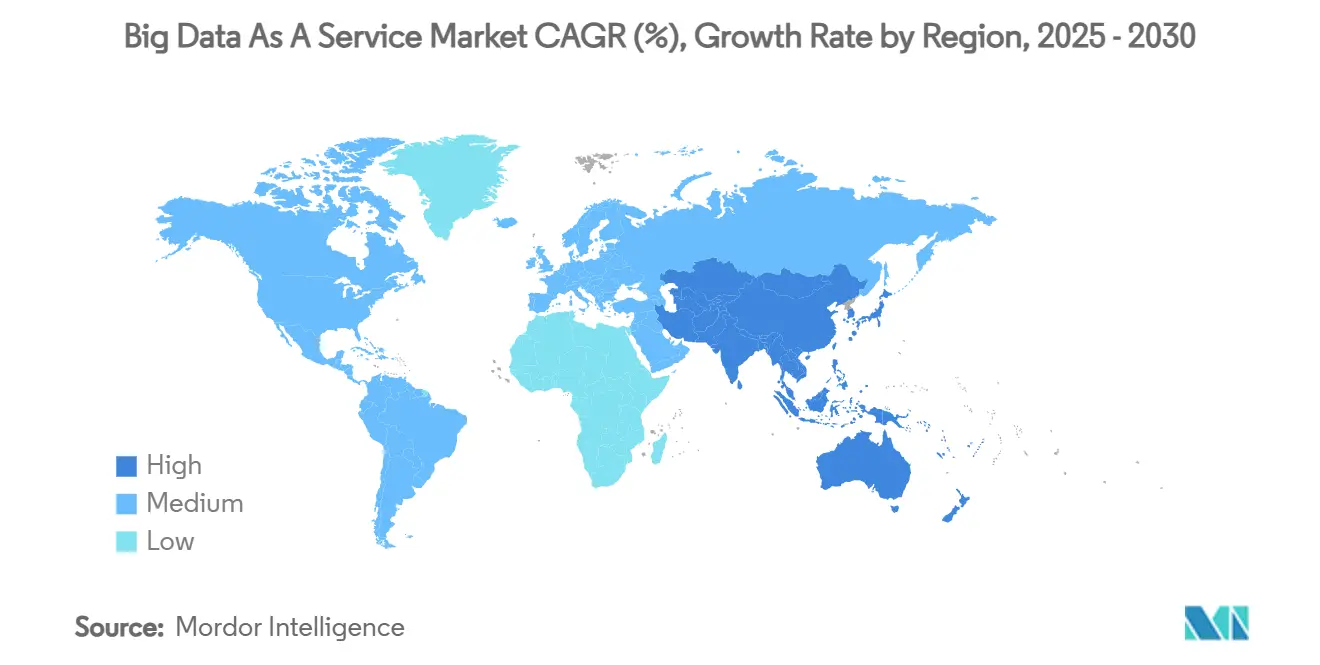

- Par géographie, l'Amérique du Nord un commandé 39% des revenus mondiaux en 2024 ; l'Asie-Pacifique progresse à un TCAC de 27,85% jusqu'en 2030.

- AWS, Microsoft Azure, et Google Cloud ont détenu ensemble environ 70% de la part de marché du big Données En tant que service en 2024.

Tendances et perspectives mondiales du marché du Big Données En tant que service

Analyse d'impact des moteurs

| Moteur | (~) % Impact sur les prévisions TCAC | Pertinence géographique | Calendrier d'impact |

|---|---|---|---|

| Adoption cloud et volumes de données explosifs | +4.2% | Mondiale, forte en Amérique du Nord et APAC | Moyen terme (2-4 ans) |

| Demande d'analyses prêtes pour l'IA générative | +5.1% | Amérique du Nord et UE en tête, APAC rattrapant | Moyen terme (2-4 ans) |

| Tissus de données edge-to-cloud pour les secteurs IoT | +2.9% | Hubs manufacturiers d'Allemagne, Chine et États-Unis | Long terme (≥ 4 ans) |

| Modèles de tarification à la consommation liés aux FinOps | +1.7% | Axé sur l'entreprise, principalement dans les marchés développés | Court terme (≤ 2 ans) |

| Alternatives rentables aux piles big Données sur site | +3.8% | Mondiale, particulièrement marchés émergents en APAC et MEA | Court terme (≤ 2 ans) |

| Règles de localisation des données alimentant les nœuds BDaaS régionaux | +2.3% | UE (GDPR), Chine, Inde, émergentes en Amérique latine | Long terme (≥ 4 ans) |

| Source: Mordor Intelligence | |||

Adoption cloud et volumes de données explosifs

Les organisations génèrent maintenant 2,5 quintillions d'octets chaque jour, des volumes qui dépassent les limites pratiques des clusters sur site.[2]Oracle Corp., "Why Données volume is exploding," oracle.comLes fabricants comme 3M ont réduit le temps de détection d'anomalies de 40% après avoir installé Azure SQL Edge sur les lignes de production, montrant l'impact opérationnel du traitement élastique. Les dépenses cloud mondiales annuelles ont dépassé 825 milliards USD en 2025, et 85% des entreprises utilisent des environnements multi-cloud pour soutenir les projets d'analyse. Les économies sont évidentes : maintenir des fermes Hadoop locales peut coûter 2-5 millions USD par an, tandis que BDaaS basé sur l'utilisation s'adapte strictement à la taille de la charge de travail. À la périphérie du réseau, les capteurs IoT produisent plus de données que les pipelines traditionnels ne peuvent transporter, forçant les entreprises à adopter des architectures distribuées qui maintiennent le calcul près de la source tout en synchronisant avec les plateformes d'analyse cloud.

Demande d'analyses prêtes pour l'IA générative

Les grands modèles de langage siègent maintenant à côté des moteurs SQL dans la plupart des feuilles de route d'entreprise. Les institutions bancaires estiment 200-340 milliards USD de nouveaux profits annuels une fois que l'IA générative sera pleinement opérationnelle, conduisant à de lourds investissements BDaaS pour le traitement de données non structurées. Snowflake attribue 38% de ses revenus fiscaux 2024 de 2,67 milliards USD aux charges de travail IA et s'est associé avec Anthropic, NVIDIA, et Microsoft pour intégrer l'entraînement IA directement dans son cloud de données. AWS rapporte déjà des taux de fonctionnement IA de plusieurs milliards de dollars, soulignant l'élan vers des plateformes qui peuvent ingérer, transformer et servir des données aux pipelines ML dans une seule Localisation. La génération augmentée par récupération monétise davantage les documents d'entreprise, créant de nouveaux flux de revenus à partir de bibliothèques de contenu dormantes.

Tissus de données edge-to-cloud pour les secteurs riches en IoT

L'IoT industriel impose des décisions à faible latence sur site tout en conservant des analyses approfondies dans le cloud. Siemens note que les tissus hybrides réduisent les coûts de réseau et supportent le contrôle en temps réel dans les usines automobiles.[3]Siemens AG, "Industrial edge success stories," siemens.com Dans l'énergie, les architectures edge ont réduit les temps d'arrêt des équipements de 25% grâce à la détection d'anomalies au niveau milliseconde conduite localement avant d'envoyer des insights par lots aux moteurs centralisés. Les sites pharmaceutiques ont réduit les frais de transmission de données de 60% avec les analyses edge, prouvant le cas économique. Les essais académiques rapportent 96,14% de précision de suivi dans les systèmes de fabrication distribués, confirmant que les cadres hybrides peuvent égaler la précision des modèles entièrement centralisés tout en allégeant les charges de bande passante. À mesure que les flottes IoT se multiplient, le marché du big Données En tant que service gagne un canal de croissance durable.

Modèles de tarification à la consommation liés aux FinOps

Les entreprises ont économisé un total combiné de 21 milliards USD en 2025 en instituant des équipes FinOps chargées d'affiner l'utilisation cloud. Le schéma de paiement à l'usage de Snowflake un généré 131% de rétention de revenus nets parce que les clients mettent à l'échelle les charges de travail sans renégocier les licences. La moitié des grandes entreprises ont maintenant formalisé des départements FinOps, reflétant la complexité des factures multi-fournisseurs et les pics de coûts liés aux cycles d'inférence IA. AWS un étendu les périodes de dépréciation des serveurs et introduit une facturation GPU granulaire qui s'adapte aux rafales d'entraînement de modèles irrégulières. Pour les charges de travail d'analyse variables, les termes de consommation éliminent le gaspillage moyen de 27% observé dans les contrats à capacité fixe, solidifiant l'attrait de BDaaS parmi les équipes dirigeantes axées sur la finance.

Analyse d'impact des contraintes

| Contrainte | (~) % Impact sur les prévisions TCAC | Pertinence géographique | Calendrier d'impact |

|---|---|---|---|

| Risques de confidentialité des données et de cybersécurité | -2.1% | Mondiale, accentuée dans les secteurs réglementés | Moyen terme (2-4 ans) |

| Écart de talents en FinOps et ingénierie des données | -2.7% | Amérique du Nord et Europe occidentale | Moyen terme (2-4 ans) |

| Complexité d'intégration héritée | -1.8% | Amérique du Nord et Europe avec infrastructure vieillissante | Court terme (≤ 2 ans) |

| Examen de l'empreinte carbone sur les centres de données hyperscale | -1.4% | UE en tête, s'étendant à l'Amérique du Nord et APAC | Long terme (≥ 4 ans) |

| Source: Mordor Intelligence | |||

Risques de confidentialité des données et de cybersécurité

Soixante-quinze pour cent des pays appliquent des mandats de localisation qui fragmentent les architectures cloud et gonflent les dépenses opérationnelles. Les règles qui se chevauchent du GDPR, du CSL chinois et du US CLOUD Act forcent les entreprises multinationales à construire des couches de gouvernance des données complexes, élevant le coût total de possession jusqu'à 25%. Les institutions financières doivent en outre stocker les données transactionnelles sur le territoire national, restreignant les options de fournisseurs et augmentant les cycles d'approvisionnement. Ces obstacles ralentissent certaines migrations mais les inversent rarement ; les fournisseurs offrent de plus en plus des clusters spécifiques à la région et des clauses contractuelles qui adressent la variance légale, tempérant le vent contraire mais ne l'éliminant pas.

Écart de talents en FinOps et ingénierie des données

Cinquante-huit pour cent des opérateurs de centres de données peinent à embaucher des professionnels qui mélangent l'insight comptable avec les compétences d'architecture cloud.[4]IEEE Spectrum, "Données-center staffing survey," ieee.org Les États-Unis ont ajouté 4,7 millions d'emplois de centres de données depuis 2017, mais les vacances persistent alors que les cas d'usage IA appellent à un savoir-faire d'optimisation plus profond. Les salaires dépassent 200 000 USD dans les hubs majeurs, une prime qui gonfle les budgets de projet et peut retarder les déploiements BDaaS de mois. L'expertise en gouvernance des données et conformité est également rare, augmentant le risque de mauvaises configurations qui violent les lois régionales. Les programmes de formation s'étendent, mais pour le court à moyen terme l'écart de talents reste un frein mesurable sur le marché du big Données En tant que service.

Analyse des segments

Par modèle de service : Les plateformes d'analyse stimulent la transformation prête pour l'IA

Hadoop-en tant que service un conservé 42% du marché du big Données En tant que service en 2024, indiquant que le traitement par lots et les architectures de lac de données conservent encore de la valeur pour les entreprises établies. Cependant, Analytique-en tant que service devrait croître à un TCAC de 30,61%, le rythme le plus rapide parmi les offres, alors que les entreprises favorisent les environnements gérés qui fusionnent les tableaux de bord BI, les carnets ML et la recherche vectorielle sans maintenance de cluster. En 2025, le segment d'analyse un capturé 50% de part de la taille du marché du big Données En tant que service pour les dépenses supplémentaires et devrait élargir son avance jusqu'en 2030. Données Platform-en tant que service reste pertinent dans les scénarios réglementés qui nécessitent des contrôles de gouvernance personnalisés, occupant un terrain d'entente entre l'infrastructure brute et les suites d'analyse de bout en bout.

Les clients mesurent de plus en plus le succès par le temps d'insight plutôt que par l'utilisation du matériel. Le lancement de Cortex AISQL par Snowflake signale un futur où un analyste peut interroger les LLM avec un langage simple et recevoir des réponses gouvernées depuis le même panneau de verre qui stocke les données transactionnelles. Cette convergence floute la division historique entre ETL, entreposage et analyse, poussant les fournisseurs à consolider les fonctionnalités. Sur la période de prévision, le marché du big Données En tant que service pivotera donc du branding axé sur l'infrastructure vers des propositions de valeur construites autour de l'immédiateté du support de décision.

Note: Parts de segments de tous les segments individuels disponibles à l'achat du rapport

Par déploiement : Les architectures hybrides accélèrent les stratégies multi-cloud

Le cloud public un commandé 63% des revenus en 2024, stimulé par la tarification des hyperscalers, mais le cloud hybride augmentera le plus rapidement à un TCAC de 29,51%. Les organisations cherchent la flexibilité de garder les enregistrements sensibles dans des zones privées tout en faisant éclater l'analyse vers la périphérie publique pendant les pics de demande. Les options hybrides atténuent également le verrouillage fournisseur et supportent la conformité quand 75% des juridictions imposent des règles de résidence des données. En conséquence, la taille du marché du big Données En tant que service pour les solutions hybrides devrait plus que tripler entre 2025 et 2030.

Les architectures multi-cloud sont maintenant mainstream : 85% des entreprises emploient au moins deux fournisseurs pour les tâches big Données. L'intégration récente de Snowflake avec les fichiers Apache Iceberg à travers AWS, Azure et Google Cloud permet des requêtes identiques sur n'importe quel lieu, encourageant la portabilité des charges de travail. Pour les usines avec des passerelles IoT, les dispositions hybrides traitent les scores d'anomalie sur le matériel local, puis transmettent les agrégats aux modèles cloud pour la construction de tendances historiques. De tels modèles ancreront les déploiements hybrides comme l'épine dorsale de l'analyse de nouvelle génération.

Note: Parts de segments de tous les segments individuels disponibles à l'achat du rapport

Par secteur d'utilisateur final : La transformation de la santé accélère la médecine numérique

BFSI un détenu 28% du marché du big Données En tant que service en 2024. Le scoring de fraude en temps réel, le trading algorithmique et la surveillance de conformité nécessitent des analyses sous-secondes avec des pistes d'audit. Les banques intègrent maintenant des assistants GenAI qui consomment à la fois les trades structurés et les transcriptions vocales, incitant à davantage de dépenses de cloud de données. La santé et les sciences de la vie devraient croître à un TCAC de 27,91%, le taux le plus élevé, en raison des pipelines de génomique et des plateformes d'essais numériques qui produisent des ensembles de données à l'échelle du pétaoctet. Pour la génomique seule, les courbes de coût de séquençage déclenchent une création de données exponentielle, faisant de BDaaS la seule option pragmatique.

Le commerce de détail, les télécoms et la fabrication restent des contributeurs importants. Les marchands en ligne utilisent la segmentation pilotée par IA pour augmenter les tailles de panier tout en réduisant les ruptures de stock de 31-52%. Les fabricants comme 3M exploitent l'analyse edge pour l'assurance qualité en ligne, rétrécissant les taux de défaut. Les agences gouvernementales emploient BDaaS pour gérer la télémétrie de cybersécurité et les dossiers de service citoyen, bien que les cycles budgétaires tempèrent la croissance pure. Au fil du temps, la convergence des LLM verticaux, de la télémétrie IoT et des réglementations de confidentialité diversifiera les revenus au-delà de l'ancrage BFSI actuel.

Analyse géographique

L'Amérique du Nord un contrôlé 39% du marché du big Données En tant que service en 2024, soutenue par des fournisseurs cloud enracinés, le financement de capital-risque et les cultures d'affaires axées sur les données. Les entreprises aux États-Unis et au Canada ont été des adopteurs précoces et se concentrent maintenant sur l'affinement des pratiques FinOps pour dompter les factures de calcul IA qui s'emballent. L'Europe suit, propulsée par les obligations GDPR qui favorisent les services gérés capables de garantir l'auditabilité. Malgré des règles de confidentialité strictes, la région croît encore en pourcentages à deux chiffres moyens parce que les fournisseurs certifient les clusters régionaux et la souveraineté des clés de chiffrement.

L'Asie-Pacifique est le meneur, projeté pour s'étendre à un TCAC de 27,85%. Les gouvernements en Chine, Inde et Asie du Sud-Est championne les programmes cloud nationaux tandis que la numérisation manufacturière accumule de nouvelles données dans les pipelines BDaaS. Les hyperscalers locaux tels qu'Alibaba Cloud et Tencent Cloud investissent dans des zones de disponibilité trans-régionales, supprimant les pénalités de latence autrefois liées aux fournisseurs mondiaux. Le Japon et la Corée du Sud, adopteurs précoces IoT, expérimentent maintenant avec GenAI de qualité entreprise construit sur des cadres de tutelle de données régionaux.

L'Amérique latine et le Moyen-Orient et l'Afrique sont plus tôt dans la courbe mais montrent une croissance absolue prometteuse. Les entreprises fintech brésiliennes et les détaillants mexicains déplacent les charges de travail vers BDaaS parce que les budgets d'investissement ne peuvent pas supporter de grands clusters auto-hébergés. Les producteurs de pétrole du Golfe exploitent des nœuds edge BDaaS hybrides sur les plates-formes pour la maintenance prédictive, tandis que les télécoms africains tirent parti de la tarification à la consommation pour lancer des programmes d'analyse client sans précharger le capital. Collectivement, ces marchés émergents contribuent des revenus supplémentaires qui élargissent l'empreinte mondiale du marché du big Données En tant que service.

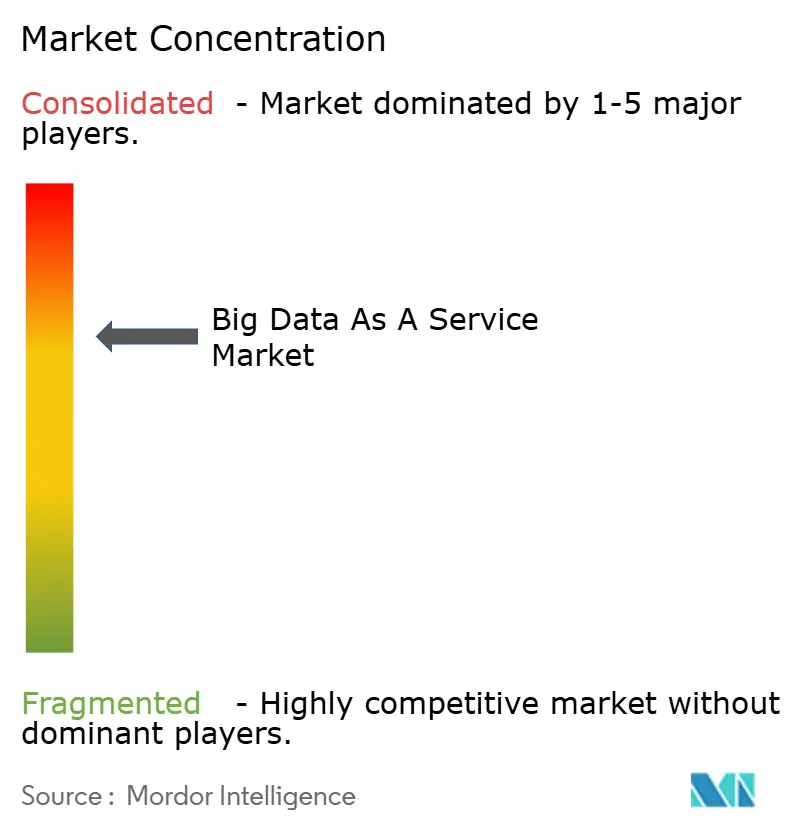

Paysage concurrentiel

Le marché penche vers un trio d'hyperscalers-AWS, Microsoft Azure et Google Cloud-avec une part combinée estimée à 70%. AWS maintient une avance de 31% grâce à l'étendue des services et la loyauté des développeurs. Microsoft tire parti des intégrations Office et Dynamics pour convertir les données de productivité en abonnements d'analyse Azure, tandis que Google courtise les entreprises nativement numériques avec des accélérateurs IA et une posture open source. Snowflake et Databricks concurrencent au niveau de la plateforme, livrant une tarification basée sur la consommation, la neutralité à travers les clouds et l'outillage ML intégré.

Les fusions et acquisitions se sont intensifiées à travers 2025. Salesforce un offert 8 milliards USD pour Informatica pour intégrer les workflows d'intégration de données dans les pipelines CRM, et IBM un fermé son achat de DataStax pour ajouter l'échelle NoSQL à watsonx.Données. Snowflake un dépensé 250 millions USD sur Crunchy Données pour injecter la compatibilité PostgreSQL et attirer les charges de travail transactionnelles. Les partenariats sont également stratégiques : Databricks un signé un pacte de cinq ans avec Anthropic pour intégrer les modèles Claude dans son service, tandis que Palantir un arrangé une collaboration d'analyse énergétique de 100 millions USD pour sécuriser une alimentation plus propre pour les centres de données. Ces mouvements illustrent la convergence sur des écosystèmes natifs IA, verticalisés plutôt que le stockage et le calcul commoditisés.

Les challengers spécialistes visent des coins sensibles à la latence tels que l'analyse de logs en temps réel et le calcul préservant la confidentialité. Les startups de plateforme edge intègrent des nœuds légers en usine avec des plans de requête cloud, faisant appel aux fabricants méfiants des pannes de cloud public. Pendant ce temps, les coalitions open source autour d'Apache Iceberg, Delta Lake et des bibliothèques polars pressent les incumbents à rester interopérables. La concurrence de prix persiste, mais la différenciation dépend de plus en plus de la complétude du workflow IA, de la gouvernance intégrée et de l'expérience développeur.

Leaders de l'industrie du Big Données En tant que service

-

Amazon Inc.,

-

Google LLC

-

Microsoft Corporation

-

IBM Corporation

-

Oracle Corporation

- *Avis de non-responsabilité : les principaux acteurs sont triés sans ordre particulier

Développements récents de l'industrie

- Mai 2025 : Salesforce un signé un accord définitif pour acquérir Informatica pour 8 milliards USD, créant une plateforme intégrée de gestion de données pour les workflows CRM activés par IA.

- Juin 2025 : Snowflake un acquis Crunchy Données pour environ 250 millions USD, ajoutant des services PostgreSQL à son AI Données Cloud.

- Mai 2025 : IBM un clôturé son acquisition de DataStax, mélangeant la technologie NoSQL avec watsonx.Données pour améliorer les pipelines IA d'entreprise.

- Juin 2025 : Palantir Technologies un annoncé un partenariat de 100 millions USD avec une startup d'énergie nucléaire pour fournir de l'énergie neutre en carbone pour l'analyse de centres de données.

Portée du rapport mondial sur le marché du Big Données En tant que service

Le big Données En tant que service (BDaaS) est la livraison d'outils d'analyse statistique ou d'informations par un fournisseur externe qui aide les organisations à comprendre et utiliser les insights de grands ensembles d'informations pour gagner un avantage concurrentiel.

Le marché du big Données En tant que service est segmenté par type de déploiement (sur site, cloud), utilisateur final (télécoms et IT, énergie et électricité, BFSI, santé, commerce de détail), et géographie (Amérique du Nord, Europe, Asie-Pacifique, Amérique latine, et Moyen-Orient et Afrique).

Les tailles et prévisions de marché sont fournies en termes de valeur (USD) pour tous les segments ci-dessus.

| Hadoop-as-a-Service (HaaS) |

| Analytics-as-a-Service (AaaS) |

| Data Platform-as-a-Service (DPaaS) |

| Cloud public |

| Cloud privé |

| Cloud hybride |

| BFSI |

| IT et télécommunications |

| Santé et sciences de la vie |

| Commerce de détail et e-commerce |

| Fabrication |

| Énergie et électricité |

| Gouvernement et secteur public |

| Amérique du Nord | États-Unis |

| Canada | |

| Mexique | |

| Amérique du Sud | Brésil |

| Argentine | |

| Reste de l'Amérique du Sud | |

| Europe | Allemagne |

| Royaume-Uni | |

| France | |

| Russie | |

| Reste de l'Europe | |

| Asie-Pacifique | Chine |

| Inde | |

| Japon | |

| Corée du Sud | |

| ASEAN | |

| Reste de l'Asie-Pacifique | |

| Moyen-Orient | CCG |

| Turquie | |

| Reste du Moyen-Orient | |

| Afrique | Afrique du Sud |

| Nigéria | |

| Reste de l'Afrique |

| Par modèle de service | Hadoop-as-a-Service (HaaS) | |

| Analytics-as-a-Service (AaaS) | ||

| Data Platform-as-a-Service (DPaaS) | ||

| Par déploiement | Cloud public | |

| Cloud privé | ||

| Cloud hybride | ||

| Par secteur d'utilisateur final | BFSI | |

| IT et télécommunications | ||

| Santé et sciences de la vie | ||

| Commerce de détail et e-commerce | ||

| Fabrication | ||

| Énergie et électricité | ||

| Gouvernement et secteur public | ||

| Par géographie | Amérique du Nord | États-Unis |

| Canada | ||

| Mexique | ||

| Amérique du Sud | Brésil | |

| Argentine | ||

| Reste de l'Amérique du Sud | ||

| Europe | Allemagne | |

| Royaume-Uni | ||

| France | ||

| Russie | ||

| Reste de l'Europe | ||

| Asie-Pacifique | Chine | |

| Inde | ||

| Japon | ||

| Corée du Sud | ||

| ASEAN | ||

| Reste de l'Asie-Pacifique | ||

| Moyen-Orient | CCG | |

| Turquie | ||

| Reste du Moyen-Orient | ||

| Afrique | Afrique du Sud | |

| Nigéria | ||

| Reste de l'Afrique | ||

Questions clés répondues dans le rapport

Quelle est la taille projetée du marché du big Données En tant que service d'ici 2030 ?

Il devrait atteindre 141,71 milliards USD d'ici 2030, croissant à un TCAC de 27,81%.

Quelle région se développe le plus rapidement sur le marché du big Données En tant que service ?

L'Asie-Pacifique montre le TCAC de prévision le plus élevé à 27,85% jusqu'en 2030, propulsée par la numérisation manufacturière et des services financiers.

Quel modèle de service gagne en momentum ?

Analytique-en tant que service présente la montée la plus rapide à un TCAC de 30,61% alors que les entreprises migrent de la gestion d'infrastructure vers des plateformes prêtes pour l'IA.

Pourquoi les pratiques FinOps sont-elles importantes pour les adopteurs BDaaS ?

Les entreprises ont économisé 21 milliards USD en 2025 en optimisant les dépenses cloud basées sur la consommation, validant le besoin d'équipes FinOps dédiées.

Quelle est la principale contrainte sur le marché du big Données En tant que service ?

La réglementation de confidentialité des données fragmente les déploiements et peut ajouter jusqu'à 25% aux coûts de possession, surtout pour les multinationales opérant à travers les juridictions.

À quel point la concurrence fournisseur est-elle concentrée ?

Les trois principaux clouds détiennent environ 70% de part, donnant un score de concentration de marché de 6 qui signale une dominance modérée mais non écrasante.

Dernière mise à jour de la page le: