米国の人工知能(AI)最適化データセンター市場分析:Mordor Intelligence社

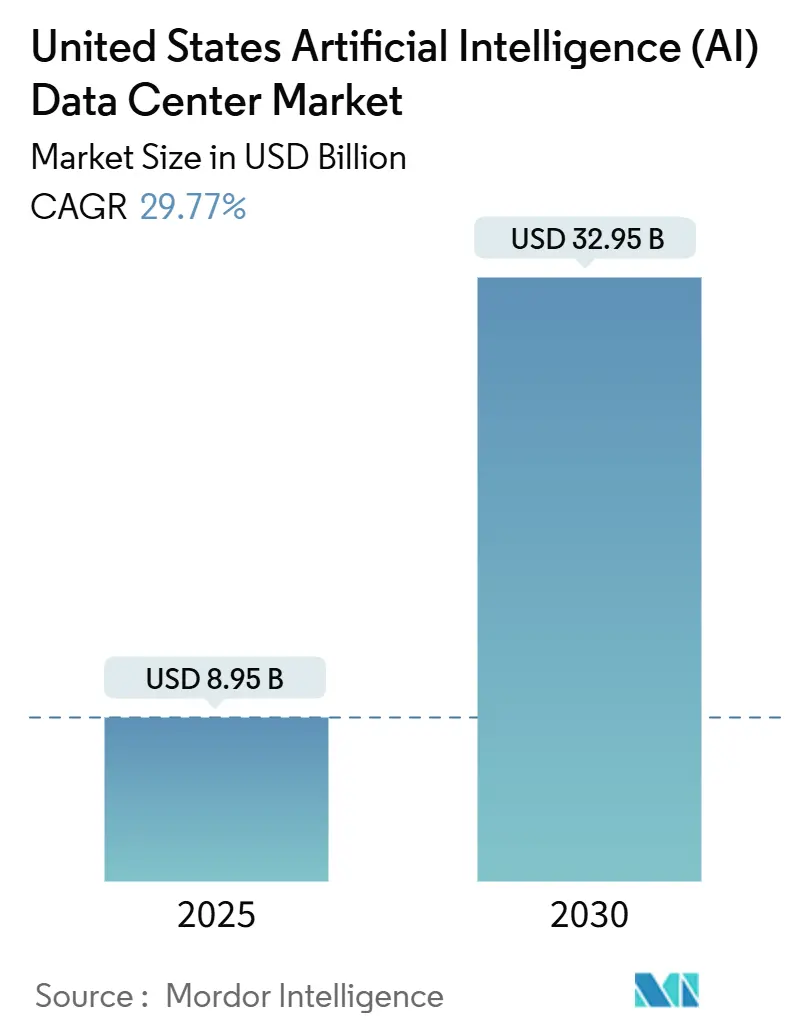

米国の人工知能データセンター市場規模は2025年に89.5億米ドルと推定され、予測期間(2025-2030年)のCAGRは29.77%で、2030年には329.5億米ドルに達すると予測される。

米国のデータセンターは、人工知能の台頭により大きな変貌を遂げており、インフラ、電力、冷却システムに対するこれまでにない需要が高まっている。具体的な市場規模は不明だが、投資規模はこの変化の大きさを浮き彫りにしている。大手ハイテク企業は2024年、AIとクラウド・コンピューティング・インフラに総額2000億米ドル以上を投じており、この数字は2025年には2500億~3000億米ドルに達するとの予測もある。AIワークロードは、従来のアプリケーションの10~20倍のコンピューティングパワーを必要とするため、業界全体の設備設計、電力ニーズ、冷却戦略を根本的に変えつつある。

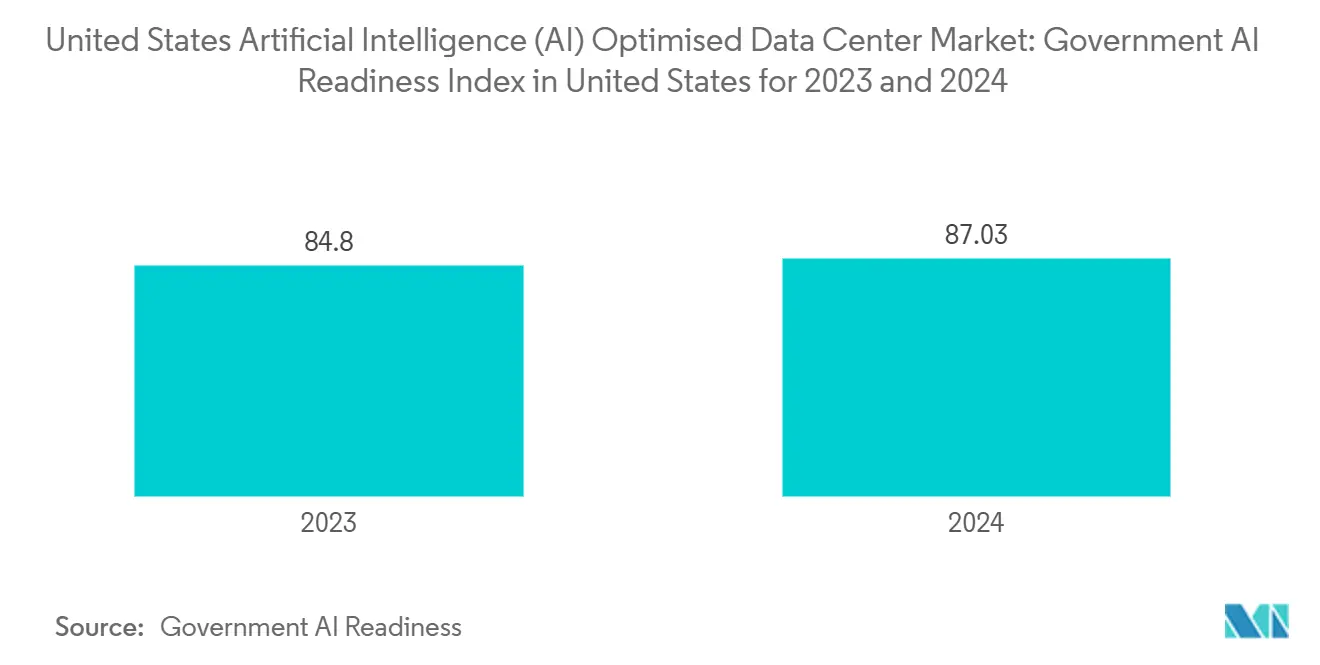

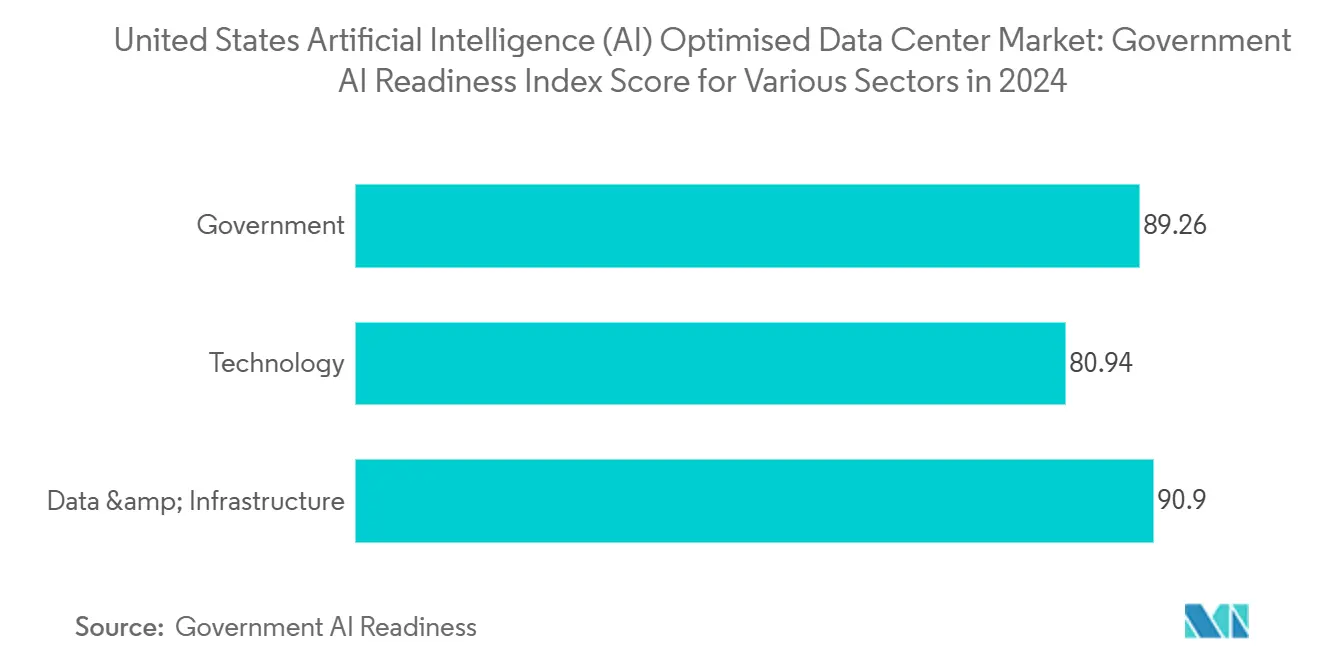

米国政府は、重大な課題に対処しながらAIインフラ開発を加速させるため、いくつかの戦略的イニシアチブを導入した。2025年1月、バイデン大統領は、連邦政府の土地を利用可能にし、2025年2月28日までに新しいAIデータセンターのための少なくとも6つの場所を特定するよう各省庁に指示することで、AIデータセンター建設を促進する大統領令に署名した。半導体製造に527億米ドルの連邦補助金を提供するCHIPS法は、AIアクセラレーション・ハードウェアのより強靭なサプライチェーンを強化するもので、2024年時点で4500億米ドルを超える民間投資が発表されている。さらに、提案されている「アメリカ・フォワード税額控除は、AIデータセンターへの国内投資を奨励することを目的としているが、その具体的な内容はまだ開発中である。

ホワイトハウスはまた、AIデータセンター・インフラストラクチャーに関するタスクフォースを設置し、開発を米国の経済的・国家安全保障的利益に合致させることを目的としている。国家安全保障に関する覚書では、クリーン・エネルギーとデータ・インフラの許可プロセスの合理化を強調している。AIデータセンターのエコシステムへの投資は歴史的なレベルに達しており、プライベート・エクイティ企業は2022年1月以来、このセクターに約2000億米ドルを投資し、450社以上を買収している。2024年だけでも、プライベート・エクイティはこのセクターのMAの80~90%を占め、95件の取引に1150億米ドルが費やされました。

このセクターの主な取引には、BlackstoneによるAirTrunkの150億4,000万米ドルの買収や、KKRによるCyrusOneの150億米ドルの買収などがある。ハイパースケール分野では特に積極的な投資が行われており、OpenAI、ソフトバンク、オラクルのStargate合弁会社は、テキサス州のAIデータセンター・インフラに1000億ドルの投資を計画している。同様に、アマゾンは、キャパシティーの制約が懸念される中、データセンターを拡張するために2025年に1,000億米ドルを投資する計画を発表した。

このような投資の急増により、データセンターの経済性は再構築されつつあり、AI主導の需要は業界の状況を根本的に変えている。インフラ、電力、冷却システムへの注目は、データセンター市場の革新と成長の推進におけるAIの重要な役割を強調している。この分野の進化に伴い、官民双方の関係者は、この変革的なシフトがもたらす課題に対処し、機会を活用するために取り組んでいる。

米国のハイパースケーラーによるジェネレーティブAI GPUクラスタ構築の急増。

米国のAIデータセンター市場は、大手ハイパースケーラーによるAIインフラへの大規模投資に後押しされた、高度なデータセンター容量に対する需要の高まりにより、大きな成長を遂げている。これらの投資は、大規模なGPU導入をサポートするために、より高い電力密度、液体冷却システム、および高度な電力供給設定を必要とすることにより、業界を再構築している。AIワークロード用に設計された設備は割高な価格設定となっており、これらの要件を満たすために特殊な設計が必要となっている。さらに、各社はGPUの割り当てを確保し、市場での地位を強化するためにAIに最適化された施設を開発するため、競争が激化している。2.3%のインパクト値は、これらのハイパースケーラーによる設備投資動向とAIインフラへの重点的な取り組みの分析を反映している。

2025年5月、OpenAI、ソフトバンク、オラクルはStargate合弁事業を発表し、1000億米ドルを投資する予定の大規模なAIデータセンター・プロジェクトのためにテキサス州の用地を選定した。この施設にはNvidiaの最新AIチップが統合され、世界最大級のAIコンピューティング・インフラが構築される。

米国CHIPS法のインセンティブが国内AIチップサプライチェーンを加速させる。

CHIPS法は、AIチップ生産の経済性と地理を変えることで半導体市場を再構築しており、データセンター業界に大きな影響を与えている。このイニシアチブは、国内製造の資本コストを引き下げるための直接補助金、特殊なAIプロセッサの技術革新を進めるための研究開発資金、人材不足に対処するための労働力開発プログラムなど、さまざまな施策を通じて運営されている。527億米ドルの連邦政府資金が4500億米ドルを超える民間投資を促進することで、このプログラムは、重要なAIインフラ・コンポーネントのための、より弾力性があり、革新的で、地理的に集中したサプライ・チェーンを育成している。

AIデータセンター市場は、技術進歩を加速させながらサプライチェーンの脆弱性に対処するCHIPS法によって大きな変化を経験している。国内製造能力の開発により、高度なAIチップのリードタイムが12~18カ月から6~9カ月に短縮され、新たなデータセンター容量の迅速な展開が可能となっている。半導体生産が米国に地理的に集中することで、チップメーカー、パッケージング専門家、データセンター事業者が統合エコシステム内で協業する新たな「シリコンクラスターが形成され、顕著な効率化が達成されている。さらに、CHIPS 法の資金援助による特殊な AI プロセッサの進歩は、特定のワークロードに対して汎用 GPU の 2~3 倍の性能向上をもたらしている。これらのイノベーションにより、性能とエネルギー効率の両方を最適化するヘテロジニアス・コンピューティング・システムを組み込んだ、AIデータセンターの新しいアーキテクチャ設計が可能になります。

2025年4月、インテルはオハイオ州とアリゾナ州に、特に高度なAIアクセラレーター・チップの製造に特化した新たな製造施設を建設するため、CHIPS法に基づく85億米ドルの直接資金援助を受けた。同社は、これらの施設が2026年に生産を開始し、AIプロセッサー専用の月産10万枚を超えるウェハーの製造能力を持つことを発表した。

企業のネットゼロ義務化がAIデータセンターに与える影響

企業の持続可能性へのコミットメントは、AIデータセンターがどのようにエネルギーを調達・管理し、AIワークロードの大幅な電力需要に対応するかを再構築している。企業は科学的根拠に基づく排出削減目標を設定しており、一般的には2030年までにカーボンニュートラル、2040年までに全事業でネットゼロ排出を目標としている。これらのコミットメントは、再生可能エネルギーを大規模に確保するための電力購入契約(PPA)、オンサイト発電への投資、消費を最適化するための高度なエネルギー管理システムなどのメカニズムを通じて実施される。大手ハイテク企業は、AIインフラに電力を供給するために、合わせて25GW以上の新規再生可能エネルギー容量を契約している。

AIデータセンター市場では、エネルギー調達は単なる運用上の必要性ではなく、戦略的要因となっている。先進的な再生可能エネルギー戦略を持つ企業は、長期的な価格の安定、環境意識の高いステークホルダー間でのブランド価値の向上、カーボンプライシングメカニズムの拡大に伴う規制上の位置づけの改善から利益を得ている。持続可能性の要件は、エネルギー効率に優れたコンピューティング・アーキテクチャ、高度な冷却システム、AIを活用したインフラ管理などの技術革新も促しており、エネルギー消費を15~30%削減することができる。これらの進歩は、AIがエネルギー需要を増加させる一方で、より高度なエネルギー最適化を可能にするというサイクルを生み出している。

2025年5月、アマゾン・ウェブ・サービスはネクステラ・エナジー社と、拡大するAIデータセンター業務に電力を供給するため、テキサス州における2GWの新たな太陽光・風力発電容量に関する15年間の電力購入契約(PPA)を締結した。これは、企業の再生可能エネルギー取引としては史上最大規模であり、AWSは、AIワークロードの電力需要の増加にもかかわらず、100%再生可能エネルギーへのコミットメントを維持することができる。

5Gと自律走行車の展開をサポートするAI最適化エッジ展開。

エッジコンピューティング、5Gネットワーク、AIの統合により、計算能力が集中型データセンターからネットワークエッジへと拡張される。専門のマイクロデータセンターがセルタワー、ネットワーク集約ポイント、その他のエッジロケーションに配備され、最小限の待ち時間でデータを処理するAI対応インフラのネットワークを形成している。これらの施設は通常100~500平方フィートと規模が小さく、トレーニングよりも推論ワークロードに最適化されている。電気通信事業者、クラウドプラットフォーム、アプリケーション開発者間のパートナーシップは、これらの導入を推進し、新たなビジネスモデルと収益機会を生み出している。

このシフトは、分散型エッジロケーションを組み込むことでAIデータセンター市場に変革をもたらし、AIインフラのアーキテクチャに大きな影響を与えている。自律走行車、AR(拡張現実)、産業オートメーションなど、ミリ秒単位の処理時間を必要とするレイテンシーに敏感なアプリケーションは、この開発の恩恵を受けている。事業者は、戦略的なエッジロケーションの確保、標準化された展開モデルの拡張、分散したAIワークロードの効率的な管理に注力している。ハイブリッド・アーキテクチャは、レイテンシ、計算ニーズ、エネルギー効率に基づいて、エッジ、地域、中央施設間でワークロードを動的に割り当てるために開発されている。

202,5月、ベライゾンとAWSは、波長ゾーンを米国の15都市に拡大し、合計40カ所にした。これらのエッジ・コンピューティング施設は、自律走行車や拡張現実アプリケーションのAI推論をサポートするように設計されており、従来のクラウド処理と比較して最大80%のレイテンシ削減を達成している。

グリッドの混雑と電力割り当てモラトリアム。

電力インフラの制限は、米国におけるAIデータセンターの成長に影響を与える重要な要因となっており、主要市場でボトルネックを生み出し、拡大戦略を変えている。このような制限は、新規接続を妨げる物理的なグリッド容量の制約、データセンターへの電力割り当てに関する電力会社のモラトリアム、プロジェクトを24~36ヶ月遅らせる可能性のあるインフラ・アップグレードのリードタイム延長などから生じています。AI施設の電力要件は、1サイトあたり100MWを超えることが多く、これは8万世帯の電力需要に相当し、既存の送電網インフラでは対応できない需要となっています。こうした制約は、容量に制約のある市場での割高な価格設定、オンサイト発電のような高価な代替手段、導入の遅れを通じてコストを押し上げている。

2025年5月、ドミニオン・エナジー社は、送電網のひずみの中、バージニア州北部での新しいデータセンター接続を停止した。ワシントン・ポスト紙によると、ドミニオン・エナジー社はラウドン郡におけるデータセンターの新規接続を無期限で一時停止した。同電力会社は、追加容量を収容できるようになるまでに35億米ドルの送電網のアップグレードが必要で、完成は2028年になると見積もっている。

AIの高密度運用に対応できる熟練労働力の不足。

制約の概要専門人材の不足は、AIデータセンターの拡張にとって大きな制約となっており、設計、建設、運用などさまざまな段階に影響を及ぼしている。この問題は、GPUクラスター用の冷却エンジニア、ハイパワーシステム用の電気エンジニア、AIソフトウェアとインフラを管理する運用スペシャリストなど、従来のデータセンター運用とAI特有の要求の両方の専門知識を必要とする職務において顕著である。建設業界では、データセンター・プロジェクトに必要な労働力が約50万人不足しているとWTWは報告している。こうした労働力の制約により、プロジェクトのスケジュールは15~25%延び、必要な報酬が高くなるためコストは10~15%上昇し、新たなAI能力の展開が遅れている。

2025年5月、ウォール・ストリート・ジャーナル紙は、全米の主要なAIインフラ・プロジェクトは、労働力の制約により平均4~6ヶ月の遅れを経験しており、二次市場においては最大9ヶ月の遅れを経験しているプロジェクトもあると報じている。同記事は、液体冷却技術者や高電圧の電気技術者など、専門的な職務に対して30~40%の割増賃金を支払っていると報告する業界幹部を引用している。

米国の人工知能(AI)最適化データセンター市場の動向と洞察

AIインフラをかつてないハイパースケールで拡張

米国におけるAI主導のハイパースケール化はデータセンター市場を再構築しており、大規模な言語モデルや生成的AIワークロードの計算需要に対応するよう特別に設計された施設が登場している。こうしたAIに最適化されたデータセンターは、専用のGPUクラスタと広帯域幅のネットワークファブリックを備えており、AIのトレーニングと推論のための大規模な並列処理を可能にしている。このトレンドは、米国のデータセンター市場に大きな投資とイノベーションを促している。

オープンAI、ソフトバンク、オラクルは2025年5月、AIデータセンター・インフラに1,000億米ドルを投資し、エヌビディアの最新AIチップを統合して世界最大級のAIコンピューティング施設「データセンター・ナレッジを構築することを目指す合弁会社スターゲートの拠点をテキサス州に選定したと発表した。

2025年4月、投資家コンソーシアムは、ペンシルベニア州ホーマーシティに4.5GWの大規模データセンター・キャンパスの計画を発表した。

AIワークロードへの液体冷却の採用が加速

米国のAIデータセンターにおける熱管理革命は、AIアクセラレーター・ハードウェアの異常な発熱に対する重要な対応であり、ラックあたりの熱出力は従来のコンピューティング機器の5~10倍に達する可能性がある。この液冷への移行は、次世代のAIインフラをサポートするために不可欠である。空冷は1ラックあたり約25~30kWで実用的な限界に達するが、最新のAIクラスタは日常的に85kWを超え、2年以内に200~250kWに達すると予測されている。液冷システムは通常、資本支出を30~50%増加させるが、省エネにより運用コストを10~30%削減し、最適な動作温度を維持することでハードウェアの寿命を延ばし、1平方フィート当たりの計算密度を大幅に向上させることができる。

2025年4月現在、データセンターの20%近くが液冷技術を利用しており、40億米ドルを超える市場に貢献している。AIアプリケーションのラック密度が85kWに達し、将来的にはラックあたり200~250kWの要件が必要になると予測される中、採用率は加速している。

2025年3月、米エネルギー省はデータセンターのエネルギー効率を高める革新的な冷却技術に4,000万米ドルを割り当て、持続可能なAIインフラにおける熱管理の重要な役割を強調した。

競争環境

米国のAIチップ市場は、急成長しているこの分野で既存プレーヤーと新規参入プレーヤーがしのぎを削り、かつてない競争が繰り広げられている。Nvidiaは、先進的なGPUとCUDAツールキットを含む包括的なソフトウェアエコシステムを活用し、データセンターにおけるシェア90%以上で圧倒的なリードを維持している。AIニュース。同社の優位性は、AI向けGPUへの早期投資、広く採用されているCUDAプラットフォーム、HopperやBlackwellのような高性能アーキテクチャによって築かれている。しかし、この地位は競争の激化と潜在的な規制当局の監視によって脅かされつつあり、独占禁止法違反の可能性に関する調査がエヌビディアの市場慣行PCアウトレットに影響を及ぼしている。

インテル コーポレーションは、CHIPS法による米国の補助金を活用して国内半導体生産を強化し、Nvidiaに対抗する国産AIチップを開発している。同社の戦略には、CPUs、GPUs、専用アクセラレータを凝集したAIエコシステムに統合することが含まれており、2026年までに新AIチップを量産する計画で、2028年までにAIチップ市場の20%を獲得することを目指している、とBBN Times。アドバンスト・マイクロ・デバイセズ(AMD)も同様に、AIデータセンター市場で競争するためにハードウェアとソフトウェアを強化し、Nvidiaの優位性に挑戦している。同社のMI325Xと今後発売されるMI350シリーズは大きな関心を呼んでおり、AMDは市場シェアを10~15%に拡大することを目指している。ARM Holdings plcは、AIチップ市場における重要なプレーヤーと位置付けられており、同社のアーキテクチャは、そのエネルギー効率と性能特性により、AIアプリケーションへの採用が拡大している。同社のライセンスモデルにより、さまざまなハードウェアプラットフォームでAIの成長から利益を得ることができ、競争環境において独自の地位を築いている。

米国の人工知能(AI)最適化データセンター業界のリーダーたち

NVIDIA Corporation

Intel Corporation

Advanced Micro Devices, Inc.

Cisco Systems, Inc.

ARM Holdings plc

- *免責事項:主要選手の並び順不同

最近の業界動向

- 2025年5月OpenAI、ソフトバンク、オラクルは、AIデータセンター・インフラに1000億米ドルを投資し、Nvidiaの最新AIチップを統合して世界最大級のAIコンピューティング施設を構築することを目指す合弁会社Stargateの拠点をテキサス州に選定したと発表。

- 2025年4月米エネルギー省(DOE)は、人工知能における米国の世界的なリーダーシップを維持するため、AIデータセンターをその土地にあるエネルギー生産施設と併設する計画を発表した。DOEは AI Infrastructure on DOE Lands Request for Information を通じて、オークリッジ国立研究所やアイダホ国立研究所を含む16の候補地でAIインフラを開発・運営するための官民パートナーシップを確立するため、業界関係者からの意見を求めている。このイニシアチブは、AIリーダーシップの推進に関する2025年1月の大統領令に沿ったもので、DOEの既存のインフラ、エネルギー・プロジェクト、スーパーコンピューティング能力を活用し、次世代AI技術の電力とセキュリティの需要を満たす。

米国の人工知能(AI)最適化データセンター市場レポートスコープ

ハイパースケール、コロケーション、エンタープライズ、エッジ施設など、データセンターにおけるAIアプリケーションの全領域を網羅している。分析はハードウェアとソフトウェアを区別してコンポーネントごとに区分されている。ハードウェアには、電力、冷却、ネットワーク、IT機器などが含まれます。ソフトウェア技術には、機械学習、ディープラーニング、自然言語処理、コンピュータビジョンなどが含まれる。また、これらのアプリケーションの地理的分布も評価している。

さらに、持続可能性とカーボンニュートラルの目標に対するAIの影響も評価している。包括的な競合状況を示し、AIをサポートするインフラに従事する市場プレイヤーを詳述し、さまざまなAIデータセンターのタイプで利用されるハードウェアとソフトウェアの両方を網羅する。市場規模は、同市場の製品およびソリューションプロバイダーが生み出す収益で算出し、予測は各セグメントについて10億米ドル単位で示しています。

| CSPデータセンター |

| コロケーションデータセンター |

| その他(エンタープライズおよびエッジ) |

| ハードウェア | 力 |

| 冷却 | |

| IT機器 | |

| その他 | |

| ソフトウェア技術 | 機械学習 |

| ディープラーニング | |

| 自然言語処理 | |

| コンピュータービジョン | |

| サービス - (マネージドサービス、プロフェッショナルサービスなど) |

| データセンターの種類別 | CSPデータセンター | |

| コロケーションデータセンター | ||

| その他(エンタープライズおよびエッジ) | ||

| コンポーネント別 | ハードウェア | 力 |

| 冷却 | ||

| IT機器 | ||

| その他 | ||

| ソフトウェア技術 | 機械学習 | |

| ディープラーニング | ||

| 自然言語処理 | ||

| コンピュータービジョン | ||

| サービス - (マネージドサービス、プロフェッショナルサービスなど) | ||

本レポートで扱われている主な質問

米国の人工知能最適化データセンター市場の規模は?

米国の人工知能最適化データセンター市場規模は、2025年に89.5億ドルに達し、年平均成長率29.77%で成長し、2030年には329.5億ドルに達すると予測される。

現在の米国の人工知能最適化データセンター市場規模は?

2025年には、米国の人工知能最適化データセンター市場規模は89.5億ドルに達すると予測される。

米国の人工知能最適化データセンター市場の主要プレーヤーは?

NVIDIA Corporation、Intel Corporation、Advanced Micro Devices, Inc.、Cisco Systems, Inc.、ARM Holdings plcは米国の人工知能(AI)最適化データセンター市場に進出している主要企業である。

この米国の人工知能最適化データセンター市場は何年をカバーし、2024年の市場規模は?

2024年の米国人工知能最適化データセンター市場規模は62.9億米ドルと推定される。本レポートでは、米国の人工知能最適化データセンター市場の過去の市場規模を2019年、2020年、2021年、2022年、2023年、2024年の各年について調査しています。また、2025年、2026年、2027年、2028年、2029年、2030年の米国人工知能最適化データセンター市場規模を予測しています。

最終更新日:

米国の人工知能(AI)最適化データセンター産業レポート

Mordor Intelligence™ Industry Reportsが作成した2025年米国の人工知能(AI)最適化データセンター市場シェア、規模、収益成長率の統計データです。米国の人工知能(AI)最適化データセンターの分析には、2025年から2030年の市場予測展望と過去の概要が含まれます。この産業分析のサンプルを無料レポートPDFダウンロードで入手できます。